.

O YouTube anunciou vários novos recursos experimentais no final da semana passada, por isso é bastante surpreendente ver o serviço fazendo outro anúncio apenas alguns dias depois.

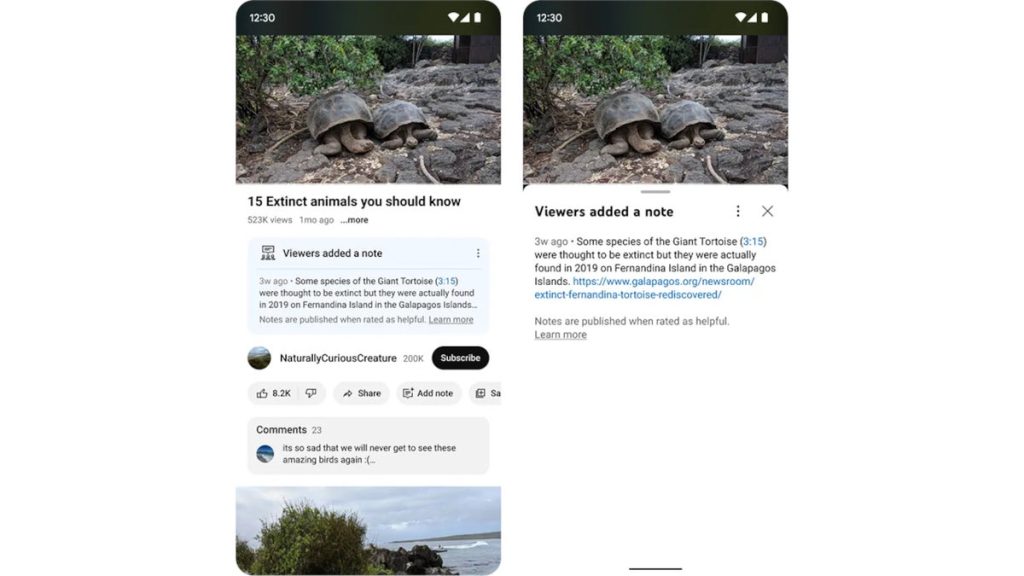

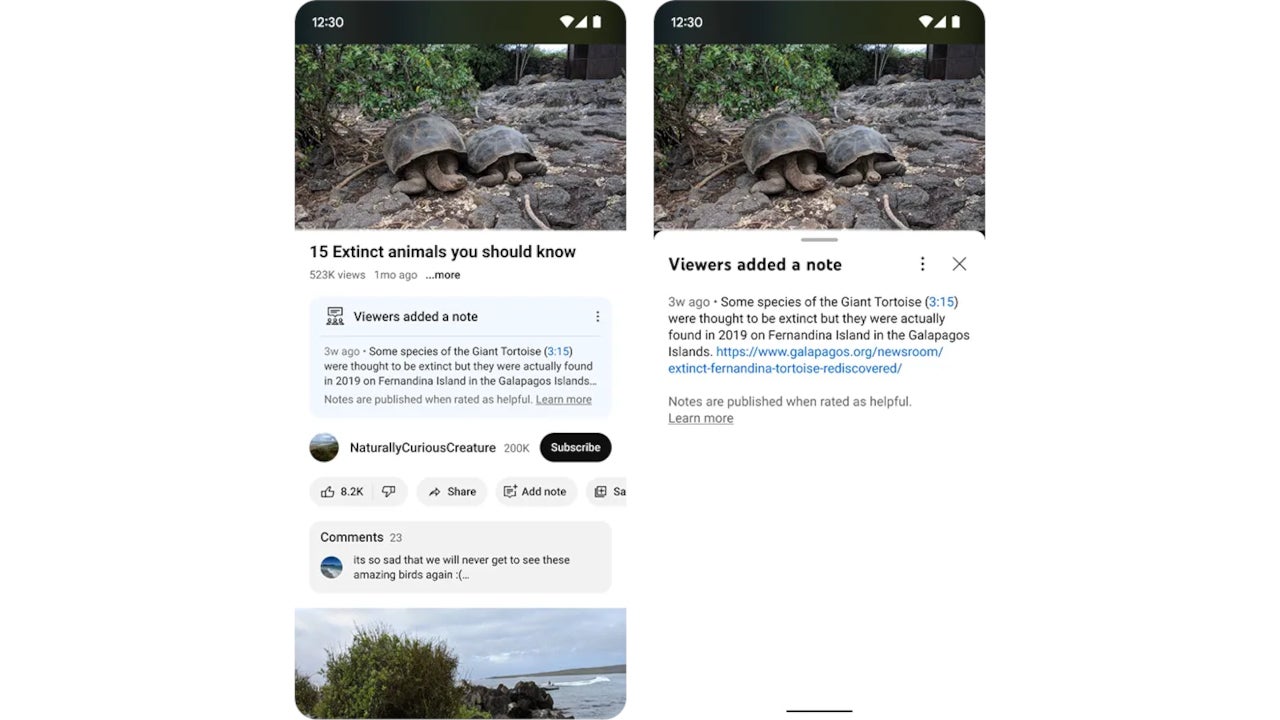

A partir de hoje, os espectadores do YouTube podem verificar os vídeos de seus criadores favoritos adicionando notas que oferecem um contexto relevante e fácil de entender. De acordo com a declaração do YouTube, a capacidade de adicionar notas visa oferecer aos usuários da plataforma uma melhor compreensão do que estão assistindo.

Por exemplo, notas adicionais podem esclarecer quando uma música pretende ser uma paródia, diz o YouTube. Além disso, uma nota adicionada por um visualizador pode indicar quando uma nova versão de um produto em análise estiver disponível.

Por último, mas não menos importante, essas notas são muito úteis quando você deseja que outros espectadores saibam quando filmagens mais antigas são erroneamente (ou propositalmente) retratadas como um evento atual.

Por enquanto, a capacidade de adicionar notas a um vídeo está disponível apenas em dispositivos móveis nos Estados Unidos e no idioma inglês. Também é importante mencionar que o piloto estará disponível para um número limitado de contribuidores elegíveis.

Os convites serão enviados por e-mail ou pelo Estúdio de Criação para aqueles que atenderem aos critérios de elegibilidade, que também incluem ter um canal ativo no YouTube em conformidade com as Diretrizes da comunidade. Veja como essa classificação de notas funcionará:

As notas aparecerão publicamente em um vídeo se forem consideradas amplamente úteis. Será perguntado às pessoas se consideram que uma nota é “útil”, “um pouco útil” ou “inútil” e porquê – por exemplo, se cita fontes de alta qualidade ou se está escrita de forma clara e neutra.

Por fim, o YouTube confirmou que usará um “algoritmo baseado em ponte para considerar essas classificações e determinar quais notas são publicadas.” Este algoritmo foi projetado especificamente para ajudar a identificar notas que são úteis para um “amplo público em todas as perspectivas.”

.