.

Principais conclusões

- Grandes empresas como Open AI, Google, Microsoft e Meta estão investindo em SLMs.

- Os SLMs estão ganhando popularidade em todo o setor e estão melhor posicionados como a IA do futuro.

- Exemplos de SLMs incluem o Google Nano, o Phi-3 da Microsoft e o GPT-4o mini da Open AI.

Large language models (LLMs) entraram em cena com o lançamento do ChatGPT da Open AI. Desde então, várias empresas também lançaram seus LLMs, mas mais empresas agora estão se inclinando para small language models (SLMs).

Os SLMs estão ganhando força, mas o que são e como eles diferem dos LLMs?

O que é um modelo de linguagem pequena?

Um small language model (SLM) é um tipo de modelo de inteligência artificial com menos parâmetros (pense nisso como um valor no modelo aprendido durante o treinamento). Como suas contrapartes maiores, os SLMs podem gerar texto e executar outras tarefas. No entanto, os SLMs usam menos conjuntos de dados para treinamento, têm menos parâmetros e exigem menos poder computacional para treinar e executar.

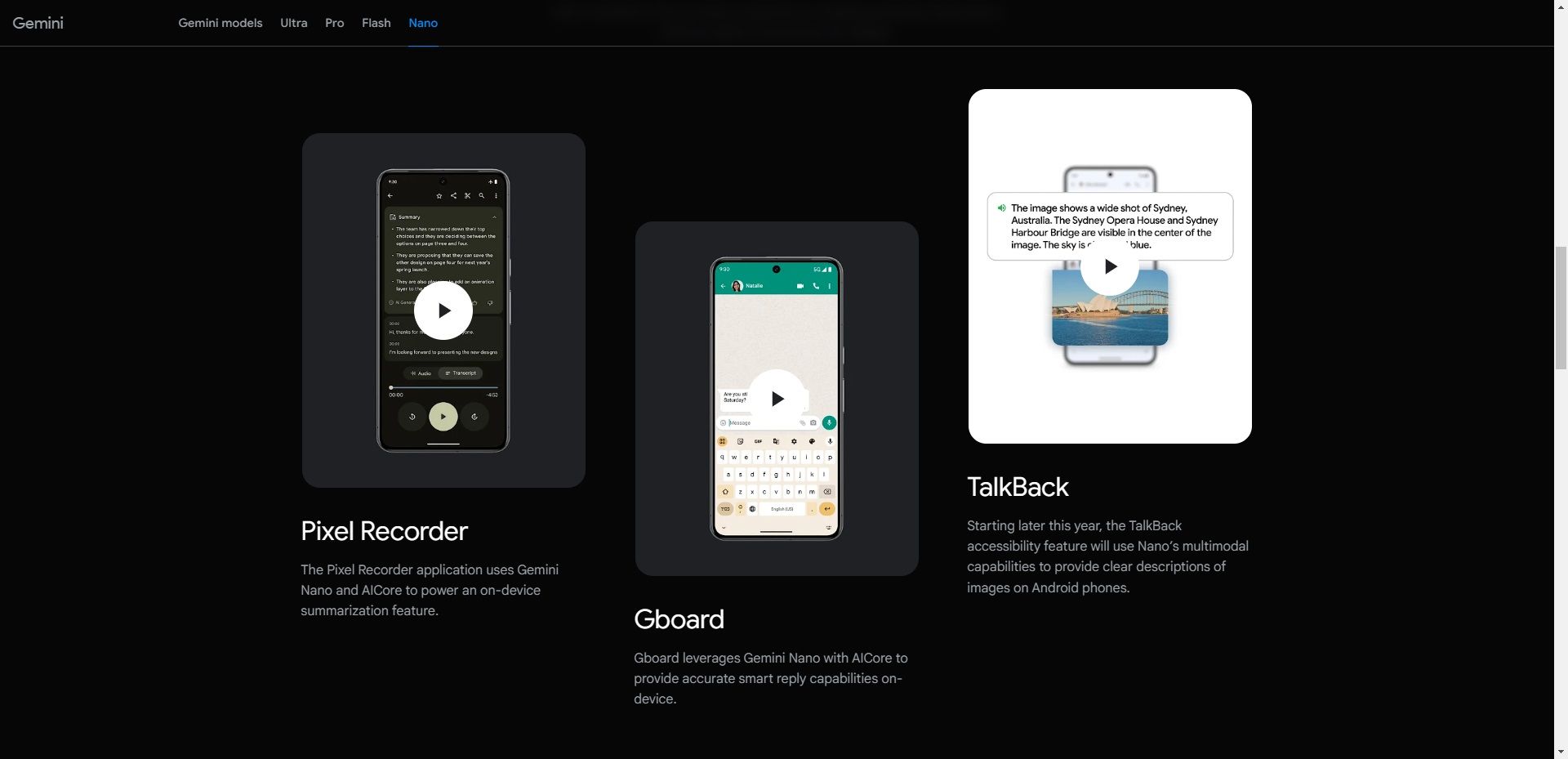

Os SLMs focam em funcionalidades-chave, e seu pequeno footprint significa que eles podem ser implantados em diferentes dispositivos, incluindo aqueles que não têm hardware de ponta, como dispositivos móveis. Por exemplo, o Nano do Google é um SLM no dispositivo construído do zero que roda em dispositivos móveis. Devido ao seu pequeno tamanho, o Nano pode rodar localmente com ou sem conectividade de rede, de acordo com a empresa.

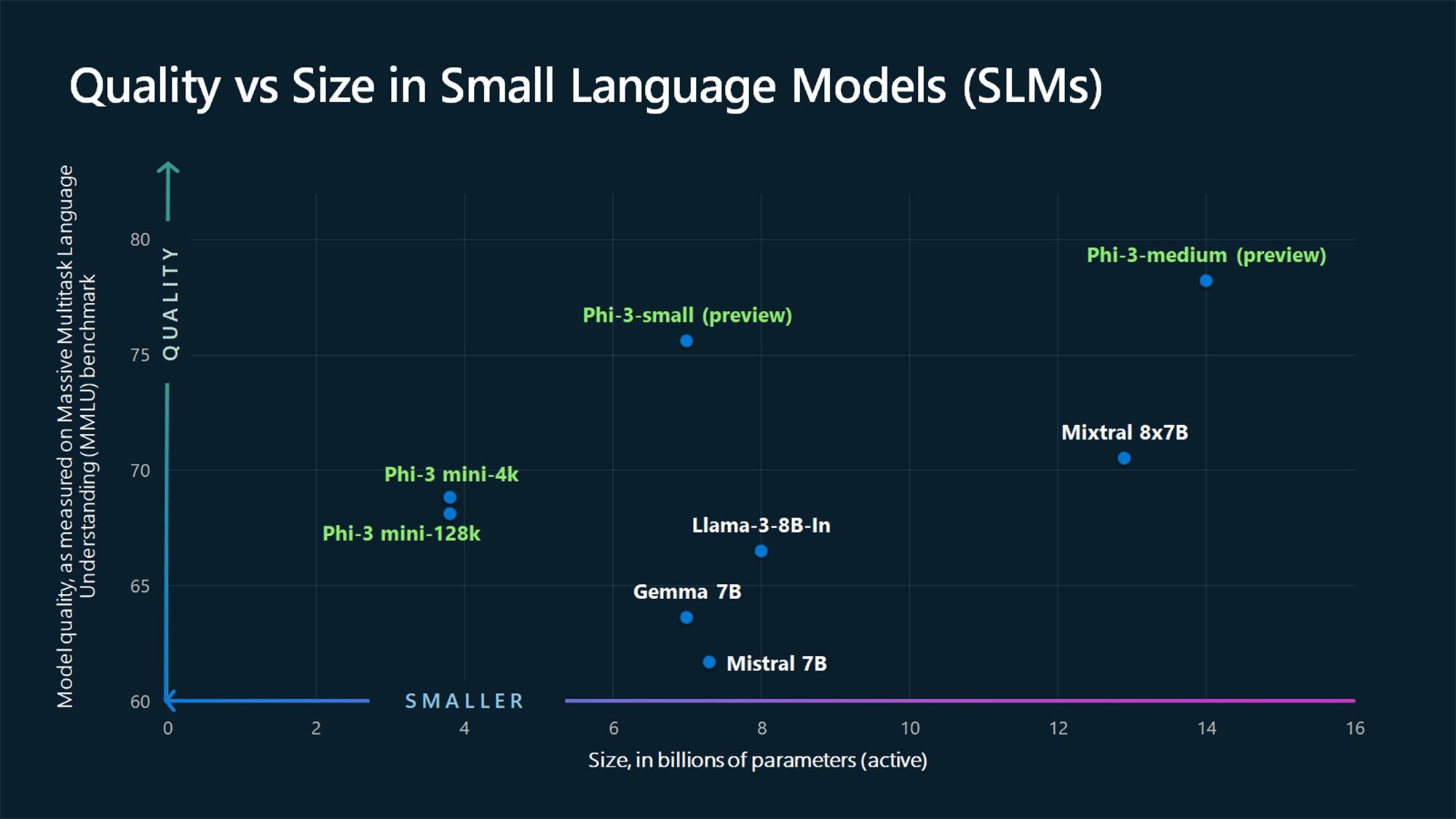

Além do Nano, há muitos outros SLMs de empresas líderes e emergentes no espaço de IA. Alguns SLMs populares incluem o Phi-3 da Microsoft, o GPT-4o mini da OpenAI, o Claude 3 Haiku da Anthropic, o Llama 3 da Meta e o Mixtral 8x7B da Mistral AI.

Outras opções também estão disponíveis, que você pode pensar que são LLMs, mas são SLMs. Isso é especialmente verdadeiro considerando que a maioria das empresas está adotando a abordagem multimodelo de lançar mais de um modelo de linguagem em seu portfólio, oferecendo LLMs e SLMs. Um exemplo é o GPT-4, que tem vários modelos, incluindo GPT-4, GPT-4o (Omni) e GPT-4o mini.

Pequenos modelos de linguagem vs. grandes modelos de linguagem

Ao discutir SLMs, não podemos ignorar seus grandes equivalentes: LLMs. A principal diferença entre um SLM e um LLM é o tamanho do modelo, que é medido em termos de parâmetros.

No momento em que este artigo foi escrito, não havia consenso na indústria de IA sobre o número máximo de parâmetros que um modelo não deve exceder para ser considerado um SLM ou o número mínimo necessário para ser considerado um LLM. No entanto, os SLMs geralmente têm de milhões a alguns bilhões de parâmetros, enquanto os LLMs têm mais, chegando a trilhões.

Por exemplo, o GPT-3, lançado em 2020, tem 175 bilhões de parâmetros (e há rumores de que o modelo GPT-4 tenha cerca de 1,76 trilhão), enquanto os SLMs Phi-3-mini, Phi-3-small e Phi-3-medium de 2024 da Microsoft medem 3,8, 7 e 14 bilhões de parâmetros, respectivamente.

Outro fator diferenciador entre SLMs e LLMs é a quantidade de dados usada para treinamento. SLMs são treinados em quantidades menores de dados, enquanto LLMs usam grandes conjuntos de dados. Essa diferença também afeta a capacidade do modelo de resolver tarefas complexas.

Devido aos grandes dados usados no treinamento, os LLMs são mais adequados para resolver diferentes tipos de tarefas complexas que exigem raciocínio avançado, enquanto os SLMs são mais adequados para tarefas mais simples. Ao contrário dos LLMs, os SLMs usam menos dados de treinamento, mas os dados usados devem ser de maior qualidade para atingir muitas das capacidades encontradas nos LLMs em um pacote pequeno.

Por que os pequenos modelos de linguagem são o futuro

Para a maioria dos casos de uso, os SLMs estão melhor posicionados para se tornarem os modelos tradicionais usados por empresas e consumidores para executar uma ampla variedade de tarefas. Claro, os LLMs têm suas vantagens e são mais adequados para certos casos de uso, como resolver tarefas complexas. No entanto, os SLMs são o futuro para a maioria dos casos de uso devido aos seguintes motivos.

1. Menor custo de treinamento e manutenção

Os SLMs precisam de menos dados para treinamento do que os LLMs, o que os torna a opção mais viável para indivíduos e pequenas e médias empresas com dados de treinamento limitados, finanças ou ambos. Os LLMs exigem grandes quantidades de dados de treinamento e, por extensão, precisam de enormes recursos computacionais para treinar e executar.

Para colocar isso em perspectiva, o CEO da OpenAI, Sam Altman, confirmou que eles levaram mais de US$ 100 milhões para treinar o GPT-4 enquanto falava em um evento no MIT (conforme Wired). Outro exemplo é o OPT-175B LLM da Meta. A Meta diz que foi treinado usando 992 GPUs NVIDIA A100 de 80 GB, que custam cerca de US$ 10.000 por unidade, conforme a CNBC. Isso coloca o custo em aproximadamente US$ 9 milhões, sem incluir outras despesas como energia, salários e mais.

Com tais números, não é viável para pequenas e médias empresas treinar um LLM. Em contraste, os SLMs têm uma barreira de entrada menor em termos de recursos e custam menos para operar, e, portanto, mais empresas os adotarão.

2. Melhor desempenho

Desempenho é outra área em que os SLMs superam os LLMs devido ao seu tamanho compacto. Os SLMs têm menos latência e são mais adequados para cenários em que respostas mais rápidas são necessárias, como em aplicativos em tempo real. Por exemplo, uma resposta mais rápida é preferida em sistemas de resposta de voz, como assistentes digitais.

Executar no dispositivo (falaremos mais sobre isso depois) também significa que sua solicitação não precisa fazer uma viagem até servidores online e retornar para responder à sua consulta, resultando em respostas mais rápidas.

3. Mais preciso

Quando se trata de IA generativa, uma coisa permanece constante: lixo entra, lixo sai. Os LLMs atuais foram treinados usando grandes conjuntos de dados brutos da internet. Portanto, eles podem não ser precisos em todas as situações. Este é um dos problemas com o ChatGPT e modelos semelhantes e o motivo pelo qual você não deve confiar em tudo o que um chatbot de IA diz. Por outro lado, os SLMs são treinados usando dados de maior qualidade do que os LLMs e, portanto, têm maior precisão.

Os SLMs também podem ser ajustados ainda mais com treinamento focado em tarefas ou domínios específicos, resultando em maior precisão nessas áreas em comparação com modelos maiores e mais generalizados.

4. Pode ser executado no dispositivo

Os SLMs precisam de menos poder computacional do que os LLMs e, portanto, são ideais para casos de edge computing. Eles podem ser implantados em dispositivos de ponta, como smartphones e veículos autônomos, que não têm grande poder computacional ou recursos. O modelo Nano do Google pode ser executado no dispositivo, permitindo que ele funcione mesmo quando você não tem uma conexão ativa com a internet.

Essa capacidade apresenta uma situação ganha-ganha para empresas e consumidores. Primeiro, é uma vitória para a privacidade, pois os dados do usuário são processados localmente em vez de enviados para a nuvem, o que é importante, pois mais IA é integrada aos nossos smartphones, contendo quase todos os detalhes sobre nós. Também é uma vitória para as empresas, pois elas não precisam implantar e executar grandes servidores para lidar com tarefas de IA.

Os SLMs estão ganhando força, com os maiores players da indústria, como Open AI, Google, Microsoft, Anthropic e Meta, lançando tais modelos. Esses modelos são mais adequados para tarefas mais simples, que é para o que a maioria de nós usa LLMs; portanto, eles são o futuro.

Mas os LLMs não vão a lugar nenhum. Em vez disso, eles serão usados para aplicações avançadas que combinam informações em diferentes domínios para criar algo novo, como em pesquisa médica.

.