.

Enquanto seus aliados da Liga da Justiça Superman e Mulher Maravilha viverão por séculos e potencialmente até milênios, homem MorcegoO apelo de sempre foi que ele é um herói mortal e um dia ele morrerá. Ao criar uma família de heróis, prender vilões mortais e usar sua vasta fortuna para elevar Gotham, Bruce Wayne espera deixar para trás um legado heróico – um que ele não viverá para ver e precisará de outros para continuar. Mal sabe o Caped Crusader a escala do que está por vir.

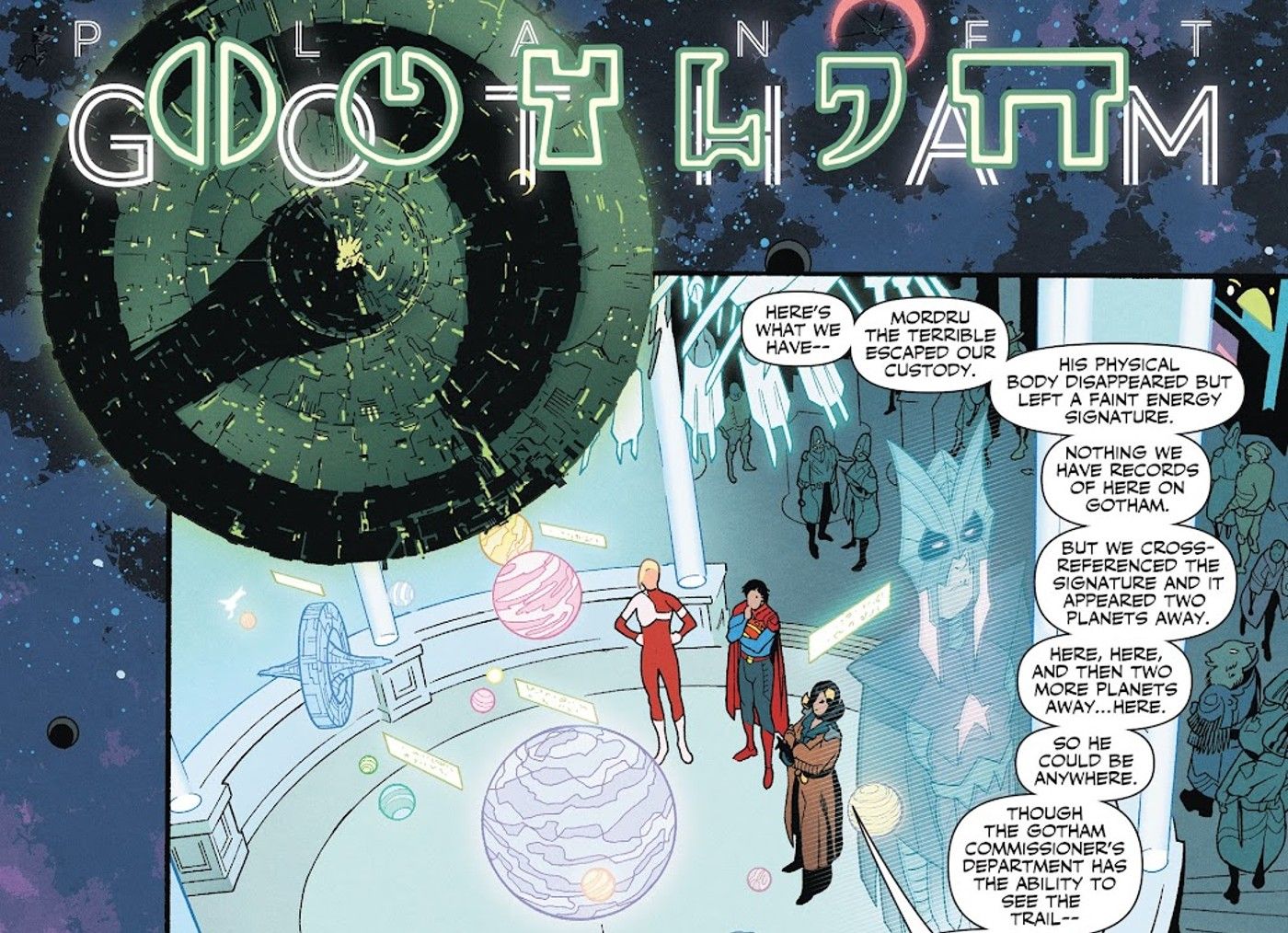

Em DC’s Legião de Super-Heróis #1 – por Brian Michael Bendis e Ryan Sook – os fãs podem ver de perto o século 31 do Universo DC. Embora o tempo esteja sempre em fluxo, a série confirma isso como o futuro mais estável da DC – o mundo que os heróis do presente deixarão para trás se continuarem em seus caminhos atuais. Como o Superboy de Jon Kent é convidado a explorar o futuro, ele visita vários planetas influenciados pelos heróis que conhece de seu próprio tempo, incluindo uma Terra muito danificada, mas ainda habitável, e um Novo Krypton reassentado estabelecido com a ajuda de seu pai. No entanto, o planeta mais fascinante identificado no futuro da Legião é o Planeta Gotham.

Planeta Gotham é tudo pelo que Batman trabalhou

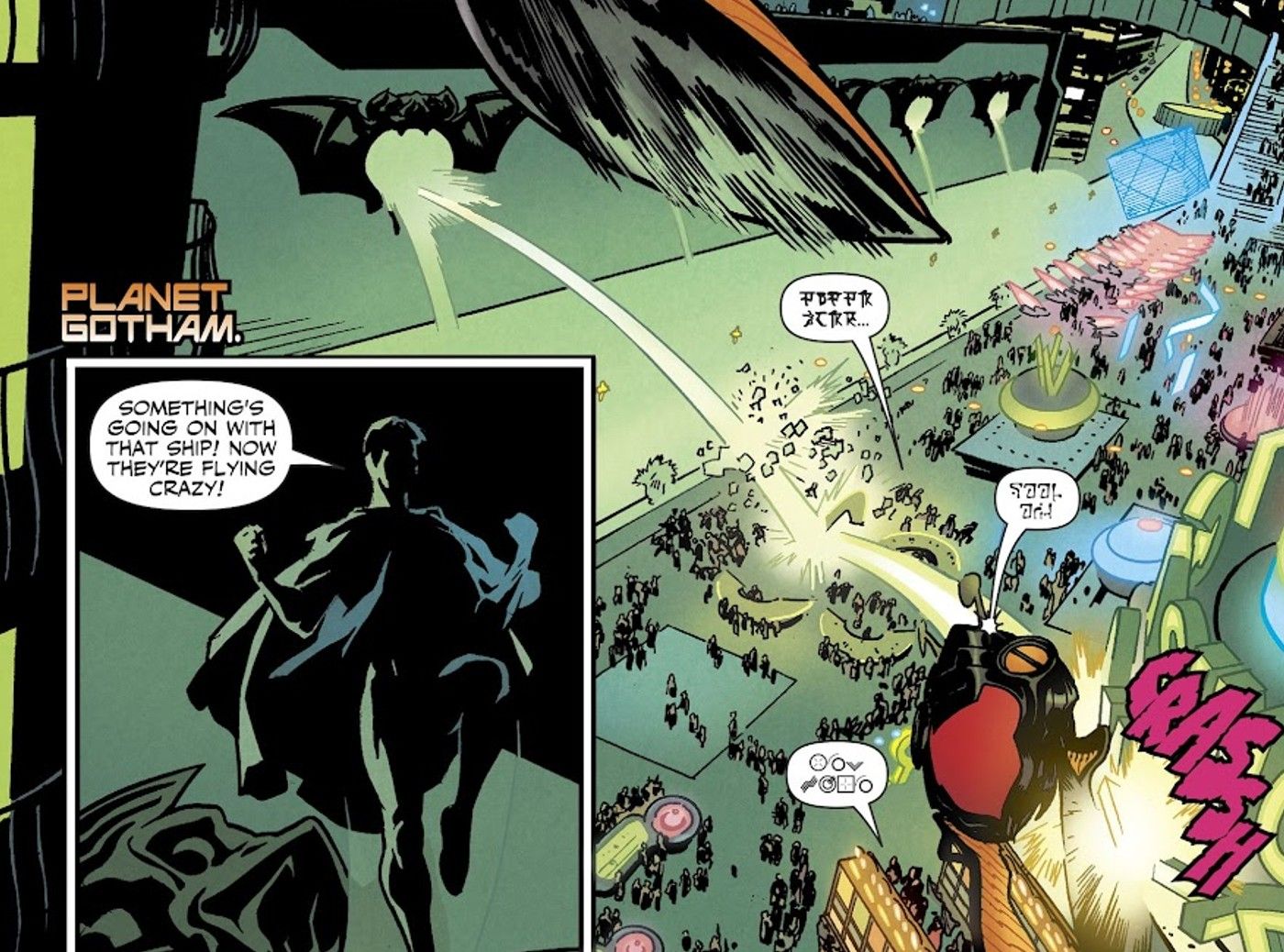

Planet Gotham é um mundo misterioso baseado no legado de Batman, e é explorado ao longo da série. O primeiro mundo criado artificialmente na galáxia, o planeta Gotham é atacado pelo demoníaco Mordru na edição 1, que é derrotado pela Legião e trancado em uma prisão de alta tecnologia, provocando que o planeta pode ser algum tipo de Arkham Asylum galáctico. No entanto, conforme a série continua, o Planeta Gotham mostra-se um dos planetas mais cosmopolitas da galáxia – um destino turístico conhecido por sua vida noturna e culinária, e um membro respeitado dos utópicos United Planets. O planeta Gotham está coberto de imagens de morcegos e tem muitas referências culturais à família dos morcegos – como uma cidade com o nome de Nightwing’s Blüdhaven – e é vigiado pelo comissário December Sevenbergen, que lidera uma força policial de ficção científica. Os quadrinhos observam que o Planeta Gotham é próspero e “limpar,” sugerindo que é uma grande refutação do beco de Gotham onde Bruce perdeu seus pais.

Legião de super-heróis usa a enorme diferença de tempo para mostrar como a filosofia e a missão de Batman só cresceram em relevância, confirmando que, ao proteger Gotham no presente, ele desencadeou uma linha de dominós que leva a um planeta inteiro que parece ser sua visão ideal para sua casa. cidade. Se Batman visse o planeta Gotham, sem dúvida o veria como sua maior conquista: tudo pelo que lutou, realizado em escala planetária.

O legado de Batman é tão complexo quanto sua vida

No entanto, o que torna o planeta Gotham o ponto final perfeito para a história de Batman é a natureza subjetiva de seu mundo. Embora de aparência utópica, o Planeta Gotham ainda é altamente policiado, com a falta de lixo uniforme sugerindo uma abordagem extrema para todos os infratores da lei. Da mesma forma, seu status como o primeiro mundo criado artificialmente caracteriza todo o planeta como uma expressão de imensa riqueza – um potencial planeta festivo em vez de uma verdadeira civilização. O planeta Gotham é visto como um local decadente – em algum lugar que os jovens legionários brincam que não deveriam ter permissão para visitar – mas também há a sugestão de uma liberdade cultural significativa. Dessa forma, o planeta Gotham atua como um teste de Rorschach de como os leitores veem o Batman.

Batman lutou por sua visão de Gotham e venceu

A natureza central do Batman é frequentemente debatida pelos fãs de quadrinhos. Ele é um gênio incansável e dedicado trabalhando para salvar os outros do trauma que experimentou ou um bilionário autoritário caracterizado por uma necessidade patológica de controle? Dependendo de como os fãs veem a filosofia de Batman, o planeta Gotham pode ser uma farsa superpoliciada, um covil galáctico do vício ou uma versão de Gotham protegida por tempo suficiente para se transformar em uma civilização vibrante e de tamanho mundial, onde o hedonismo benevolente floresce. Mais do que talvez qualquer outro herói da DC, homem MorcegoO legado de Bruce Wayne deve ser complicado, e Planet Gotham mostra que, mesmo no século 31, o impacto de Bruce Wayne no mundo é complexo, tingido de escuridão e aberto a uma vasta interpretação.

.