.

O Dia de Ação de Graças de Eli Roth, que é uma adaptação do trailer de paródia de terror que ele dirigiu para Grindhouse de 2007, chega online.

Este artigo cobre uma história em desenvolvimento. Continue nos consultando, pois adicionaremos mais informações assim que estiverem disponíveis.

Resumo

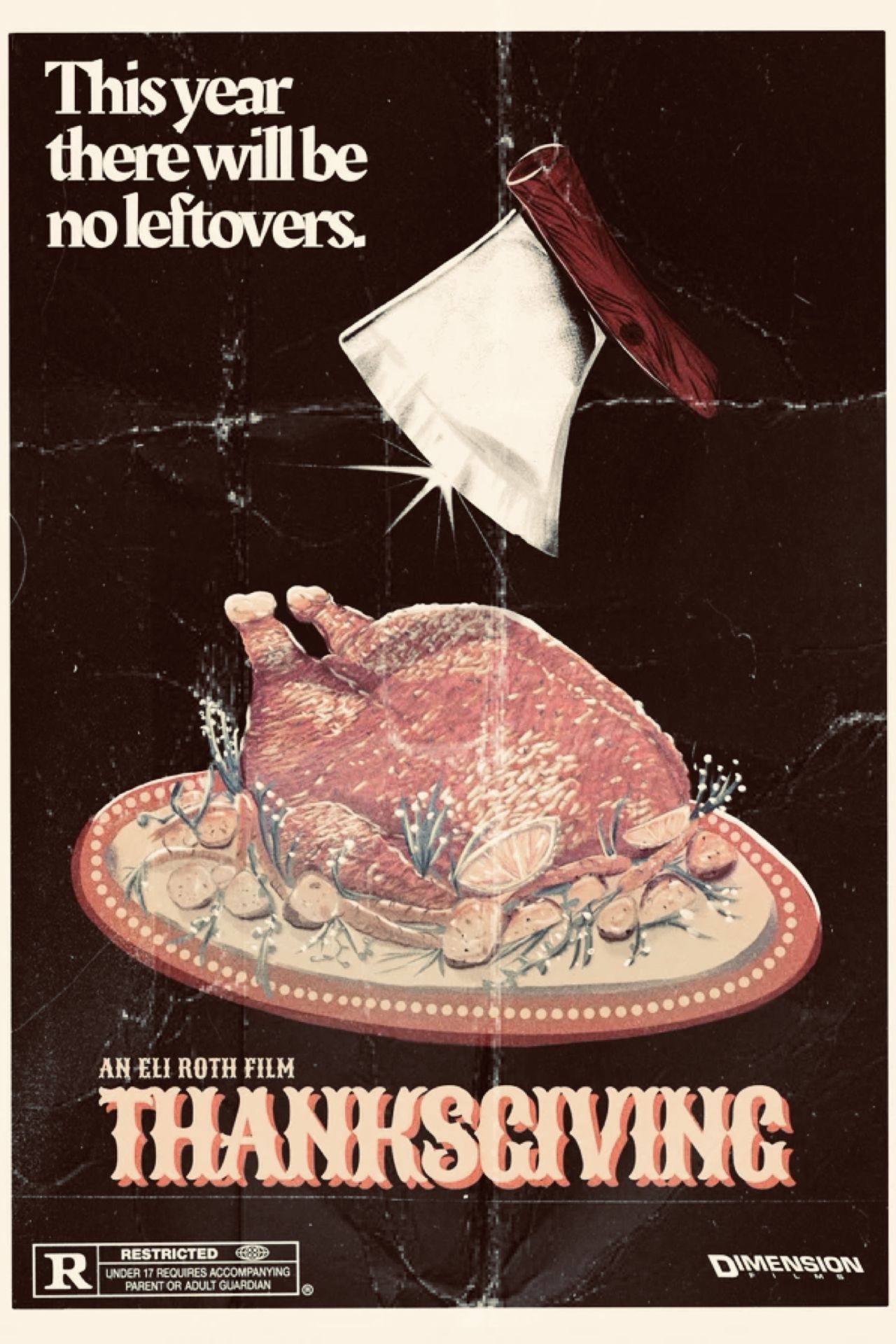

- “Thanksgiving” de Eli Roth é um filme completo baseado em um trailer de paródia de terror do filme Grindhouse de 2007, prometendo uma experiência de terror no estilo do início dos anos 1980.

- A adaptação para o longa-metragem de “Ação de Graças” chegará aos cinemas em 17 de novembro, com um elenco repleto de estrelas, incluindo Patrick Dempsey e a sensação do TikTok, Addison Rae.

- Os fãs agora podem assistir ao trailer oficial de “Ação de Graças” e ter um gostinho da visão de Eli Roth para este filme de terror de inspiração retrô.

O trailer de Ação de graças revela a visão de Eli Roth para um filme completo baseado no conceito. Ação de graçasque estreia nos cinemas em 17 de novembro, é uma adaptação de um trailer de paródia de terror que Roth contribuiu para o longa-metragem duplo de 2007. Moedorque embalou o filme de Quentin Tarantino Prova de Morte e Roberto Rodríguez Planeta terror com trailers retrô falsos. “Thanksgiving” prometeu um filme de terror no estilo do início dos anos 1980 que agora está ganhando vida com um elenco que inclui Patrick Dempsey, Milo Manheim, Gina Gershon e a estrela do TikTok Addison Rae.

O trailer oficial de Eli Roth Ação de graças agora foi lançado exclusivamente por Tomates podres. Confira abaixo:

O trailer define o cenário para o feriado, mostrando uma pequena cidade feliz enquanto um personagem monólogo sobre o significado do Dia de Ação de Graças. No entanto, a tranquilidade do feriado é rapidamente destruída quando um assassino fantasiado de Peregrino chega para destruir o elenco com uma variedade de instrumentos afiados.

Mais por vir…

Fonte: Tomates Podres

Principais datas de lançamento

.