.

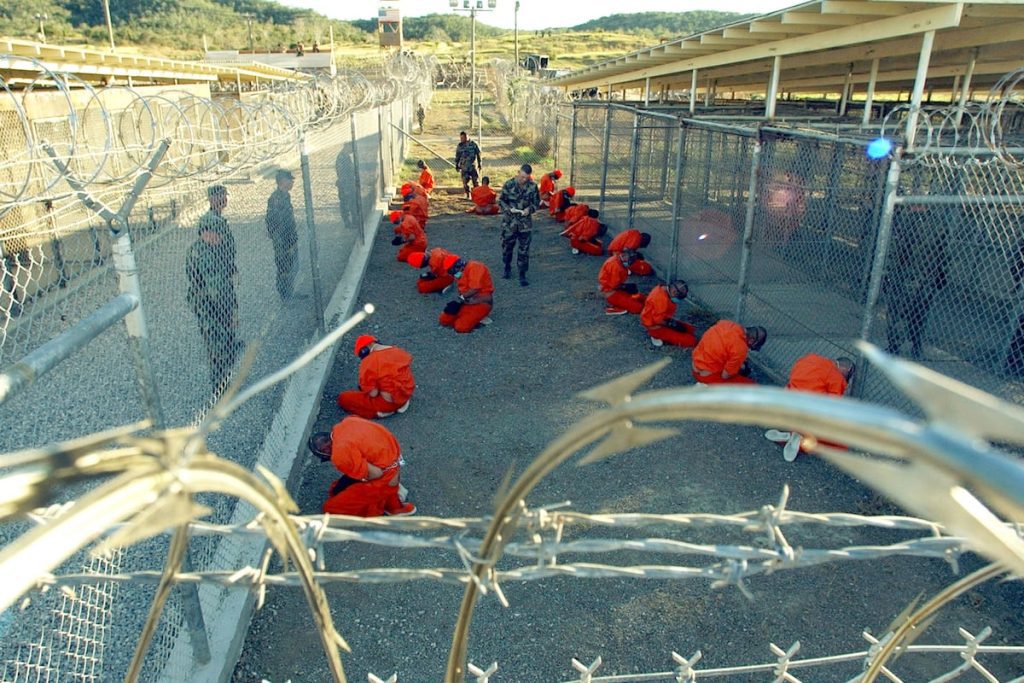

O suposto mentor dos ataques de 11 de setembro e dois de seus cúmplices concordaram em se declarar culpados em troca de uma sentença de prisão perpétua para evitar um julgamento que poderia ter levado à pena de morte em Guantánamo (Cuba), informaram esta quarta-feira os promotores. A prisão militar da Baía de Guantánamo, sinónimo de alguns dos piores abusos cometidos pelos Estados Unidos na sua guerra contra o terrorismo, alberga cerca de trinta reclusos 22 anos após a sua abertura, dos quase 800 encerrados nas suas celas no auge da ofensiva lançada por. Presidente George W. Bush contra Osama bin Laden e a rede Al Qaeda. A grande maioria dos reclusos não teve nada a ver com os ataques de Setembro de 2001 ou com o terrorismo islâmico.

_ _ _ _ _ _ _ _ _ _ _ _ _ _ _ _ _ _ _ _ _ _ _ _ _ _

.