.

A Microsoft adicionou outros 389 megawatts de energia renovável ao seu portfólio, enquanto a gigante da tecnologia se esforça para atender às demandas de energia necessárias para corresponder às suas ambições de IA.

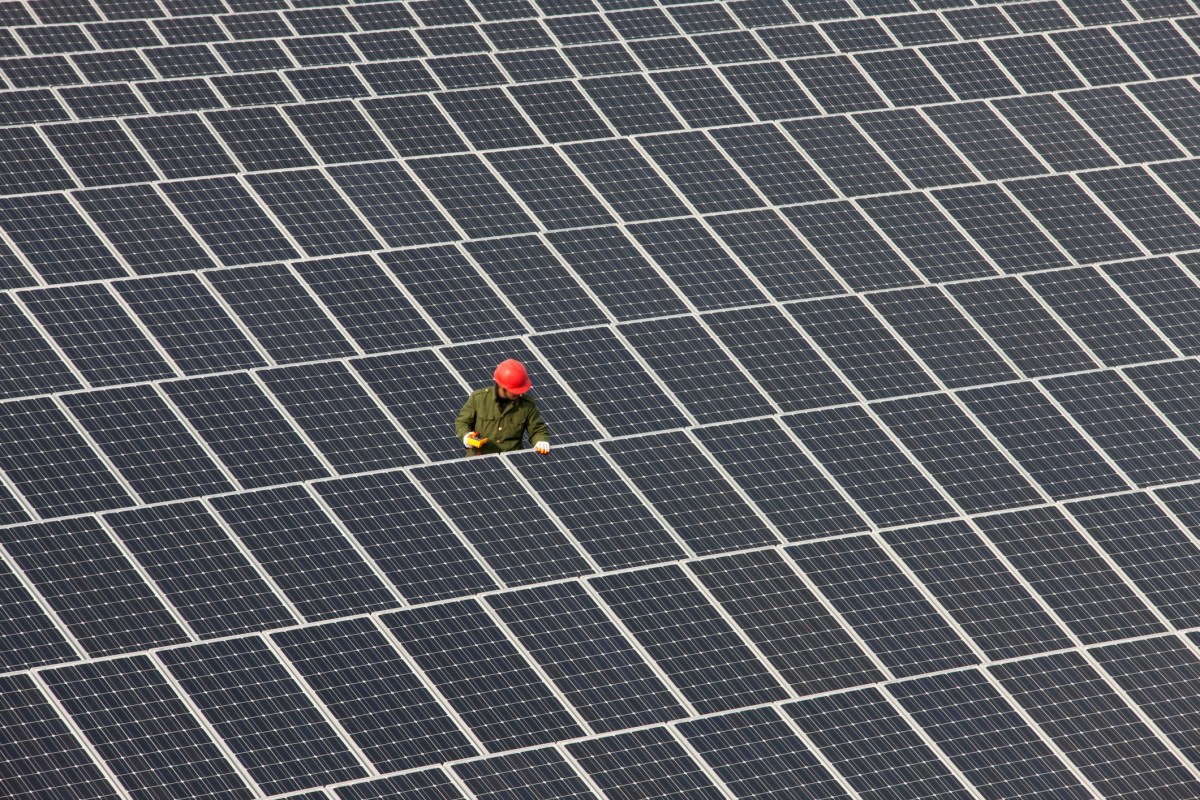

O poder renovável adicional abrange três projetos solares desenvolvidos pela EDP Renowables North America – dois no sul de Illinois e um nos arredores de Austin, Texas. A Microsoft está comprando uma mistura de eletricidade para alimentar suas operações próximas e créditos de energia renovável para cobrir a demanda em outros lugares.

A Microsoft contrai quase 20 gigawatts de capacidade de energia renovável, de acordo com o relatório de sustentabilidade 2024 da empresa. Esta última compra adiciona cerca de 2% à contagem.

A gigante da tecnologia tem adquirido energia em um clipe rápido para alimentar suas operações de nuvem e IA. Como muitos de seus colegas, a Microsoft adotou o poder renovável, em parte porque o vento e a energia solar podem ser implantados de maneira rápida e barata.

A energia solar é especialmente rápida. Enquanto novas usinas a gás levam anos para construir e comissionar, uma nova fazenda solar pode começar a produzir energia em apenas 18 meses. Os desenvolvedores planejam projetos que podem ser encomendados em fases, permitindo que eles forneçam aos data centers a eletricidade o mais rápido possível.

Para permitir a energia 24 horas por dia, sete dias por semana, alguns desenvolvedores renováveis estão se voltando para as chamadas instalações híbridas. Solar e vento estão conectados a um ou mais tipos de baterias, que são carregadas quando a energia renovável flui e descarregadas quando diminui. Na semana passada, a Amazon assinou um contrato com um desses empreendimentos em Portugal.

As compras de energia renovável permitem que a Microsoft altere suas operações principais sem produzir poluição. Também pode ajudar a Microsoft a cumprir sua promessa de se tornar negativo de carbono até 2030. Para atingir o alvo, a Microsoft terá que seqüestrar e armazenar mais carbono que suas operações produzem.

Para atingir emissões negativas, a Microsoft também investiu em várias formas de remoção de carbono, incluindo captura direta de ar, intemperismo de rocha aprimorado e reflorestamento. No mês passado, a Microsoft anunciou um acordo com a Chestnut Carbon para comprar mais de 7 milhões de toneladas de créditos de carbono, o suficiente para cobrir cerca de metade das emissões da empresa de tecnologia em 2023.

.