.

Na sexta-feira, uma equipe de pesquisadores da Universidade de Chicago divulgou um artigo de pesquisa descrevendo “Nightshade”, uma técnica de envenenamento de dados que visa interromper o processo de treinamento de modelos de IA, relatam o MIT Technology Review e o VentureBeat. O objetivo é ajudar artistas visuais e editores a proteger seu trabalho de ser usado para treinar modelos generativos de síntese de imagens de IA, como Midjourney, DALL-E 3 e Stable Diffusion.

A ferramenta de código aberto “pílula venenosa” (como o departamento de imprensa da Universidade de Chicago a chama) altera imagens de maneiras invisíveis ao olho humano que podem corromper o processo de treinamento de um modelo de IA. Muitos modelos de síntese de imagens, com notáveis exceções daqueles da Adobe e Getty Images, usam em grande parte conjuntos de dados de imagens extraídas da web sem permissão do artista, o que inclui material protegido por direitos autorais. (A OpenAI licencia algumas de suas imagens de treinamento DALL-E da Shutterstock.)

A confiança dos investigadores de IA em dados recolhidos extraídos da Web, que são vistos como eticamente preocupantes por muitos, também foi fundamental para a recente explosão na capacidade de IA generativa. Foi necessária toda uma Internet de imagens com anotações (por meio de legendas, texto alternativo e metadados) criadas por milhões de pessoas para criar um conjunto de dados com variedade suficiente para criar Difusão Estável, por exemplo. Seria impraticável contratar pessoas para anotar centenas de milhões de imagens do ponto de vista de custo e de tempo. Aqueles com acesso a grandes bancos de dados de imagens existentes (como Getty e Shutterstock) têm vantagem ao usar dados de treinamento licenciados.

Shan, e outros.

Nessa linha, algumas instituições de pesquisa, como a Biblioteca de Berkeley da Universidade da Califórnia, defenderam a preservação da coleta de dados como uso justo no treinamento de IA para fins de pesquisa e educação. A prática ainda não foi definitivamente decidida pelos tribunais dos EUA e os reguladores estão actualmente a procurar comentários sobre uma potencial legislação que a possa afectar de uma forma ou de outra. Mas, na opinião da equipe da Nightshade, o uso para pesquisa e o uso comercial são duas coisas completamente diferentes, e eles esperam que sua tecnologia possa forçar as empresas de treinamento em IA a licenciar conjuntos de dados de imagens, respeitar as restrições do rastreador e obedecer às solicitações de exclusão.

“O objetivo desta ferramenta é equilibrar o campo de atuação entre treinadores de modelos e criadores de conteúdo”, disse o coautor e professor da Universidade de Chicago, Ben Y. Zhao, em um comunicado. “No momento, os treinadores de modelos têm 100 por cento do poder. As únicas ferramentas que podem desacelerar os rastreadores são as listas de exclusão e as diretivas de não rastreamento, todas opcionais e que dependem da consciência das empresas de IA e, claro nada disso é verificável ou exequível e as empresas podem dizer uma coisa e fazer outra impunemente. Esta ferramenta seria a primeira a permitir que os proprietários de conteúdo recuem de forma significativa contra o treinamento não autorizado de modelos.

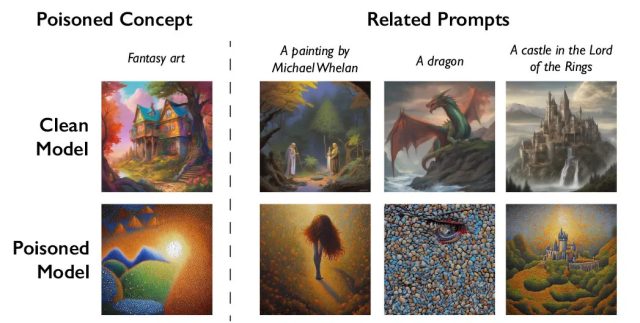

Shawn Shan, Wenxin Ding, Josephine Passananti, Haitao Zheng e Zhao desenvolveram Nightshade como parte do Departamento de Ciência da Computação da Universidade de Chicago. A nova ferramenta baseia-se no trabalho anterior da equipe com Glaze, outra ferramenta projetada para alterar a arte digital de uma maneira que confunde a IA. Enquanto o Glaze é orientado para ofuscar o estilo da arte, o Nightshade vai um passo além ao corromper os dados de treinamento. Essencialmente, ele engana os modelos de IA para que identifiquem incorretamente objetos nas imagens.

Por exemplo, em testes, os investigadores usaram a ferramenta para alterar imagens de cães de uma forma que levou um modelo de IA a gerar um gato quando solicitado a produzir um cão. Para fazer isso, Nightshade pega uma imagem do conceito pretendido (por exemplo, uma imagem real de um “cachorro”) e modifica sutilmente a imagem para que ela retenha sua aparência original, mas seja influenciada no espaço latente (codificado) por um conceito totalmente diferente. (por exemplo, “gato”). Desta forma, para uma verificação humana ou simples automatizada, a imagem e o texto parecem alinhados. Mas no espaço latente do modelo, a imagem possui características tanto do conceito original quanto do conceito venenoso, o que desencaminha o modelo quando treinado nos dados.

.