.

EU passou a maior parte da década de 2010 trabalhando em novas mídias, o que – se você gostou de ser demitido repetidamente e depois ser inundado com mensagens zombeteiras induzindo você a “aprender a codificar” porque sua indústria estava condenada – foi uma grande risada. Por fim, a diversão começou a se desgastar e, em um ato de desafio subversivo (ou resignação covarde), segui seus conselhos instigantes, aprendi a programar e me concentrei no que esperava que fosse uma carreira muito mais segura em “desenvolvimento web”. , apenas para avanços recentes em IA para supostamente tornar os trabalhos de codificação uma perda de tempo também. Parece que acidentalmente programei minha mudança de carreira para coincidir com um lançamento em massa de chatbots de IA que também aprenderam a codificar e que – em muitos aspectos – já são muito melhores nisso do que eu.

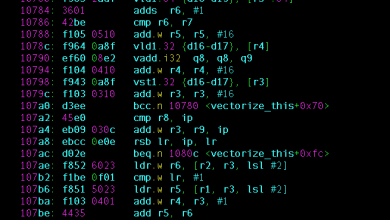

O código pode parecer alarmante para os não iniciados: “linguagens” inescrutáveis que, na maioria das vezes, são lidas como uma calculadora tendo um derrame, mas, de acordo com os mais fervorosos evangelistas da IA, elas não precisam mais representar nenhuma barreira. Por que se preocupar com o nerdspeak desnecessariamente complicado necessário para exibir texto branco em um fundo preto, quando agora você pode simplesmente pedir a um chatbot para fazer isso em termos leigos e ele prontamente fornecerá seu código, completo com instruções?

Brincando com vários chatbots, você ainda experimentará a IA cometendo uma quantidade razoável de erros – que um conhecimento prático do código ajuda a corrigir – mas você também pode apenas conversar sobre isso com a IA, e ela tentará resolvê-los para você. Não é difícil vislumbrar um futuro não muito distante onde possam discernir as necessidades dos usuários e orientá-los nas soluções, o papel de um desenvolvedor humano aparentemente consignado à história.

É tentador sucumbir ao fatalismo em torno do roubo de empregos de IA aqui. Os líderes de torcida mais barulhentos da tecnologia são eles próprios os mais ávidos por cultivá-la, encorajando-nos a nos render a um novo amanhecer robótico, onde dedicar tempo para aprender habilidades, realizar tarefas ou saber sobre qualquer coisa pode muito bem ser considerado coisa do passado. Mas confunde fundamentalmente a capacidade de atalho como para fazer algo com o desenvolvimento de uma compreensão completa de por que você faria.

Os chatbots de IA não quebraram alguns omertà em torno da codificação. Eles simplesmente digeriram uma carga de recursos e materiais de código aberto que já foram disponibilizados gratuitamente online para os seres humanos aprenderem. Um usuário pode tentar pular esta fase aproveitando a compreensão de um chatbot desse conhecimento, mas, ao fazê-lo, perderá a compreensão de quais decisões a máquina estava tomando em seu nome, por que as estava tomando, se eram boas e, crucialmente, o que mais era possível.

Um dos aspectos mais gratificantes do design e desenvolvimento da web é o pensamento lateral envolvido. Raramente existe um objetivo e singular correto caminho a seguir para alcançar algo. Você deve considerar todos os diferentes contextos que um usuário encontrará em seu site, como você deseja que ele interaja com ele, o que deseja provocar neles, se o que você montou fará com que o telefone superaqueça imediatamente e exploda, matando instantaneamente, e assim por diante. Uma máquina treinada para agregar e condensar toda a web em suas formas mais previsíveis não pensa assim, nem um usuário dependente de uma.

Tive a sorte de estabelecer uma prática trabalhando em projetos nos quais fui contratado não apenas porque possuo conhecimento de codificação que o cliente não possui, nem por minhas ideias criativas, mas pela combinação dos dois e como eles informam um outro. Além de ter sido profissionalmente frutífero para aprender a codificar, eu também – lamentavelmente, considerando como fui intimidado – na verdade … gosto disso? A pressa quando uma ideia impensada funciona de forma improvável é como nada mais. Eu penso e digo sem ironia coisas como: “Acredito na capacidade do navegador ser um meio absurdamente criativo e inovador”. Há projetos que me esforço para fazer, quer alguém me pague ou não.

E embora a IA possa diminuir certos aspectos do meu poder aquisitivo, não estou prestes a ter uma opinião tão negativa do meu ofício a ponto de pensar que é essencialmente o mesmo que digitar um comando em uma caixa de bate-papo. Ninguém deveria.

E, no entanto, há um esforço concentrado por parte do Vale do Silício para nos fazer acreditar que a mente humana é previsível, replicável e não sofisticada, e que as artes e setores adjacentes são redutíveis a um conjunto de equações e palavras-chave, porque eles gastaram bilhões criando máquinas que agora podem eliminar falsificações de esforços criativos e imagens levemente divertidas de Personagens de Harry Potter vestindo Balenciaga.

Questionado sobre possíveis casos de uso para IA, o cofundador da OpenAI (criador do ChatGPT), Greg Brockman, fez uma previsão reveladora sobre o que ele via como o futuro do entretenimento. “As pessoas ainda estão chateadas com a última temporada de Game of Thrones, mas imagine se você pudesse pedir à sua IA para criar um novo final que segue um caminho diferente e talvez até se colocar lá como personagem principal.

A capacidade das pessoas fazerem isso já existe desde tempos imemoriais, dentro de suas próprias cabeças. Isso fala de tal escassez de imaginação por parte dos expoentes da IA que eles estão nos pedindo para imaginar ter imaginação. Essas pessoas não conseguem conceber o prazer e a gratificação de criar arte, ou por que alguém preferiria criar suas próprias histórias em vez de terceirizar todo o processo para uma máquina. Eles não têm nem mesmo a convicção básica em suas próprias ideias para criar fanfics de Game of Thrones sem pedir a um computador para fazer o dever de casa.

A salivação mais pesada em torno do potencial da IA vem daqueles que a veem como uma medida empolgante de corte de custos que pode permitir que o capital finalmente se liberte de seu antigo adversário, o trabalho. É um disparate absurdo sugerir que a produção cultural coletiva registrada da humanidade foi essencialmente concluída, engarrafada e rolhada neste ponto específico da história, que tudo foi meramente forragem e pontos de dados para treinar modelos de IA que o levarão a partir daqui, saúde.

Ingerir cada peça de arte em uma máquina que os reduz sem amor a algum resultado mediano aproximado não é expressão artística. Pode ser um truque legal, uma novidade divertida, mas uma IA só é capaz de produzir imitações semiconvincentes de nossas criações precisamente porque pessoas reais e reais já tiveram o pensamento, a habilidade e a vontade de criá-las.

O espectro da IA será usado como uma ameaça e um porrete por aqueles que veem a busca criativa como algo que só vale a pena se puder ser monetizada, mas eles estão errados. Uma máquina não tem capacidade de auto-expressão, não tem compulsão para se comunicar: era assim que eu era, era assim que me sentia e era isso que defendia. Nós fazemos, e em todos os nossos empreendimentos, precisamos começar a recusar tentativas de nos fazer esquecer o quão valiosa é nossa humanidade.

.