.

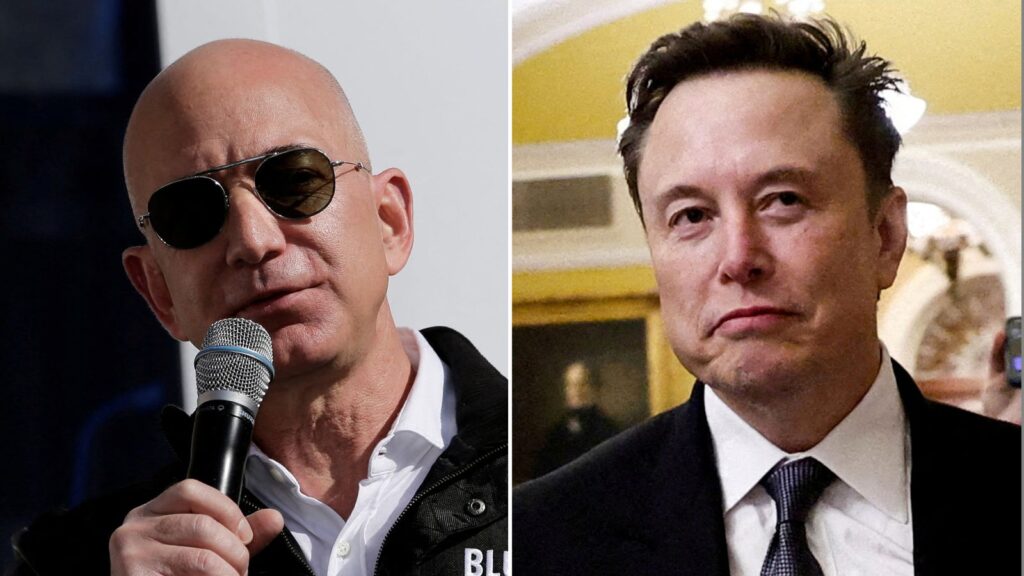

As duas pessoas mais ricas do planeta caminham para um confronto no espaço.

Elon Musk versus fundador da Amazon Jeff Bezos: ambos lançaram protótipos de foguetes no mesmo dia, uma rivalidade com bilhões de dólares em jogo.

A Starship da SpaceX é alimentada pelo extraordinário apetite de risco de Musk. Ele inova através do fracasso, e o sétimo vôo de teste não saiu inteiramente conforme o planejado.

O contato foi perdido com a parte superior do foguete com oito minutos de vôo e os engenheiros estarão estudando os dados para descobrir o porquê.

Mas o reforço, que já havia se separado, retornou com sucesso à base.

No último voo de teste, ele caiu no mar após uma falha técnica. Desta vez, ele desceu em velocidade supersônica, diminuiu a velocidade para ficar suspenso no ar e foi agarrado com segurança pelos braços dos “pauzinhos” na torre de lançamento.

Não é apenas para mostrar. Foguetes reutilizáveis são a chave para reduzir os custos de lançamento.

Bezos também usará peças de foguetes várias vezes.

Sua empresa, a Blue Origin, conseguiu alcançar a órbita com seu próprio foguete de carga pesada, New Glenn, na primeira tentativa.

Isso é impressionante, mas os planos de pousar o estágio de reforço em um navio no Atlântico não deram certo. Assim como Starship, é um trabalho em andamento.

No papel, Musk já venceu a corrida espacial com seu rival.

No ano passado, seus foguetes foram responsáveis por metade de todos os lançamentos em todo o mundo.

Mas Bezos estará otimista. Ele está nisso para o longo jogo.

Leia mais:

Jess Phillips diz que Elon Musk deveria ‘se esforçar para chegar a Marte’

Jeff Bezos está perseguindo Elon Musk na corrida espacial bilionária?

New Glenn não apenas lançará sua constelação de satélites de banda larga para competir com o Starlink de Musk, como também já possui contratos de defesa.

E, como Musk, ele tem contratos com a NASA para levar tripulação e carga à Lua.

Estamos entrando em uma nova era de exploração espacial. E os amigos da tecnologia que fizeram fortuna na Terra estão se preparando para novas oportunidades nas estrelas.

.