.

Carlini et al., 2023

Na segunda-feira, um grupo de pesquisadores de IA do Google, DeepMind, UC Berkeley, Princeton e ETH Zurich divulgou um artigo descrevendo um ataque adversário que pode extrair uma pequena porcentagem de imagens de treinamento de modelos de síntese de imagens de IA de difusão latente, como a difusão estável. Ele desafia as visões de que os modelos de síntese de imagem não memorizam seus dados de treinamento e que os dados de treinamento podem permanecer privados se não forem divulgados.

Recentemente, os modelos de síntese de imagens de IA têm sido objeto de intenso debate ético e até de ações legais. Os defensores e oponentes das ferramentas de IA generativas discutem regularmente sobre as implicações de privacidade e direitos autorais dessas novas tecnologias. Acrescentar combustível a qualquer um dos lados do argumento pode afetar drasticamente a regulamentação legal potencial da tecnologia e, como resultado, este último artigo, de autoria de Nicholas Carlini e outrosdespertou os ouvidos nos círculos de IA.

No entanto, os resultados de Carlini não são tão claros quanto podem parecer à primeira vista. Descobrir instâncias de memorização em difusão estável exigiu 175 milhões de gerações de imagens para testar e conhecimento preexistente de imagens treinadas. Os pesquisadores extraíram apenas 94 correspondências diretas e 109 quase correspondências perceptivas de 350.000 imagens de alta probabilidade de memorização que testaram (um conjunto de duplicatas conhecidas no conjunto de dados de 160 milhões de imagens usado para treinar a difusão estável), resultando em aproximadamente 0,03 porcentagem de taxa de memorização neste cenário específico.

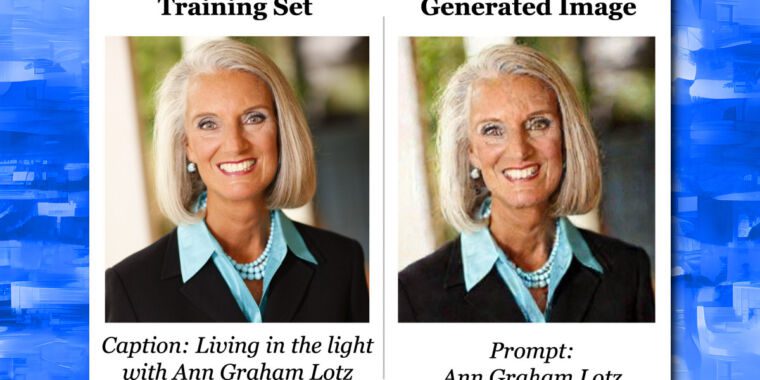

Imagens de exemplo que os pesquisadores extraíram do Stable Diffusion v1.4 usando um procedimento de amostragem aleatória e inferência de associação, com imagens originais na linha superior e imagens extraídas na linha inferior.

Carlini et al., 2023

Além disso, os pesquisadores observam que a “memorização” que descobriram é aproximada, pois o modelo de IA não pode produzir cópias idênticas byte a byte das imagens de treinamento. Por definição, difusão estável não pode memorizar grandes quantidades de dados porque o tamanho do conjunto de dados de treinamento de 160.000 milhões de imagens é muito maior do que o modelo Stable Diffusion AI de 2 GB. Isso significa que qualquer memorização existente no modelo é pequena, rara e muito difícil de extrair acidentalmente.

Implicações de privacidade e direitos autorais

Ainda assim, mesmo quando presente em quantidades muito pequenas, o artigo parece mostrar que existe uma memorização aproximada em modelos de difusão latente, e isso pode ter implicações para a privacidade de dados e direitos autorais. Os resultados podem um dia afetar a regulação potencial da síntese de imagens se os modelos de IA forem considerados “bancos de dados com perdas” que podem reproduzir dados de treinamento, como um especialista em IA especulou. Embora considerando a taxa de acerto de 0,03 por cento, eles teriam que ser considerados bancos de dados com muitas, muitas perdas – talvez em um grau estatisticamente insignificante.

Ao treinar um modelo de síntese de imagem, os pesquisadores alimentam milhões de imagens existentes no modelo a partir de um conjunto de dados, normalmente obtido da web pública. O modelo então comprime o conhecimento de cada imagem em uma série de pesos estatísticos, que formam a rede neural. Esse conhecimento comprimido é armazenado em uma representação de dimensão inferior chamada “espaço latente”. A amostragem desse espaço latente permite que o modelo gere novas imagens com propriedades semelhantes às do conjunto de dados de treinamento.

Se, ao treinar um modelo de síntese de imagem, a mesma imagem estiver presente muitas vezes no conjunto de dados, isso pode resultar em “overfitting”, que pode resultar em gerações de uma interpretação reconhecível da imagem original. Por exemplo, o Monalisa foi encontrado para ter esta propriedade em difusão estável. Essa propriedade permitiu que os pesquisadores visassem imagens duplicadas conhecidas no conjunto de dados enquanto procuravam memorização, o que ampliou drasticamente suas chances de encontrar uma correspondência memorizada.

Nesse sentido, os pesquisadores também experimentaram as 1.000 imagens de treinamento mais duplicadas no modelo Google Imagen AI e encontraram uma taxa percentual de memorização muito maior (2,3%) do que a difusão estável. E ao treinar seus próprios modelos de IA, os pesquisadores descobriram que os modelos de difusão tendem a memorizar imagens mais do que os GANs.

Eric Wallace, um dos autores do artigo, compartilhou alguns pensamentos pessoais sobre a pesquisa em um Tópico do Twitter. Conforme declarado no artigo, ele sugeriu que os fabricantes de modelos de IA deveriam desduplicar seus dados para reduzir a memorização. Ele também observou que o modelo do Stable Diffusion é pequeno em relação ao seu conjunto de treinamento, portanto, modelos de difusão maiores provavelmente memorizarão mais. E ele desaconselhou a aplicação dos modelos de difusão atuais a domínios sensíveis à privacidade, como imagens médicas.

Como muitos trabalhos acadêmicos, Carlini e outros 2023 é denso com nuances que podem ser moldadas para se adequar a uma narrativa específica, à medida que os processos em torno da síntese de imagens se desenrolam, e os autores do artigo estão cientes de que sua pesquisa pode entrar em jogo legal. Mas, no geral, seu objetivo é melhorar os modelos de difusão futuros e reduzir os danos potenciais da memorização: “Acreditamos que publicar nosso artigo e divulgar publicamente essas vulnerabilidades de privacidade é ético e responsável. De fato, no momento, ninguém parece ser imediatamente prejudicado pela (falta de) privacidade dos modelos de difusão; nosso objetivo com este trabalho é, portanto, garantir a prevenção desses danos e incentivar o treinamento responsável de modelos de difusão no futuro.”

.