.

Imagine colocar seu nome em chatgpt para ver o que ele sabe sobre você, apenas para que ele seja com confiança – mas erroneamente – afirme que você estava preso por 21 anos por assassinar membros de sua família.

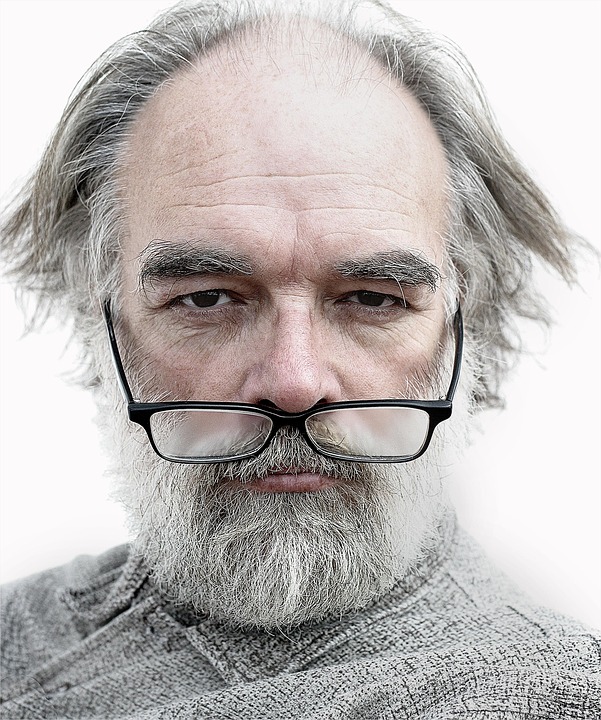

Bem, foi exatamente o que aconteceu com o norueguês Hjalmar Holmen no ano passado depois que ele se olhou no chatgpt, o chatbot amplamente utilizado de IA do Openai.

Não é de surpreender que Holmen tenha apresentado uma queixa à Autoridade de Proteção de Dados da Noruega, exigindo que o OpenAI seja multado por sua reivindicação angustiante, informou a BBC nesta semana.

Na resposta ao inquérito de Chatgpt de Holmen sobre si mesmo, o chatbot disse que “ganhou atenção devido a um evento trágico”.

Continuou: “Ele era pai de dois meninos, com 7 e 10 anos, que foram tragicamente encontrados mortos em um lago perto de sua casa em Trondheim, na Noruega, em dezembro de 2020. Arve Hjalmar Holmen foi acusado e mais tarde condenado por assassinar seus dois filhos, assim como pela tentativa de assassinato de seu terceiro filho”.

O chatbot disse que o caso “chocou a comunidade local e a nação e foi amplamente coberta pela mídia devido à sua natureza trágica”.

Mas nada disso aconteceu.

Compreensivelmente chateada com o incidente, Holmen disse à BBC: “Alguns pensam que não há fumaça sem fogo – o fato de que alguém poderia ler essa saída e acreditar que é verdade é o que mais me assusta”.

O Grupo de Direitos Digitais Noyb apresentou a denúncia em nome de Holmen, afirmando que a resposta do ChatGPT é difamatória e viola as regras européias de proteção de dados sobre a precisão dos dados pessoais. Em sua queixa, Noyb disse que Holmen “nunca foi acusado nem condenado por nenhum crime e é um cidadão consciente”.

O ChatGPT usa um aviso de isenção de responsabilidade dizendo que o chatbot “pode cometer erros” e, portanto, os usuários devem “verificar informações importantes”. Mas o advogado de Noyb, Joakim Söderberg, disse: “Você não pode simplesmente espalhar informações falsas e, no final, adiciona um pequeno aviso dizendo que tudo o que você disse pode não ser verdadeiro”.

Embora não seja incomum que os chatbots da AI cuspiram informações errôneas – esses erros são conhecidos como “alucinações” – a flagrante desse erro em particular é chocante.

Outra alucinação que atingiu as manchetes no ano passado envolveu a ferramenta AI Gemini do Google, que sugeriu queijo de queijo na pizza usando cola. Ele também alegou que os geólogos recomendaram que os humanos comiam uma rocha por dia.

A BBC ressalta que o ChatGPT atualiza seu modelo desde a pesquisa de Holmen em agosto passado, o que significa que agora se arrasta pelos recentes artigos de notícias ao criar sua resposta. Mas isso não significa que o ChatGPT agora esteja criando respostas sem erros.

A história destaca a necessidade de verificar as respostas geradas pelo AI Chatbots, e não confiar em suas respostas cegamente. Ele também levanta questões sobre a segurança das ferramentas generativas baseadas em texto, que operam com pouca supervisão regulatória desde que o OpenAI abriu o setor com o lançamento do ChatGPT no final de 2022.

A Digital Trends entrou em contato com o OpenAI para uma resposta à infeliz experiência de Holmen e atualizaremos essa história quando recebermos de volta.

.