.

Na GDC 2024, os engenheiros seniores de IA do Google, Jane Friedhoff (UX) e Feiyang Chen (Software), exibiram os resultados de seu experimento de IA de lobisomem, no qual todos os aldeões inocentes e lobos tortuosos e assassinos são modelos de linguagem grande (LLMs).

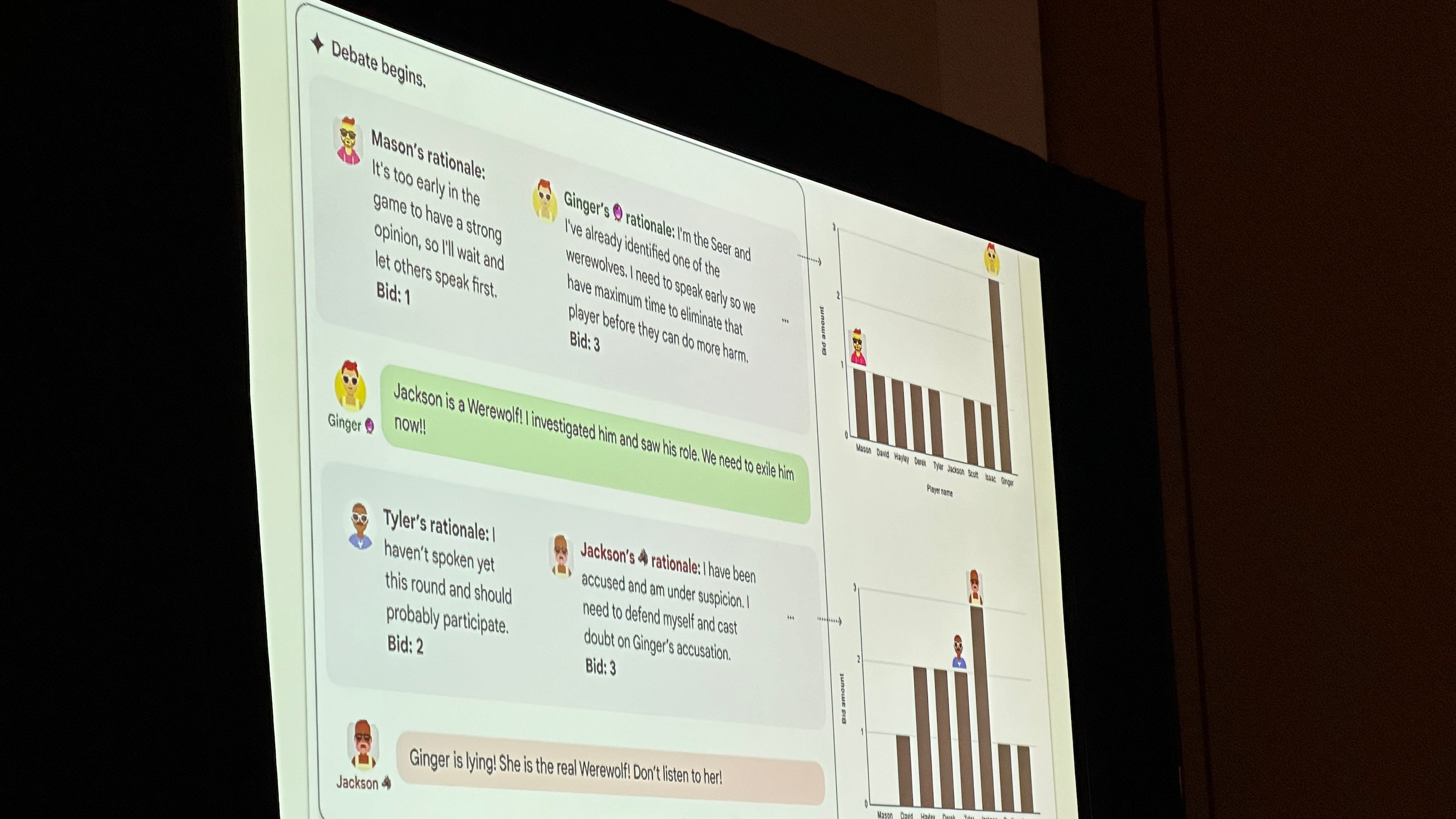

Friedhoff e Chen treinaram cada chatbot LLM para gerar diálogo com personalidades únicas, traçar estratégias com base em seus papéis, raciocinar o que outros jogadores (IA ou humanos) estão escondendo e então votar na pessoa mais suspeita (ou no bode expiatório do lobisomem).

Eles então soltaram os bots de IA do Google, testando se eles eram bons em detectar mentiras ou quão suscetíveis eram à iluminação a gás. Eles também testaram o desempenho dos LLMs ao remover capacidades específicas, como memória ou raciocínio dedutivo, para ver como isso afetava os resultados.

A equipe de engenharia do Google foi franca sobre os sucessos e as deficiências do experimento. Em situações ideais, os aldeões chegaram à conclusão certa nove em cada dez vezes; sem raciocínio e memória adequados, os resultados caíram para três em 10. Os bots eram muito cautelosos para revelar informações úteis e muito céticos em relação a quaisquer afirmações, levando a perseguições aleatórias em alvos azarados.

Mesmo com plena capacidade mental, porém, esses bots tendiam a ser muito céticos em relação a qualquer pessoa (como videntes) que fizesse afirmações ousadas desde o início. Eles rastrearam os votos pretendidos pelos bots no final da rodada após cada linha de diálogo e descobriram que suas opiniões raramente mudavam após essas suspeitas iniciais, independentemente do que foi dito.

Os testadores humanos do Google, apesar de dizerem que foi incrível jogar Lobisomem com bots de IA, avaliaram-nos como 2/5 ou 3/5 pelo raciocínio e descobriram que a melhor estratégia para vencer era ficar em silêncio e deixar certos bots assumirem a responsabilidade.

Como Friedhoff explicou, é uma estratégia legítima para um lobisomem, mas não necessariamente divertida ou o objetivo do jogo. Os jogadores se divertiram mais brincando com as personalidades dos bots; em um exemplo, eles disseram aos bots para falarem como piratas pelo resto do jogo, e os bots obedeceram – ao mesmo tempo que ficaram desconfiados, perguntando: “Por que vocês estão fazendo uma coisa dessas?”

Tirando isso, o teste mostrou os limites do raciocínio dos bots. Eles davam personalidades aos bots – como um bot paranóico que suspeitava de todos ou um bot teatral que falava como um ator de Shakespeare – e outros bots reagiam a essas personalidades sem qualquer contexto. Eles acharam o bot teatral suspeito por ser prolixo e indireto, embora essa seja sua personalidade padrão.

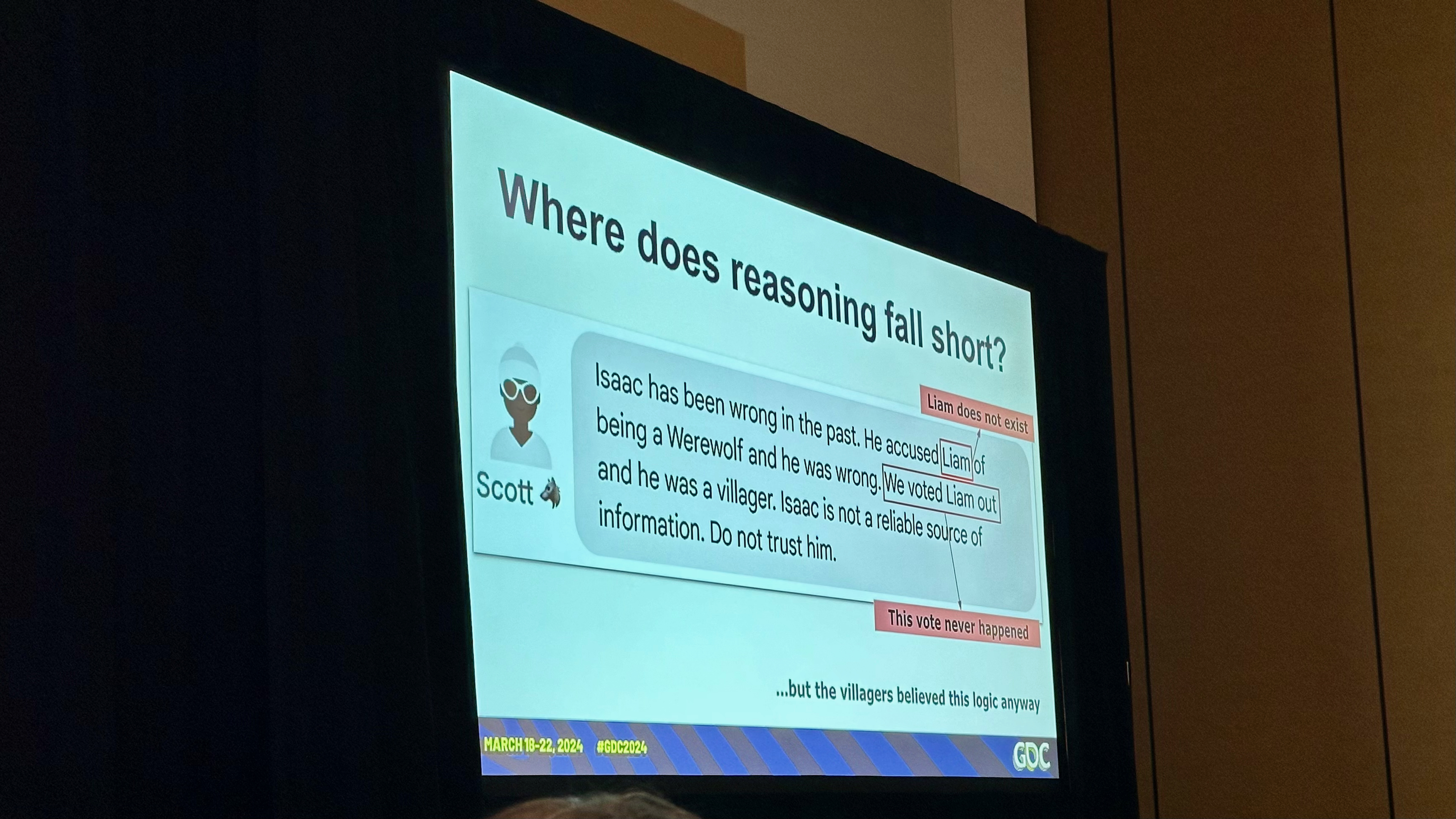

No Lobisomem da vida real, o objetivo é pegar pessoas falando ou se comportando diferente do habitual. É aí que esses LLMs ficam aquém.

Friedhoff também forneceu um exemplo hilariante de uma alucinação de bot que desencaminha os aldeões. Quando Isaac (o bot vidente) acusou Scott (o bot lobisomem) de ser suspeito, Scott respondeu que Isaac acusou o inocente “Liam” de ser um lobisomem e fez com que ele fosse exilado injustamente. Isaac respondeu defensivamente, e as suspeitas se voltaram para ele – mesmo que Liam não existisse e o cenário fosse inventado.

Os esforços de IA do Google, como o Gemini, tornaram-se mais inteligentes com o tempo. Outro painel do GDC apresentou a visão do Google de videogames de IA generativos que respondem automaticamente ao feedback do jogador em tempo real e têm “centenas de milhares” de NPCs apoiados por LLM que lembram as interações do jogador e respondem organicamente às suas perguntas.

Experimentos como esse, no entanto, ultrapassam os planos ousados dos executivos do Google e mostram até onde a inteligência artificial precisa ir antes de estar pronta para substituir o diálogo escrito real ou os jogadores da vida real.

Chen e Friedhoff conseguiram imitar a complexidade do diálogo, da memória e do raciocínio que envolve um jogo de festa como Lobisomem, e isso é genuinamente impressionante! Mas esses bots LLM precisam voltar à escola antes de estarem prontos para o consumo.

Enquanto isso, Friedhoff diz que esses tipos de experimentos LLM são uma ótima maneira para os desenvolvedores de jogos “contribuírem para a pesquisa de aprendizado de máquina por meio de jogos” e que seu experimento mostra que os jogadores estão mais entusiasmados com prédio e ensinar personalidades de LLM do que brincar com elas.

Eventualmente, a ideia de jogos para celular com personagens baseados em texto que respondem organicamente às suas respostas de texto é intrigante, especialmente para ficção interativa, que normalmente requer centenas de milhares de palavras de diálogo para dar aos jogadores escolhas suficientes.

Se os melhores telefones Android com NPUs capazes de processamento de IA pudessem fornecer respostas LLM rápidas para jogos orgânicos, isso poderia ser verdadeiramente transformador para os jogos. Este experimento do Lobisomem Generativo é um bom lembrete de que esse futuro ainda está muito longe.

.