.

A AI biz Cerebras revelou seu supercomputador Condor Galaxy, um cluster distribuído que, quando completo, abrangerá nove locais com capacidade para 36 exaFLOPS de desempenho combinado de FP16.

A empresa revelou na quinta-feira a primeira fase do sistema, que foi construído para o G42, conglomerado multinacional dos Emirados Árabes Unidos, com interesse em pesquisa e desenvolvimento de IA, usando a plataforma da Cerebras Aceleradores CS-2 para alimentar o processo.

Os aceleradores da Cerebras não são como as GPUs ou aceleradores de IA que você encontrará na maioria dos clusters de IA atualmente. Eles não vêm como placas PCIe ou módulos SXM como o H100 da Nvidia.

Em vez disso, os WSE-2 da empresa são enormes, tamanho do prato de jantar assuntos, cada um dos quais abriga 850.000 núcleos e 40 GB de SRAM com capacidade de 20 PBps de largura de banda. Isso é uma ordem de magnitude mais rápida do que o HBM típico de outros aceleradores. Cada um desses wafers contém uma dúzia de interfaces de 100 Gbps que permitem que o sistema seja estendido para até 192 sistemas.

Galáxia Condor se aglutina

Em sua forma atual, o Condor Galaxy 1 (CG-1) abrange 32 racks, cada um equipado com os aceleradores waferscale CS-2 do fabricante de chips, tornando-o duas vezes o tamanho do sistema Andromeda da Cerebras que olhou para ano passado.

No momento, o CG-1 possui 32 desses sistemas, que são alimentados por 36.352 núcleos AMD Epyc. Supondo que o Cerebras tenha ficado com as CPUs de 64 núcleos da AMD, isso funciona para 568 soquetes. Pedimos esclarecimentos ao Cerebras, pois isso não se divide perfeitamente em 32 racks, embora alguns sistemas no cluster, sem dúvida, preencham funções auxiliares.

Juntos, a máquina contém 41 TB de memória – embora a SRAM do wafer WSE-2 represente apenas 1,28 TB disso – 194 Tbps de largura de banda interna e desempenho máximo de dois exaFLOPS. Mas antes que você fique muito empolgado, lembramos que esses não são os mesmos exaFLOPS que esperamos ver no Argonne’s recém-concluído Supercomputador Aurora.

Os sistemas HPC são medidos em precisão dupla (FP64), geralmente usando o benchmark LINPACK. Os sistemas de IA, por outro lado, não se beneficiam desse nível de precisão e podem se safar com cálculos FP32, FP16, FP8 e, às vezes, até mesmo Int8. Nesse caso, os sistemas da Cerebras atingem seus números mais lisonjeiros no FP16 com esparsidade.

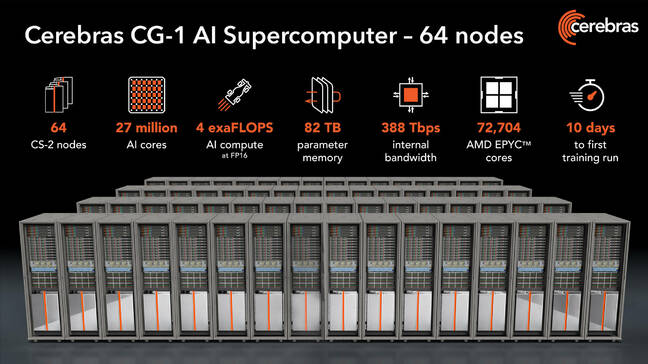

Embora dois exaFLOPS de FP16 sejam impressionantes por si só, isso é apenas metade da configuração. Quando concluído, o sistema de aproximadamente US$ 100 milhões abrangerá 64 racks, cada um com um acelerador CS-2.

Fomos informados de que o sistema deve escalar linearmente para que o cluster completo forneça quatro exaFLOPS de desempenho FP16 esparso – quatro vezes o de Andromeda. A Cerebras espera concluir a instalação dos 32 racks finais nos próximos três meses.

O supercomputador Condor Galaxy 1 completo da Cerebras abrangerá 64 racks, cada um equipado com seus aceleradores waferscale

Um supercomputador de IA distribuído

Obviamente, quatro exaFLOPS de desempenho de IA comandam uma quantidade substancial de energia e gerenciamento térmico. Assumindo escala linear de Andrômedaestimamos que o sistema seja capaz de consumir mais de dois megawatts.

Por isso, a Cerebras está abrigando o sistema nas instalações da Colovore em Santa Clara. O provedor de colocation é especializado em computação de alto desempenho e aplicativos AI/ML e, recentemente, revelado racks capazes de resfriar até 250 quilowatts.

“Este é o primeiro de três supercomputadores maciços baseados nos Estados Unidos que construiremos com eles no próximo ano”, disse Andrew Feldman, CEO da Cerebras. Strong The One.

Usando o CG-1 como modelo, mais dois sites baseados nos EUA serão construídos em Asheville, Carolina do Norte (CG-2) e outro em Austin, Texas (CG-3), com conclusão prevista para o primeiro semestre de 2024. Esses sistemas serão conectados em rede para permitir a distribuição de modelos entre sites, o que Feldman insiste ser possível para certas cargas de trabalho grandes e tolerantes à latência.

“A latência é um problema para alguns problemas, não para todos. No mundo da computação de alto desempenho, é um problema gigante”, disse ele. “Acho que há muitas cargas de trabalho de IA para as quais não é um problema. Há algumas que não distribuiremos. Acho que faremos isso com atenção e cuidado.”

A fabricante de chips também tem o cuidado de observar que o sistema será operado sob a lei dos EUA e não será disponibilizado para estados consultivos. Esta é provavelmente uma referência a política comercial dos EUA que regem a exportação de chips AI para certos países, incluindo Rússia, China e Coréia do Norte, entre outros.

No entanto, Feldman afirma que a decisão de construir os sistemas nos EUA foi motivada pelo desejo de agir rapidamente. “Acho que ficar entre os três primeiros nos EUA foi em função de um desejo de tempo para o mercado”, disse ele. “Acho que era um desejo do G42 se expandir além do Oriente Médio.”

A fase final verá a Cerebras construir mais seis sites – cuja localização ainda não foi divulgada – usando o CG-1 como modelo. O sistema Condor Galaxy completo contará com 576 aceleradores CS-2 capazes de reivindicar 36 exaflops de desempenho FP16 esparso, embora não esperemos ver muitas cargas de trabalho, se houver, abrangendo toda a constelação de nove locais. A Cerebras pretende concluir a instalação de todos os nove sites até o final de 2024.

Disponibilidade

Embora a Cerebras opere e gerencie os sistemas, eles são propriedade da G42, que planeja usar os sistemas para suas cargas de trabalho internas. Especificamente, a Cerebras diz que está trabalhando com três divisões da multinacional, incluindo G42 Cloud, International Institute for AI (IIAI) e G42 Health.

“Eles se associaram a nós porque podíamos construir e gerenciar grandes supercomputadores, implementar modelos de IA generativos massivos e porque tínhamos muita experiência na limpeza e manipulação de conjuntos de dados muito, muito grandes”, disse Feldman. “Eles têm uma grande demanda interna por computação entre as empresas de seu portfólio. Mas com modelos muito grandes, com computação muito grande, há um problema de empacotamento. Sempre há uma oportunidade de deslizar em outras cargas de trabalho.”

E isso significa que as sobras de recursos não consumidas pelo G42 serão disponibilizadas tanto para os clientes G42 quanto para os clientes da Cerebras. Para a Cerebras, isso é crítico, pois Feldman observa que a nuvem da empresa já está em sua capacidade máxima.

Para Feldman e sua empresa, a colaboração com a G42 é uma oportunidade de expor mais pessoas à arquitetura da Cerebras e competir de forma mais agressiva com a Nvidia, que detém um compartilhamento descomunal do mercado de aceleradores de IA. “Ninguém compra suas coisas sem pular na sua nuvem e testar, mostrar e demonstrar”, acrescentou Feldman. ®

.