.

Computex A Nvidia revelou seu mais recente truque de festa na Computex em Taipei: unindo 256 superchips Grace-Hopper em um “supercomputador AI” usando nada além de NVLink.

O kit, apelidado de DGX GH200, está sendo oferecido como um sistema único ajustado para modelos de IA com uso intensivo de memória para sistemas de recomendação de processamento de linguagem natural (NPM) e redes neurais de gráficos.

Em uma coletiva de imprensa antes da palestra do CEO Jensen Huang, os executivos compararam o GH200 ao recém-lançado servidor DGX H100 da empresa, alegando desempenho até 500 vezes maior. No entanto, os dois não são nada parecidos. O DGX H100 é um sistema 8U com Intel Xeons duplos e oito GPUs H100 e quase o mesmo número de NICs. O DGX GH200 é um cluster de 24 racks construído em uma arquitetura totalmente Nvidia – portanto, não exatamente comparável.

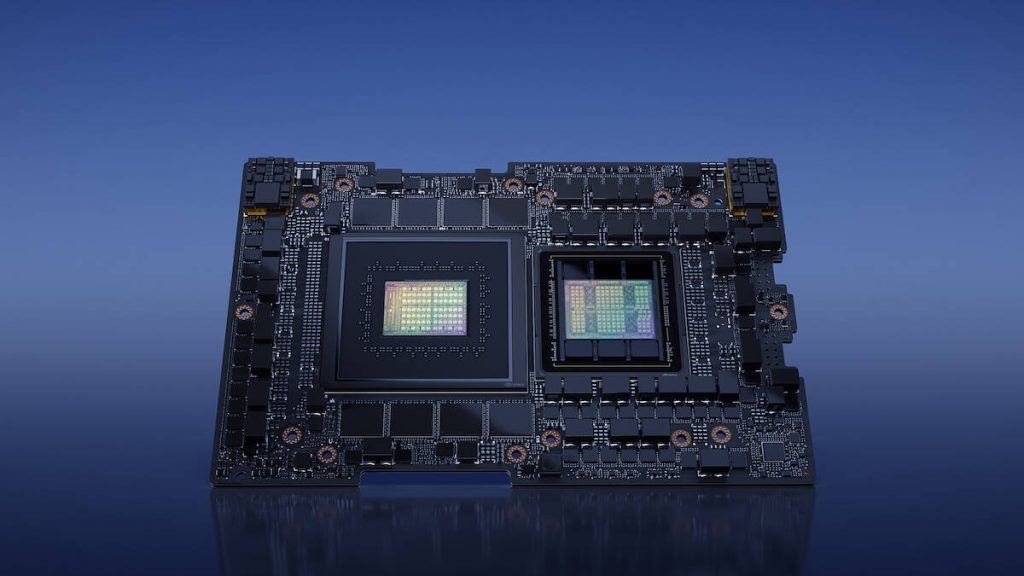

No coração desse supersistema está o chip Grace-Hopper da Nvidia. Apresentado em seu evento GTC de março em 2022, o hardware combina um cluster de CPU Grace compatível com Arm de 72 núcleos e 512 GB de memória LPDDR5X com uma matriz de GPU Hopper GH100 de 80 GB usando a interface NVLink-C2C de 900 GBps da empresa. Se você precisar de uma atualização sobre essa arquitetura de computação de última geração, confira nosso site irmão A Próxima Plataforma para mergulho mais profundo nesse silício.

De acordo com Ian Buck, vice-presidente de computação acelerada da Nvidia, o DGX GH200 possui 16 racks de computação, cada um com 16 nós equipados com um superchip. No total, a plataforma DGX GH200 possui 18.432 núcleos, 256 GPUs e 144 TB de memória “unificada”.

À primeira vista, esta é uma ótima notícia para quem deseja executar modelos muito grandes que precisam ser armazenados na memória. Como já fizemos anteriormente relatado, os LLMs precisam de muita memória, mas, neste caso, esse valor de 144 TB pode estar exagerando um pouco a verdade. Apenas cerca de 20 TB disso é o HBM3 super-rápido que normalmente é usado para armazenar parâmetros de modelo. Os outros 124 TB são DRAM.

Em cenários em que uma carga de trabalho não cabe na vRAM das GPUs, ela normalmente acaba se espalhando para a DRAM muito mais lenta, que é ainda mais prejudicada pela necessidade de copiar arquivos por uma interface PCIe. Isso, obviamente, não é bom para o desempenho. Mas, parece que a Nvidia está contornando essa limitação usando uma combinação de memória LPDDR5X muito rápida, boa para meio terabyte por segundo de largura de banda e NVLink em vez de PCIe.

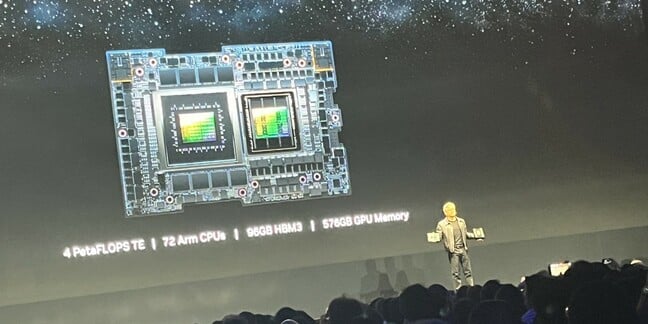

Falando na conferência COMPUTEX 2023 em Taiwan hoje, o chefe da Nvidia, Jensen Huang, comparou Grace-Hopper ao H100mega-GPU. Ele admitiu que o H100 tem mais potência que o Grace-Hopper. Mas ele apontou que o Grace-Hopper tem mais memória do que o H100, portanto é mais eficiente e, portanto, mais aplicável a muitos data centers.

“Conecte isso ao seu DC e você poderá expandir a IA”, disse ele.

Colando tudo junto

Nesse tópico, a Nvidia não está apenas usando o NVLink para comunicações de GPU para GPU, mas também para unir os 256 nós do sistema. De acordo com a Nvidia, isso permitirá que modelos de linguagem muito grandes (LLMs) se espalhem pelos 256 nós do sistema, evitando gargalos na rede.

A desvantagem de usar o NVLink é que, pelo menos por enquanto, ele não pode escalar além de 256 nós. Isso significa que, para clusters maiores, você ainda verá algo como InfiniBand ou Ethernet — mais sobre isso depois.

Apesar dessa limitação, a Nvidia ainda está reivindicando acelerações bastante substanciais para uma variedade de cargas de trabalho, incluindo processamento de linguagem natural, sistemas de recomendação e redes neurais de gráficos, em comparação com um cluster de DGX H100s mais convencionais usando InfiniBand.

No total, a Nvidia diz que um único cluster DGX GH200 é capaz de oferecer desempenho máximo de cerca de um exaflop. Em uma carga de trabalho HPC pura, o desempenho será muito menor. O chefe de computação acelerada da Nvidia estima o desempenho máximo em uma carga de trabalho FP64 em cerca de 17,15 petaflops ao aproveitar os núcleos tensores da GPU.

Se a empresa conseguir uma fração razoável disso no benchmark LINPACK, isso colocaria um único cluster DGX GH200 entre os 50 supercomputadores mais rápidos.

As térmicas ditam o design

A Nvidia não respondeu às nossas perguntas sobre gerenciamento térmico ou consumo de energia, mas, dada a densidade de computação do cluster e o público-alvo, quase certamente estamos olhando para um sistema refrigerado a ar.

Mesmo sem entrar no resfriamento líquido ou por imersão, algo que a empresa está estudando, a Nvidia poderia ter tornado o cluster muito mais compacto.

Na Computex do ano passado, a empresa exibiu um 2U Design de referência HGX com duas lâminas de superchip Grace-Hopper. Usando esses chassis, a Nvidia poderia ter empacotado todos os 256 chips em oito racks.

Suspeitamos que a Nvidia tenha evitado isso devido às limitações de energia e resfriamento do datacenter. Lembre-se, os clientes da Nvidia ainda precisam implantar o cluster em seus datacenters e, se precisarem fazer grandes alterações na infraestrutura, será uma venda difícil.

Somente o chip Grace-Hopper da Nvidia requer cerca de um quilowatt de poder. Portanto, sem levar em consideração a placa-mãe e o consumo de rede, você está pensando em resfriar cerca de 16 quilowatts por rack, apenas para a computação. Isso já será muito para muitos operadores de datacenter acostumados a resfriar racks de 6 a 10 quilowatts, mas pelo menos dentro do domínio da razão.

Considerando que o cluster está sendo vendido como uma unidade, suspeitamos que os tipos de clientes considerando que o DGX GH200 também está levando em consideração o gerenciamento térmico e o consumo de energia. De acordo com a Nvidia, Meta, Microsoft e Google já estão colocando em campo os clusters, com disponibilidade geral prevista para antes do final de 2023.

Jensen Huang Lançando a DH200 no palco da Computex 2023. Sim, devíamos ter trazido uma câmera melhor – Clique para ampliar

Expandir com Helios

Mencionamos anteriormente que, para expandir o DGX GH100 além de 256 nós, os clientes precisariam recorrer a métodos de rede mais tradicionais, e é exatamente isso que a Nvidia pretende demonstrar com seu próximo Helios “supercomputador AI”.

Embora os detalhes sejam muito escassos neste ponto, parece que o Helios é essencialmente apenas quatro clusters DGX GH200 colados usando os switches Quantum-2 InfiniBand de 400 Gbps da empresa.

Já que estamos falando de switches, na COMPUTEX Huang anunciou o SPECTRUM-4, um switch colossal que combina Ethernet e InfiniBand, com um BlueField 3 SmartNIC de 400 GB/s. Huang disse que o switch e o novo SmartNIC permitirão que o tráfego de AI flua pelos data centers e contorne a CPU, evitando gargalos ao longo do caminho. Strong The One buscará mais detalhes assim que estiverem disponíveis.

Espera-se que o Helios fique online até o final do ano. E embora a Nvidia enfatize seu desempenho de IA no FP8, o sistema deve ser capaz de oferecer desempenho máximo em torno de 68 petaflops. Isso o colocaria aproximadamente no mesmo nível do sistema francês Adastra, que, a partir da semana passada, ocupa o 12º lugar no ranking Top500. ®

– Com Simon Sharwood.

.