.

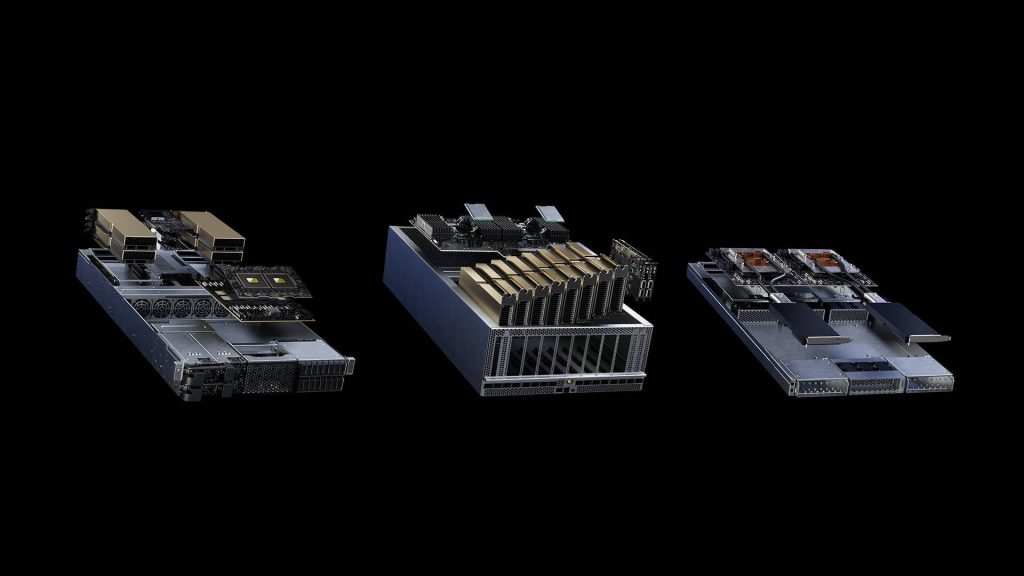

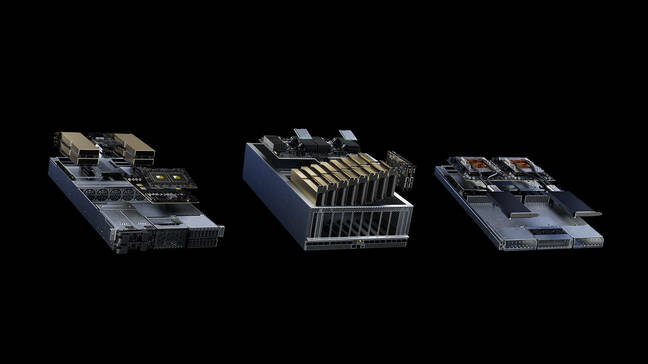

Computex A Nvidia criou um design aberto para servidores para abrigar seus aceleradores, argumentando que os designs de servidor centrados na CPU não são suficientes para abrigar várias GPUs e SmartNICs.

O CEO da Nvidia, Jensen Huang, anunciou o design, chamado “MGX”, na conferência Computex 2023 em Taiwan na segunda-feira, e disse que é necessário porque os designs de servidores existentes não foram criados para lidar com o calor produzido e a energia consumida pelos aceleradores da Nvidia.

O design do chassi foi anunciado em uma palestra que viu Huang subir ao palco para seu primeiro discurso público em quatro anos, levando-o a pedir ao público que lhe desejasse boa sorte.

A multidão estava pronta para fazer isso e muito mais: os apostadores literalmente correram para a frente da sala para ficar mais perto de Huang. Vestindo sua jaqueta de couro preta, sua marca registrada, o CEO fez um discurso de duas horas salpicado de piadas em chinês e até uma expressão de apreço por um notório lanche taiwanês chamado “tofu fedorento”. A multidão comeu. Uma gerente de projeto de software taiwanesa que descaradamente ocupou um assento reservado para a imprensa para que pudesse ver Huang com mais clareza nos disse que compareceu porque o chefe da Nvidia certamente ofereceria insights incomparáveis sobre IA.

A proposta de Huang era que uma era da história da computação que começou com a estreia do System 360 da IBM em 1965 chegou ao fim. Nas palavras de Huang, o System 360 deu ao mundo a primazia da CPU e a capacidade de escalar sistemas.

Essa arquitetura dominou o mundo desde então, opinou ele, mas a melhoria do desempenho da CPU estagnou e a computação assistida por acelerador é o futuro.

Esse argumento é, obviamente, o princípio central da Nvidia.

Mas Huang o apoiou com dados sobre o esforço necessário para produzir um modelo de linguagem grande (LLM), citando um sistema hipotético de 960 servidores que custou US$ 10 milhões e consumiu 11 Gwh para treinar um LLM.

O CEO afirmou que apenas um par de servidores Nvidia custando $ 400.000 e empacotando GPUs podem fazer o mesmo trabalho consumindo apenas 0,13 GWh. Ele também sugeriu que uma plataforma de US$ 34 milhões com Nvidia de 172 poderia produzir 150 LLMs enquanto consumia 11 GWh.

A teoria de Huang é que esse tipo de equipamento logo estará na lista de compras de muitas organizações porque, enquanto os datacenters estão sendo construídos em um ritmo furioso, a competição por espaço em racks e eletricidade permanecerá acirrada e muitos usuários, portanto, procurarão reprojetar seus datacenters para maior eficiência. e densidade.

É aí que entra a especificação MGX, oferecendo um design que pode usar mais produtos da Nvidia em um espaço menor do que seria o caso se eles fossem encaixados em uma máquina alimentada apenas por uma CPU. Huang sugeriu que o MGX oferece a densidade exigida pelos usuários. E pode abrigar CPUs x86 velhas e chatas, se necessário, ao lado de todos os adoráveis aceleradores da Nvidia.

ASRock Rack, ASUS, GIGABYTE, Pegatron, QCT e Supermicro se inscreveram para produzir os servidores, que Huang disse que podem ser implantados em mais de 100 configurações e em fatores de forma 1U, 2U e 4U.

Em agosto, a QCT entregará um projeto MGX denominado S74G-2U, que oferecerá a Superchip GH200 Grace Hopper . No mesmo mês, o ARS-221GL-NR da Supermicro incluirá o Grace CPU Superchip.

Huang também anunciou que a produção de Grace Hopper está em pleno andamento. O CEO sugeriu que poderia encontrar redes 5G domésticas e alguma IA generativa ao mesmo tempo, para preparar chats de vídeo à medida que passam pela rede, em vez de deixar os dispositivos clientes fazerem todo o trabalho de compactar e descompactar o vídeo.

Ele também descreveu uma grande mudança, a Spectrum-X Networking Platform, para melhorar a eficiência da Ethernet em nuvens de grande escala executando cargas de trabalho de IA.

E ele fez referências vagas à Nvidia, melhorando o suporte para sua pilha de software de IA, tornando-a mais adequada para uso corporativo, com a Red Hat oferecida como o modelo que a Nvidia pretende emular.

A robótica também esteve na cabeça do CEO, já que a Nvidia abriu uma plataforma chamada Isaac que combina software e silício para permitir a criação de bots autônomos para uso industrial, especialmente em armazéns onde Huang disse que eles rodarão para movimentar mercadorias.

Esses bots poderão fazer isso depois de serem criados em gêmeos digitais de espaços do mundo real desenvolvidos usando servidores repletos de hardware de aceleração da Nvidia.

O que novamente ilustrou por que a Nvidia criou o MGX. ®

.