.

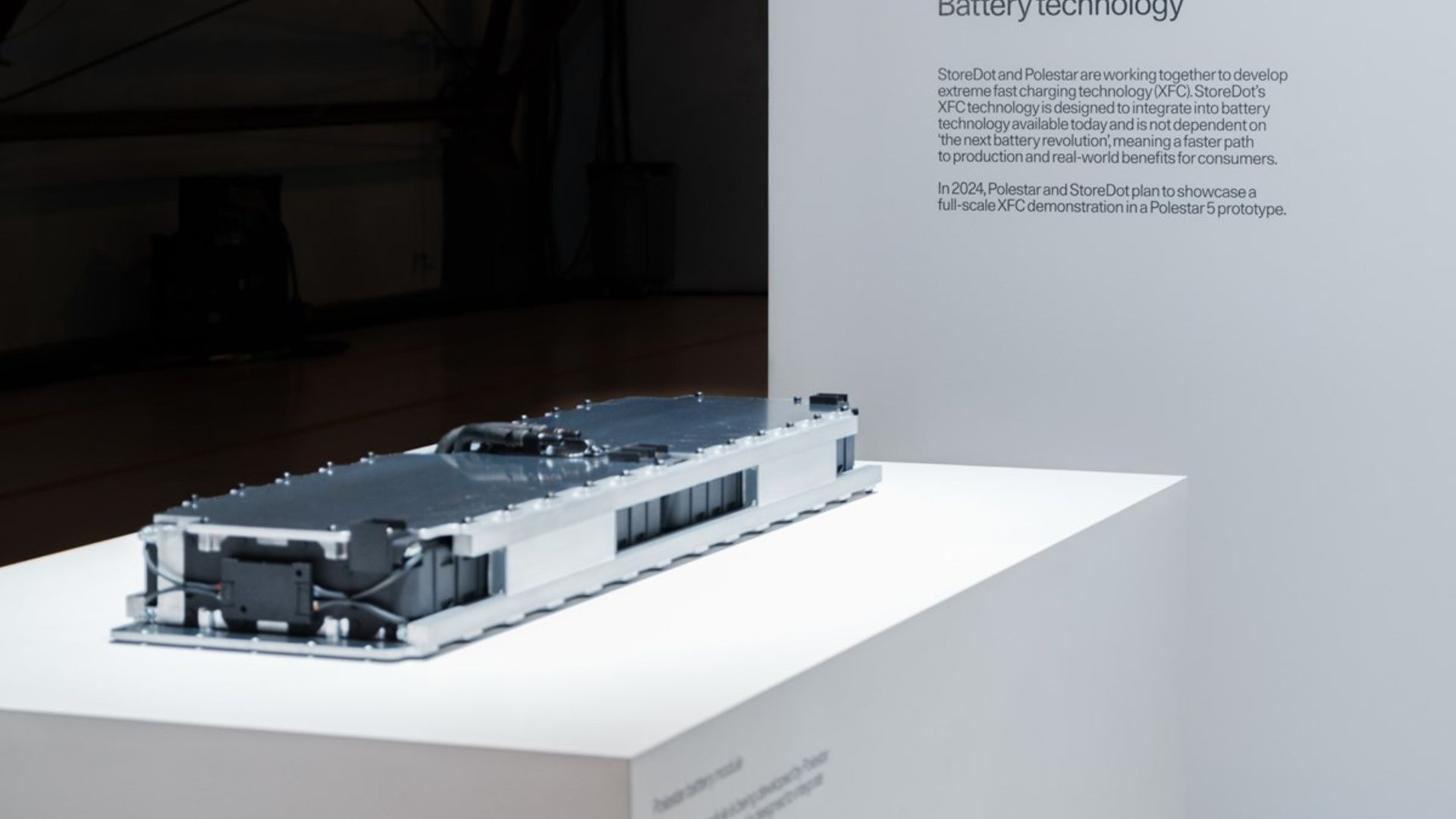

Com a rápida expansão do mercado de veículos elétricos (EV), soluções de baterias mais seguras, eficientes e acessíveis tornaram-se indispensáveis. As baterias de fosfato de ferro-lítio (LFP) têm tido uma maior aceitação tanto pelos fabricantes de veículos eléctricos como pelos consumidores porque apresentam uma combinação interessante de vantagens que impulsionarão o futuro do transporte eléctrico.

As baterias LFP possuem melhor estabilidade térmica e química quando comparadas com outras baterias de íon-lítio. Este aspecto reduz significativamente os riscos associados ao aquecimento e até mesmo à ocorrência de incêndio, garantindo assim a segurança dos fabricantes e também dos utilizadores. As baterias LFP também demonstraram ter um ciclo de vida mais longo e podem suportar mais ciclos de carga antes de precisarem ser substituídas, tornando-as mais sustentáveis em termos de uso a longo prazo.

Em comparação com outros íons de lítio tipos de bateria, as baterias LFP fornecem maior potência e eficiência ao longo de sua vida útil. A sua elevada densidade de energia torna os veículos elétricos mais eficientes em termos de espaço e peso, proporcionando uma autonomia alargada e um desempenho melhorado. Além disso, as baterias LFP suportam carregamento rápido, o que diminui o tempo de inatividade, facilitando a vida dos proprietários de carros elétricos.

A vantagem mais atraente das baterias LFP é o seu baixo custo. Eles são feitos de materiais abundantes e baratos, por isso oferecem uma solução barata que funcionaria bem para fabricantes ou compradores de EV neste caso. Portanto, as baterias LFP são uma escolha inteligente do ponto de vista econômico, sem comprometer a qualidade ou o desempenho.

Os dados usados para compilar este artigo foram provenientes de fontes confiáveis, incluindo o Departamento de Energia, para fornecer as informações mais atualizadas e precisas possíveis.

10 carros elétricos com as maiores baterias

Descubra os melhores EVs com baterias enormes, redefinindo autonomia, desempenho e conveniência no cenário dos veículos elétricos.

Segurança e longevidade aprimoradas

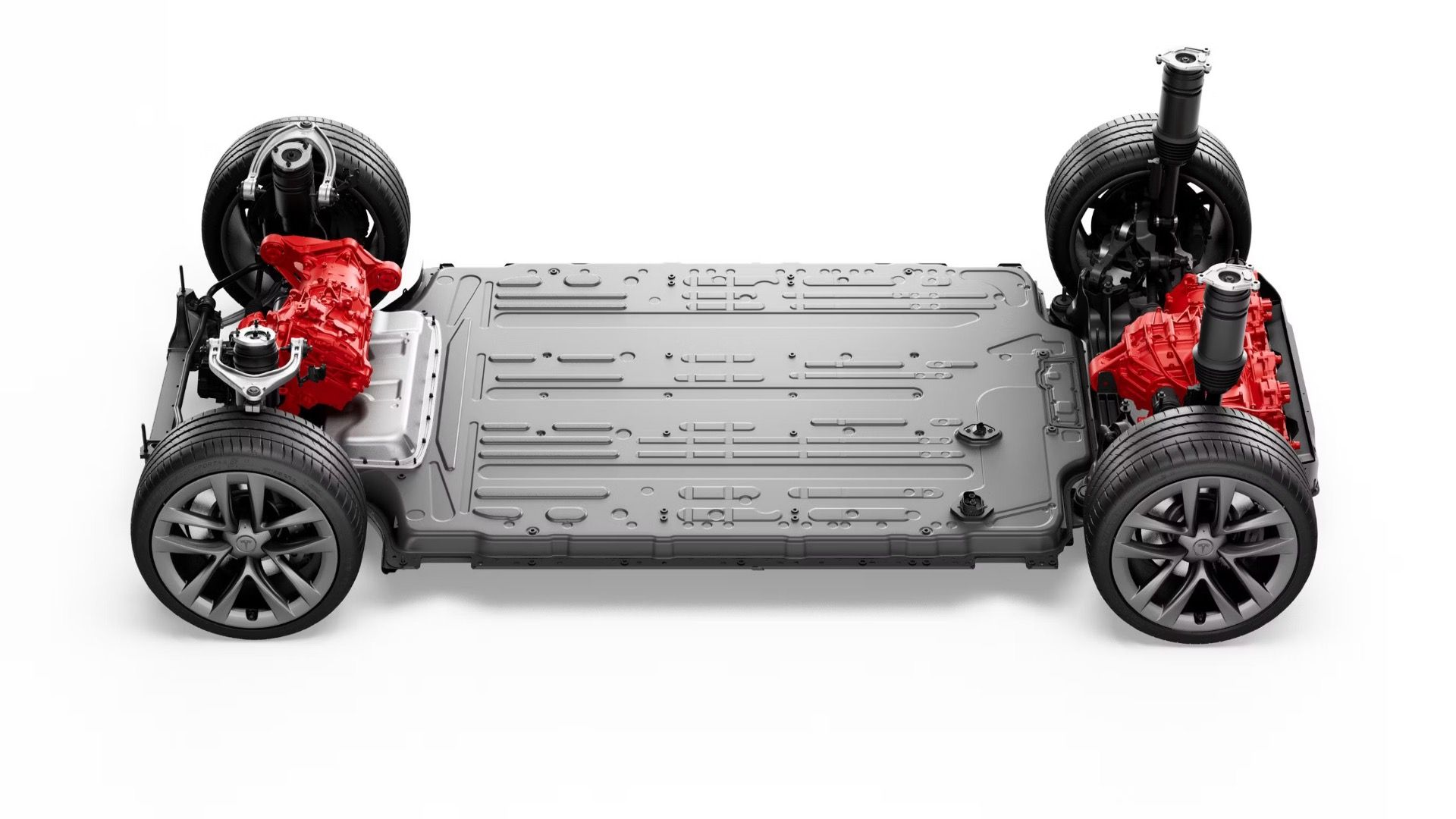

Dois aspectos que preocupam muitos proprietários em potencial ao mudar para um carro elétrico são a segurança e a longevidade da bateria do carro, que é um dos componentes principais de um EV. Existem conceitos errados sobre as baterias LFP não durarem o suficiente para tornar a propriedade de EV econômica ou propensa a pegar fogo. Ambas as narrativas não são precisas. Aqui está o porquê:

Uma bateria de veículo a gás tem uma vida útil média de cerca de 3 a 5 anos, mas as baterias de veículos elétricos modernos podem durar mais de 10 anos. Além disso, degradam-se lentamente ao longo do tempo, perdendo apenas uma fracção da sua capacidade anualmente. Portanto, embora o alcance possa diminuir ligeiramente, permanecerá operacional durante muitos anos. Normalmente, os fabricantes oferecem garantia de bateria de 8 a 10 anos ou até 160 mil quilômetros.

No entanto, se sujeita a condições extremas, qualquer bateria pode incendiar-se, mas a maioria das pessoas acredita que as baterias EV são geralmente seguras. Isso ocorre porque esses tipos de baterias têm melhor estabilidade térmica. Exemplos comuns são as baterias LFP, que têm excelente tolerância ao calor e, portanto, minimizam os riscos de superaquecimento e fuga térmica.

A maioria dos novos EVs tem vários recursos de segurança instalados que faltam nos carros movidos apenas a gasolina. Por exemplo, existem sistemas de segurança integrados que reconhecem quaisquer problemas potenciais associados à bateria, como sobreaquecimento e carregamento excessivo. Esta abordagem holística garante tranquilidade quando se trata de acidentes com incêndios causados por VEs. Portanto, embora as baterias LFP necessitem de cuidados e manutenção adequados, elas ainda sobrevivem às tradicionais em termos de durabilidade e segurança.

Estabilidade térmica

Entre os benefícios mais significativos das baterias LFP está a sua excepcional estabilidade térmica. Ao contrário de vários tipos de íons de lítio, as baterias LFP não superaquecem facilmente e geralmente não sofrem fuga térmica que possa causar incêndio ou até mesmo explosão. Esta estabilidade térmica melhorada torna-os mais seguros para os VE e, portanto, garante que condutores e produtores estejam em paz.

Além disso, as baterias LFP baseadas na química do fosfato de ferro-lítio desfrutam de uma estabilidade inerente, de modo que podem sobreviver a todos os tipos de condições extremas, incluindo altas temperaturas ou danos físicos, porque essas baterias não falharão catastroficamente em circunstâncias como muitas outras.

Como testar a degradação da bateria do seu Tesla

Existem algumas maneiras de testar se a bateria do Tesla se degradou mais rápido do que o normal, e aqui estão algumas delas.

Melhor desempenho e eficiência

Embora as preferências específicas dos compradores de VE variem dependendo das suas necessidades e circunstâncias individuais, alguns aspectos críticos são amplamente considerados como sendo importantes. mais importante ao comprar um EV. Por exemplo, alcance, tempos de carregamento e desempenho estão entre os mais típicos. Esses três fatores podem ser cruciais para determinar se um VE atende aos seus interesses, e é por isso que as baterias LFP têm um forte aqui.

Com os veículos elétricos se tornando mais comuns em todo o mundo, há uma demanda crescente por baterias de alta potência, econômicas e confiáveis. A importância das baterias de fosfato de íon-lítio (LFP) é digna de nota porque elas oferecem diversas vantagens que fazem com que os VEs tenham melhor desempenho e consumam menos energia. As baterias LFP oferecem uma experiência superior em termos de desempenho e eficiência em comparação com outras, levando-as a se tornarem o tipo de bateria preferido em veículos elétricos em todo o mundo.

Adicione TopSpeed ao seu feed do Google Notícias.

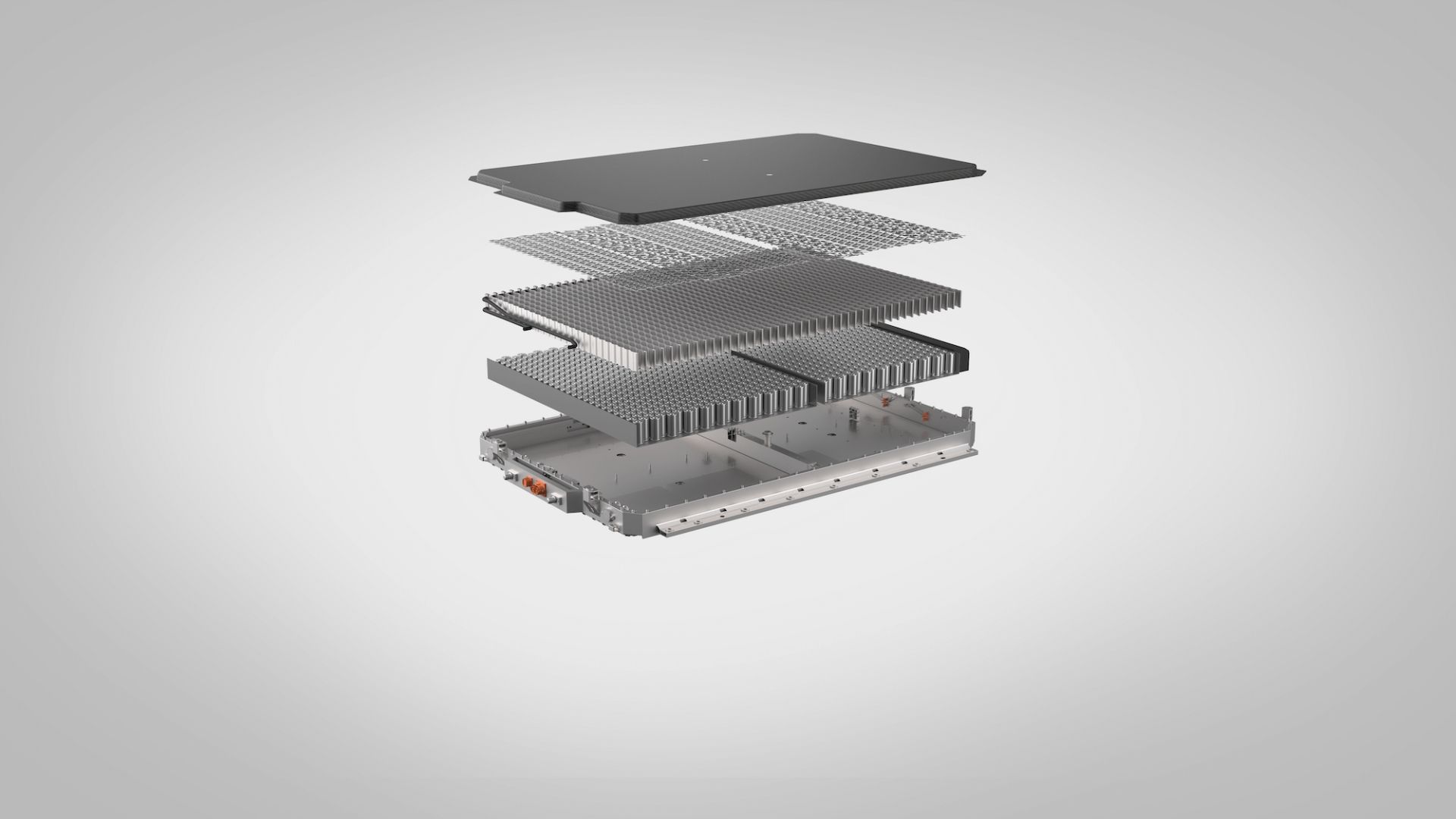

Alta densidade de energia

Um dos aspectos críticos das baterias LFP que contribuem para o seu melhor desempenho é a sua alta densidade de energia. A densidade de energia refere-se à quantidade de energia que uma bateria pode armazenar em relação ao seu peso ou volume. Embora as baterias LFP normalmente tenham uma densidade de energia ligeiramente menor em comparação com outras baterias de íons de lítio, avanços recentes em tecnologia reduziram significativamente esta lacuna. As baterias LFP modernas podem agora armazenar quantidades substanciais de energia, fornecendo energia suficiente para uma ampla gama de aplicações de veículos elétricos, desde passageiros urbanos até veículos maiores e de longa distância. Isto se traduz em vários benefícios para os VEs:

- Alcance extendido: Com mais energia acumulada, as baterias LFP permitem que os VE viajem mais longe com uma única carga, aumentando o seu alcance geral e praticidade.

- Eficiência aprimorada: O uso eficiente do espaço e do peso contribui para uma melhor eficiência geral do veículo. Isto se traduz em menor consumo de energia e distâncias de condução potencialmente mais longas.

- Flexibilidade de design aprimorada: A natureza compacta das baterias LFP permite maior flexibilidade no design do veículo. Os fabricantes podem utilizar o espaço economizado para outros componentes ou criar veículos mais elegantes e aerodinâmicos.

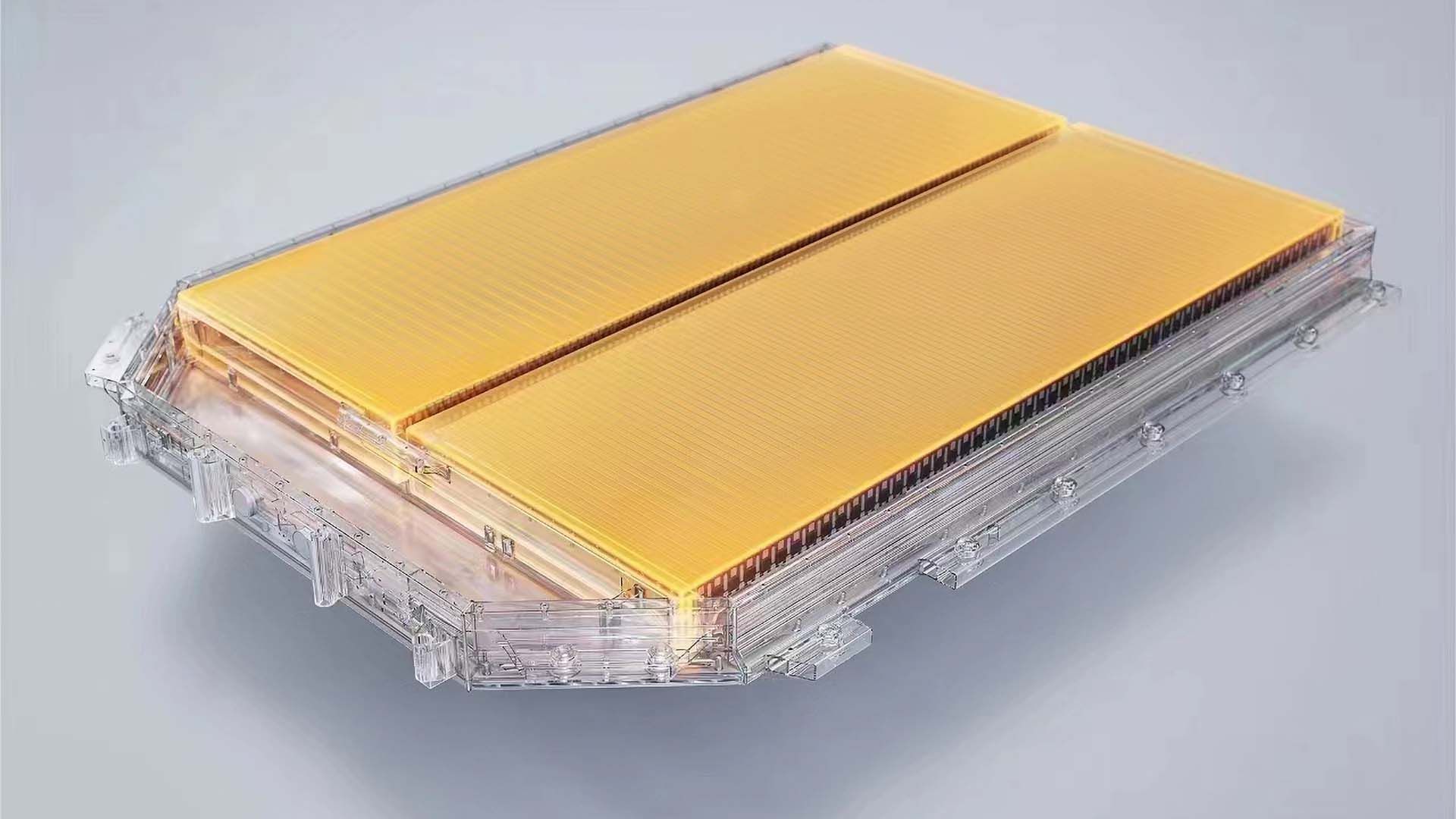

Capacidades de carregamento rápido

Uma das características mais interessantes das baterias LFP é a sua capacidade de lidar com carregamento rápido, reduzindo significativamente os tempos de carregamento em comparação com outros tipos de baterias de iões de lítio e tornando a propriedade de EV ainda mais conveniente. As baterias LFP são excelentes no carregamento rápido devido a vários fatores importantes. Primeiro, eles podem aceitar uma alta taxa de carga, permitindo-lhes reabastecer rapidamente os seus níveis de energia. Isto resulta em tempos de carregamento mais curtos em carregadores rápidos DC, minimizando o tempo de inatividade e maximizando o tempo de condução. Em segundo lugar, as baterias LFP possuem excelente estabilidade térmica. Ao contrário de outras baterias de íons de lítio, elas são altamente resistentes ao acúmulo de calor durante o carregamento.

Esta capacidade permite-lhes lidar com a maior entrada de energia associada ao carregamento rápido sem comprometer a segurança ou o desempenho. Por último, as baterias LFP sofrem degradação mínima devido ao carregamento frequente em alta velocidade em comparação com outros produtos químicos. Isso garante que os usuários possam se beneficiar do carregamento rápido sem se preocupar em reduzir significativamente a vida útil da bateria. Esses fatores combinados tornam as baterias LFP um divisor de águas para o carregamento de veículos elétricos. A sua capacidade de lidar com o carregamento rápido de forma eficiente e segura abre caminho para uma experiência de veículo elétrico mais conveniente e acessível.

Tudo o que você precisa saber sobre garantias de baterias EV e cobertura do fabricante

É sempre bom saber a cobertura da bateria do seu EV. Aqui estão alguns fatos sobre o setor que você pode se surpreender ao saber.

Custo-benefício

Um dos aspectos mais atraentes das baterias LFP para veículos elétricos é a sua relação custo-benefício. Um elemento crítico que os torna acessíveis é a utilização de materiais abundantes e baratos na produção. Ao contrário de outras baterias de íon-lítio que dependem de cobalto e níquel, as baterias LFP utilizam ferro e fosfato, que são mais abundantes e custam menos.

Assim, essas matérias-primas baratas diminuem os custos de fabricação das baterias LFP, tornando-as economicamente viáveis para a indústria. As baterias LFP também sobrevivem a outros tipos de células de íons de lítio. Eles duram de 3.000 a 4.000 ciclos antes de sofrerem um declínio significativo na capacidade causado por cargas e descargas.

Esta vida útil mais longa significa menos substituição da bateria ao longo da vida útil do automóvel, reduzindo as despesas de manutenção a longo prazo dos proprietários de veículos elétricos, incluindo os custos de carregamento. Consequentemente, através da utilização a longo prazo, esta funcionalidade irá poupar custos substanciais devido à durabilidade e fiabilidade, melhorando assim a proposta de valor global. Além disso, a melhoria da segurança e o baixo risco de fuga térmica reduzem a relação custo-benefício das baterias LFP.

Menos reclamações de garantia ou recalls são algumas economias obtidas com a redução da incidência, o que pode levar ao superaquecimento em tais dispositivos; isso implica que os fabricantes economizariam mais. Significativamente, os consumidores também podem beneficiar de prémios de seguro mais baratos, além de outras despesas relacionadas, se se sentirem seguros com a tecnologia de armazenamento mais segura disponível.

Impacto ambiental reduzido

Além disso, os benefícios ambientais aumentam a acessibilidade das baterias LFP. O método utilizado para produzir LFP tem uma pegada ambiental menor em comparação com outras baterias de iões de lítio porque não há cobalto envolvido no seu processo de produção. A promoção da sustentabilidade na conformidade regulamentar e nas práticas de gestão ambiental também pode reduzir custos que de outra forma poderiam ser incorridos.

Concluindo, os custos acessíveis dos materiais tornam as baterias LFP viáveis para VEs; sua longa vida útil melhora os recursos de segurança, enquanto o respeito ao meio ambiente e o baixo nível de resíduos tóxicos ajudam a manter os preços baixos, entre vários fatores que influenciam sua eficácia. Estas razões fazem com que fabricantes e consumidores se interessem pelas baterias LFP, uma vez que oferecem poupanças e valor consideráveis ao longo do tempo.

.