.

Um ataque israelense no sul do Líbano matou na quarta-feira um comandante sênior do Hezbollah, disse um oficial do Hezbollah à Associated Press, enquanto as tensões continuam entre os dois lados.

O ataque ocorreu perto da cidade costeira de Tiro, no sul, numa altura em que os esforços diplomáticos globais se intensificaram nas últimas semanas para evitar que a escalada dos confrontos entre o Hezbollah e o exército israelita se transformasse numa guerra total que poderia levar a um confronto directo entre Israel e Irão.

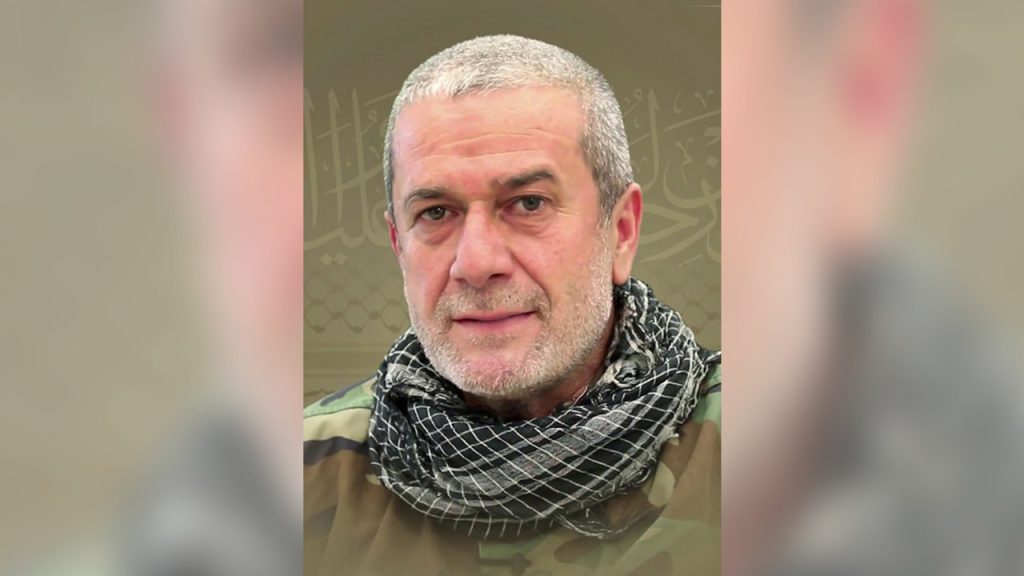

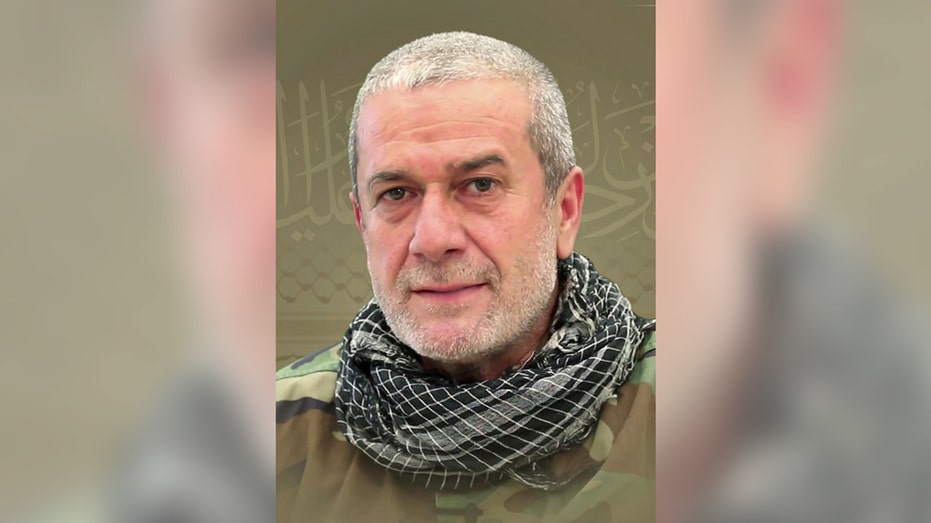

Uma declaração do Hezbollah dizia que o líder morto era Muhammad Nimah Nasser, apelidado de “Abu Nimah”, que é o seu nome de guerra. Um funcionário do Hezbollah, falando anonimamente de acordo com os regulamentos, disse que era o chefe da unidade Aziz do partido, uma das três divisões regionais no sul do Líbano.

O Irã promete apoio ao Hezbollah na luta contra Israel enquanto o general do IRGC renova a ameaça de ataque iminente com mísseis

Nasser é o oficial mais graduado do grupo apoiado pelo Irã a ser morto desde Talib Sami Abdullah, morto em um ataque aéreo em 11 de junho. O líder do Hezbollah, Hassan Nasrallah, disse num discurso em homenagem a Abdullah que ele desempenhou um papel fundamental na linha de frente desde o início dos confrontos em 8 de outubro, liderando a unidade de Nasr.

O Hezbollah disse que em resposta ao assassinato de Nasser lançou mísseis Falaq com ogivas pesadas que atingiram o quartel-general da 769ª Brigada do exército israelense em Kiryat Shmona além de 100 lotes de foguetes Katyusha que atingiram o quartel-general da 210ª Divisão israelense e a base aérea de Kal’a nas Colinas de Golã sírias ocupadas.

O grupo também publicou imagens de Nasser participando no que disseram ser uma operação em uma instalação militar israelense no sul do Líbano em 1999, quando estava sob ocupação.

Num vídeo divulgado pela mídia local, os moradores correram em direção a um carro carbonizado, de onde subia uma grande nuvem de fumaça. A Defesa Civil disse que os socorristas transportaram um ferido, cujo nome não foi revelado, para o hospital.

Os militares israelenses reconheceram o ataque, dizendo que Nasser, junto com Abdullah, eram “dois dos mais importantes combatentes do Hezbollah” no sul do Líbano. Ele acrescentou que Nasser liderou os ataques a partir do sudoeste do Líbano.

O Hezbollah disparou foguetes contra o norte de Israel um dia depois de um ataque surpresa do Hamas ao sul de Israel em outubro, levando a confrontos limitados ao longo da tensa fronteira. Os ataques aumentaram gradualmente desde então, à medida que o Hezbollah introduziu novas armas nos seus ataques e Israel atacou profundamente o Líbano.

O grupo confirma que irá parar os seus ataques assim que for alcançado um cessar-fogo na Faixa de Gaza. Até lá, afirma que continuará os seus ataques para aumentar a pressão sobre Israel e a comunidade internacional. As autoridades israelitas ameaçaram lançar uma operação militar mais ampla se o Hezbollah não parasse os seus ataques.

O vice-secretário-geral do Hezbollah, Sheikh Naim Qassem, disse em entrevista à Associated Press na segunda-feira que Israel não pode esperar que os ataques do partido permaneçam limitados se lançar uma operação militar dentro do Líbano, mesmo que pretenda manter o conflito abaixo do limiar de todos -fora guerra. Os aliados, incluindo milhares de milicianos apoiados pelo Irão no Iraque, ofereceram-se para se juntar ao Hezbollah nas linhas da frente.

Os ataques aéreos israelitas ao Líbano desde Outubro mataram mais de 450 pessoas, a maioria combatentes do Hezbollah, mas os mortos também incluem mais de 80 civis e não combatentes. Do lado israelita, 16 soldados e 11 civis foram mortos desde o início da guerra em Gaza. Dezenas de milhares de pessoas foram deslocadas em ambos os lados da tensa fronteira durante a guerra que durou meses.

O conselheiro sênior do presidente dos EUA, Joe Biden, Amos Hochstein, que tem viajado entre o Líbano e Israel, está programado para se encontrar com o enviado do presidente francês Emmanuel Macron ao Líbano, Jean-Yves Le Drian, em Paris, na quarta-feira, como parte de seus esforços diplomáticos em andamento para acabar com o conflito.

Autoridades francesas convidaram Hockstein à capital francesa para discutir os últimos desenvolvimentos nos seus esforços diplomáticos em curso, de acordo com funcionários da administração que falaram sob condição de anonimato porque não estavam autorizados a comentar publicamente.

.