.

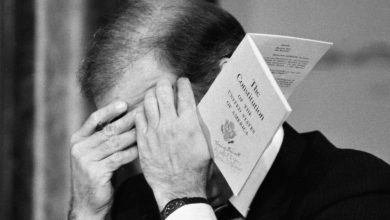

Algo está faltando no vídeo de lançamento da campanha de Mike Pence para a indicação republicana para a eleição presidencial de 2024. Alguém, na verdade. Há Joe Biden e Kamala Harris, seus inimigos políticos. Aparecem dois ex-presidentes: Abraham Lincoln e Ronald Reagan, que ele toma como exemplo. E há a revisão de sua carreira política, que inclui até imagens de Pence com Benjamin Netanyahu ou Vladimir Putin, mas a que não aparece em dois minutos e 44 segundos é aquele que foi seu chefe enquanto ele era vice-presidente: Donald Trump. No entanto, no primeiro comício de sua campanha, em Des Moines (Iowa), ele atacou seu ex-chefe pelo ataque ao Capitólio.”

.

.