.

A startup de aprendizado de máquina Lamini revelou que sua plataforma de refinamento de modelo de linguagem grande (LLM) estava rodando “exclusivamente” no silício da The House of Zen.

Recém-saído do modo furtivo no início deste ano, Lamini quer ajudar as empresas a construir e executar produtos generativos de IA, ajustando os modelos básicos existentes – pense no GPT3 da OpenAI ou no Llama 2 da Meta – em relação aos seus conjuntos de dados internos.

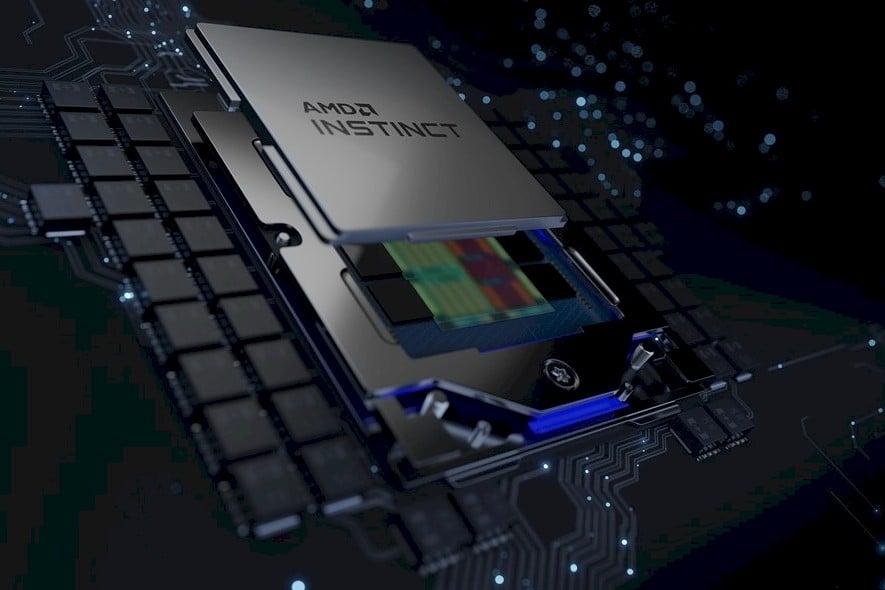

Se isso lhe parece familiar, é porque você já deve ter visto serviços semelhantes de empresas como a IBM com Watson-X. No entanto, o que diferencia o Lamini é a escolha do hardware. Embora a maioria dos grandes clusters de IA que vimos implantados pelo Google, Meta, Microsoft e outros estejam rodando em Nvidia A100s ou H100s, Lamini optou exclusivamente pelas GPUs Instinct da AMD.

Lamini afirma que sua plataforma, que atraiu o interesse da Amazon, Walmart, eBay, GitLab e Adobe, para citar alguns, está rodando em “mais de 100 GPUs AMD em produção durante todo o ano” e pode ser ampliada para “milhares de GPUs MI.”

As GPUs Instinct MI250X da AMD estão no centro de alguns dos supercomputadores mais poderosos do mundo, incluindo o no topo das paradas Supercomputador Frontier 1.1 exaflop, mas os MIs não tiveram o mesmo alarde que os chips da Nvidia.

Seguindo em frente, a AMD espera levar o mundo à história de seu acelerador. “Esta é a nossa prioridade estratégica número um e estamos nos envolvendo profundamente com todo o nosso conjunto de clientes para trazer soluções conjuntas ao mercado”, disse a CEO Lisa Su. disse durante uma ligação com analistas de Wall Street no início deste ano.

Durante a teleconferência de resultados do segundo trimestre da AMD no mês passado, Su vangloriou-se que a empresa viu um aumento de sete vezes no envolvimento dos clientes com IA desde o evento do datacenter em junho. “Está claro que a IA representa uma oportunidade de crescimento multibilionária para a AMD”, opinou ela. “Só no datacenter, esperamos que o mercado de aceleradores de IA atinja mais de US$ 150 bilhões até 2027.”

Esse aumento pode simplesmente se resumir à oferta e à demanda. Pelo menos para Lamini, um dos principais argumentos de venda por trás do hardware da AMD era que os clientes não ficariam presos esperando o envio das GPUs. “Você pode parar de se preocupar com prazos de entrega de 52 semanas para Nvidia H100s”, brincou a empresa em um blog.

O desafio do ecossistema da AMD

No entanto, o silício, por mais potente que seja, não levará você muito longe sem um software para rodar nele. Este é um dos desafios que o presidente da AMD, Victor Peng, tem enfrentado trabalhando em no ano passado com o Unified AI Stack da empresa. O objetivo deste projeto é desenvolver uma estrutura de software comum para executar cargas de trabalho de inferência em todo o crescente portfólio de hardware de IA da AMD, que agora inclui CPUs, GPUs Instinct e FPGAs Xilinx.

A fabricante de chips também trabalhou com PyTorch – uma estrutura popular de aprendizado de máquina – para suporte upstream para a pilha de software ROCm usada por suas GPUs Instinct. E, em junho, a empresa solicitado a ajuda da Hugging Face para otimizar modelos de IA de código aberto para rodar em seus chips.

A parceria com a Lamini marca a mais recente aposta no ecossistema da AMD para tornar o desenvolvimento de seus aceleradores Instinct e tempo de execução ROCm mais acessível. A startup afirma que usando seu software, o tempo de execução ROCm da AMD alcança paridade de software com o CUDA da Nvidia, pelo menos para modelos de linguagem grandes.

Desenvolver um ecossistema robusto de software de IA com o objetivo de desafiar a Nvidia não é apenas uma luta da AMD, é claro. Na semana passada, a Intel destacou o trabalho que tem feito para impulsionar a adoção das estruturas de software oneAPI e OpenVINO usadas por seus chips, e o CTO da empresa, Greg Lavender, até desafiado desenvolvedores usem IA para converter código CUDA legado para execução em seu tempo de execução SYCL de plataforma cruzada.

Hardware mais rápido a caminho

Os aceleradores Instinct MI200 usados nos sistemas da Lamini, que ela chama de LLM Superstations, foram introduzidos no final de 2021 e são bons para entre 181 e 383 TFLOPs de FP16, dependendo do formato. No entanto, os clientes da AMD não terão que esperar muito para obter um chip muito mais poderoso.

Os aceleradores da próxima geração da série Instinct MI300 da AMD serão lançados ainda este ano e prometem desempenho de IA 8x mais rápido, ao mesmo tempo em que alcançam desempenho 5x melhor por watt. Com base nessas afirmações, nosso site irmão A próxima plataforma estimativas o chip fornecerá algo em torno de 3 petaFLOPS de desempenho FP8 ou 1,5 petaFLOPS de desempenho FP16.

O primeiro deles, apelidado de MI300A – “A” sendo para APU – emparelha 24 núcleos Zen 4 com seis matrizes de GPU CDNA 3 e até 128 GB de memória de alta largura de banda de terceira geração (HBM3). O chip, que já está em amostragem para os clientes, é programado para alimentar o próximo supercomputador El Capitan do Laboratório Nacional Lawrence Livermore.

A versão do chip apenas com GPU, apelidada de MI300X, valas os núcleos da CPU em favor de mais duas GPUs morrem e aumentam o fornecimento de HBM3 para 192 GB – mais que o dobro do carro-chefe da Nvidia, H100. Assim como os aceleradores Instinct anteriores, até oito dessas GPUs podem ser combinadas usando a “Arquitetura Infinity” da AMD.

De acordo com a AMD, podemos esperar que esses chips comecem a chegar aos fornecedores ainda neste trimestre. ®

.