.

O West Ham United contratou Carlos Soler por empréstimo do Paris Saint-Germain para a temporada 2024/25.

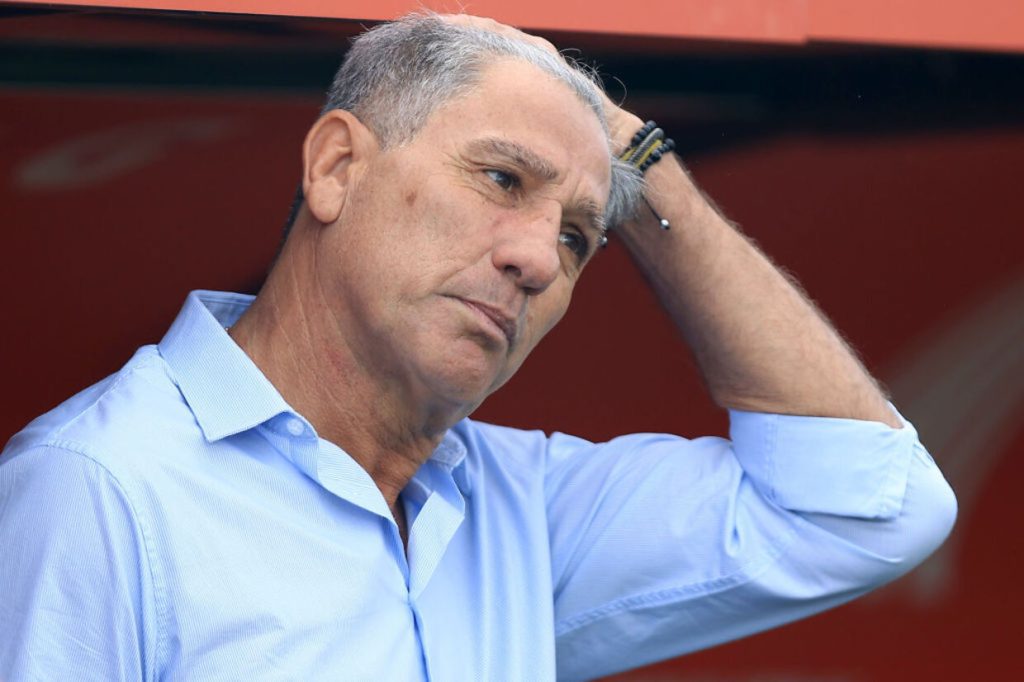

Os Hammers estão entre os operadores mais ocupados da Europa na janela de transferências de verão, com a chegada de Soler no final do prazo final, o que significa que eles adicionaram nove jogadores ao elenco do novo técnico Julen Lopetegui.

“Estou muito animado por estar aqui como jogador do West Ham”, disse Soler aos canais do clube.

“Sempre foi um sonho meu jogar na Premier League, e fazer isso em Londres com um clube como o West Ham é uma sensação incrível.

“Mal posso esperar para sentir o apoio dos torcedores, dos quais já ouvi falar muito em conversas com pessoas que conhecem o clube, como meu bom amigo Pablo Fornals.

“Estou animado para conhecer meus novos companheiros de equipe e dar tudo de mim por este clube na melhor liga do mundo.”

Soler entrou e saiu do time principal do PSG durante seus dois anos na capital francesa após sua transferência em 2022 do clube de infância Valencia. Ele foi convocado 14 vezes pela Espanha, mas não fez parte do time que venceu a Euro 2024.

A contratação de Soler pelo West Ham foi finalizada logo após o empréstimo de James Ward-Prowse ao Nottingham Forest, enquanto o PSG também se despediu de Manuel Ugarte, que se juntou ao Manchester United em uma transferência permanente.

LEIA AS ÚLTIMAS NOTÍCIAS E FOFOCAS SOBRE TRANSFERÊNCIAS DE TODO O MUNDO

.