.

Hoje, as soluções de armazenamento em nuvem são uma parte essencial de nossa vida diária, a ponto de todos os principais sistemas operacionais virem com suporte para esses serviços de nuvem “integrados”.

Os serviços de armazenamento em nuvem são mais fáceis do que nunca de acessar, oferecem armazenamento gratuito e, como bônus, podem tornar sua vida miserável se você quiser acessar qualquer coisa armazenada lá usando um aplicativo peculiar em vez de seu navegador da web.

É por isso que você pode encontrar ferramentas extras de terceiros que auxiliam no uso do armazenamento em nuvem “como uma unidade normal”. Para este artigo, porém, faremos o mesmo explorando a funcionalidade de pastas compartilhadas integradas do Windows!

Problemas comuns de armazenamento em nuvem que você pode encontrar no Windows

Dropbox, Google Drive e serviços semelhantes de armazenamento/sincronização em nuvem são fáceis de acessar a partir de um navegador da Web ou do gerenciador de arquivos padrão do sistema operacional. Porém, quando você exige mais do que simplesmente acessar seus arquivos, pode ter problemas.

- O Dropbox pode ser acessado a partir de um link no gerenciador de arquivos que leva você à sua pasta local real, dentro da qual seus arquivos são sincronizados. Como alternativa, você mesmo pode visitar essa pasta. O Dropbox não pode ser “acessível por meio de uma carta” por padrão.

- O Google Drive oferece a opção de mapear todas as contas para uma letra de unidade. No entanto, tente acessar o conteúdo da unidade virtual “atrás” de sua letra de unidade “oficial”. Em vez de seus arquivos do Google Drive, você encontrará um link para sua pasta local.

- Outras alternativas podem ser ainda piores, com algumas acessíveis apenas localmente por meio de seus clientes personalizados.

Portanto, é impossível ter a “pasta raiz” da sua conta de armazenamento em nuvem acessível diretamente de uma letra de unidade?

Felizmente, você pode usar uma solução de terceiros para isso. Eles geralmente são diretos e podem fazer seu armazenamento em nuvem “se comportar” como uma unidade normal em seu computador. Ainda assim, convém evitar esses aplicativos por vários motivos.

- A maioria custa dinheiro ou é suportada por anúncios.

- Você estará dando acesso aos seus dados para outro terceiro (além do provedor de armazenamento em nuvem).

- Quanto mais aplicativos e serviços tiverem acesso aos seus arquivos, maiores serão as chances de eles caírem em mãos erradas após uma violação de segurança.

- Software e serviços extras se traduzem em maior complexidade e potencial de falha: alguns arquivos podem não sincronizar quando você espera, metadados podem ser perdidos, etc.

O principal argumento contra eles é que não há razão para usar mais software do que o necessário.

Por que não usar apenas as pastas do Google Drive?

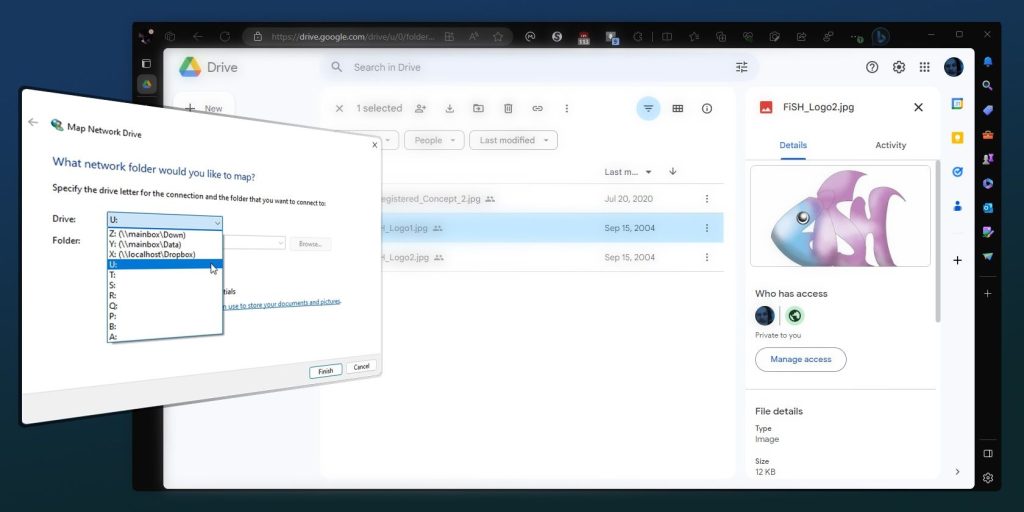

Vamos ver como o Google Drive não oferece acesso adequado à sua pasta local por meio de uma carta.

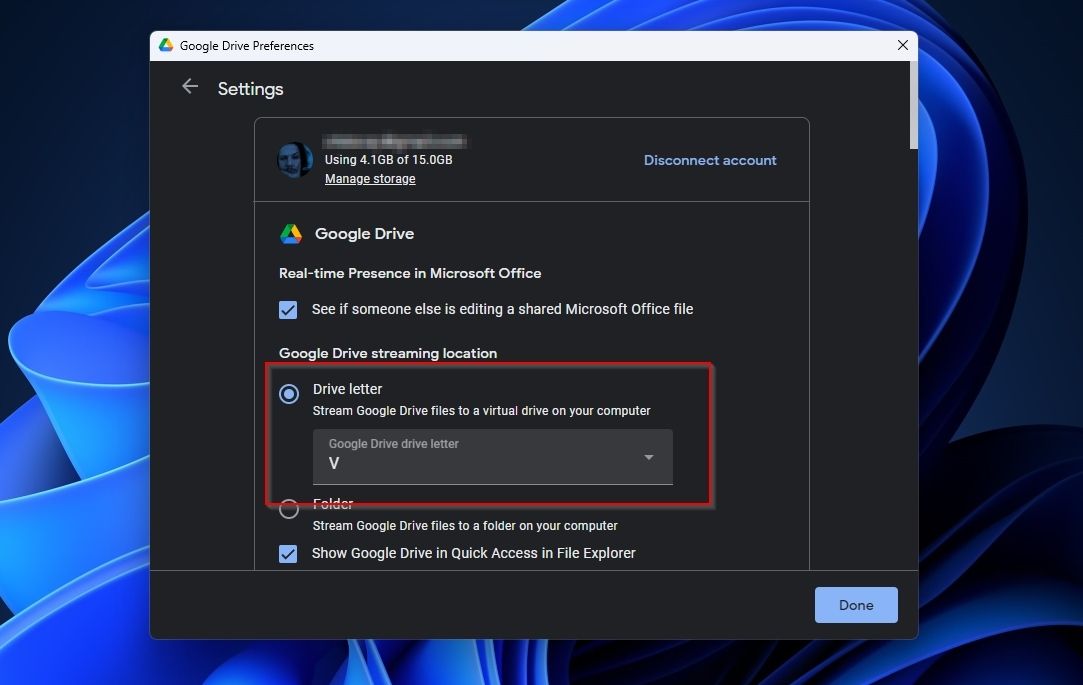

- Clique com o botão direito em ícone do Google Drive na bandeja, clique no botão ícone de engrenagem no canto superior direito para acessar seu menu e escolha Preferências. Clique no ícone de engrenagem na janela Preferências do Google Drive para acessar as configurações da sua conta. Verifique se há uma letra de unidade atribuída ao seu Google Drive.

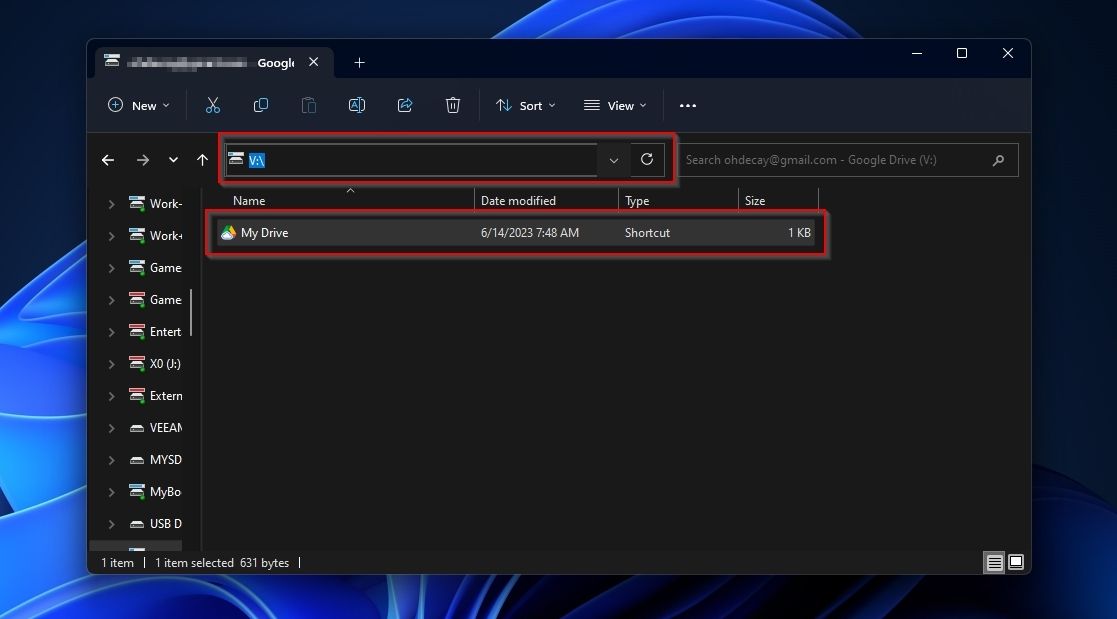

- Visite o real letra da unidade através de qualquer gerenciador de arquivos e se perguntar como há uma pasta “Meu Drive” em vez de seus arquivos.

- Tente “entrar” nessa pasta e maravilhe-se com a forma como o caminho muda para o verdadeiro onde a pasta do Google Drive está armazenada, possivelmente quebrando alguns aplicativos.

Agora, vamos corrigir, ou melhor, “contornar” esse pequeno problema explorando como as pastas de rede funcionam no Windows.

Como configurar pastas compartilhadas do Windows

A primeira parte do processo será “compartilhar” a pasta real usada pelo serviço de armazenamento em nuvem que queremos acessar diretamente de uma unidade. Não se preocupe; você não estará compartilhando nada com ninguém (além do provedor de serviços em nuvem onde você já mantém seus arquivos).

Para este exemplo, vamos trocar os serviços de nuvem e “fazer Dropbox”, mas você pode usar o mesmo processo com a pasta local de qualquer serviço de armazenamento em nuvem.

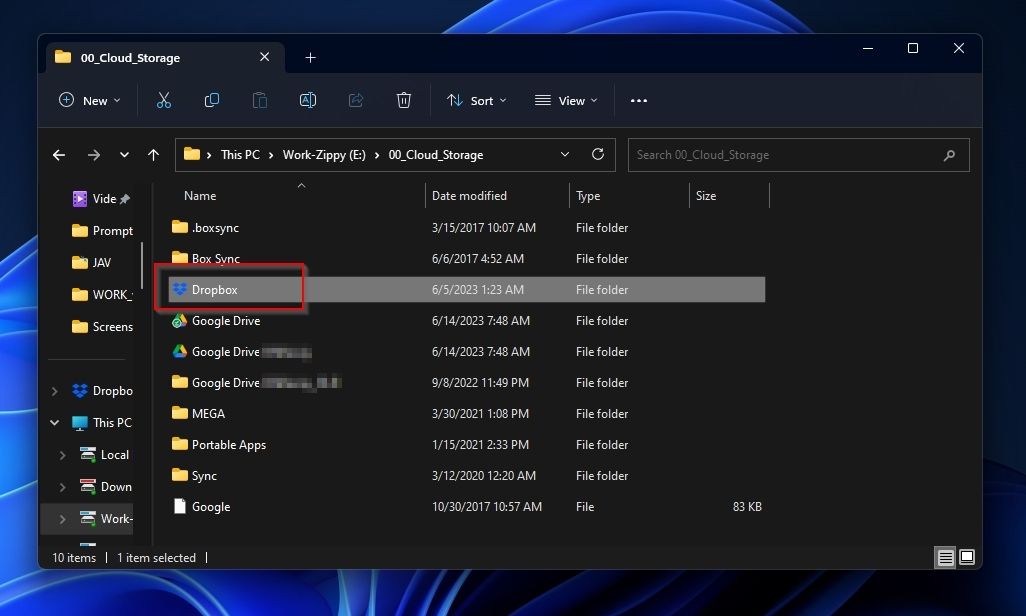

- Execute seu gerenciador de arquivos favorito e visite o caminho “diretamente acima” de sua pasta de armazenamento em nuvem (para que você possa vê-lo em seu gerenciador de arquivos).

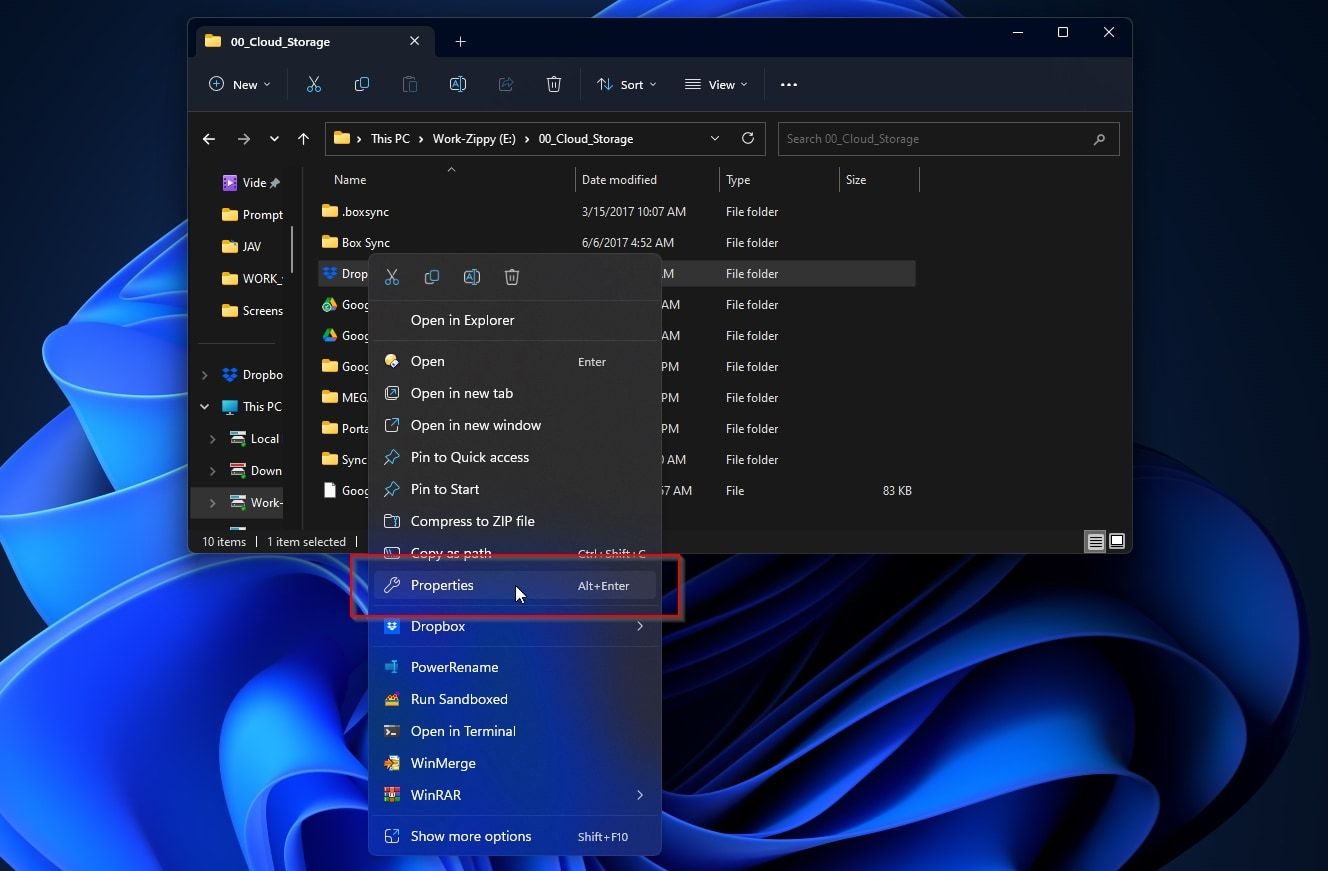

- Clique com o botão direito na pasta e escolha Propriedades.

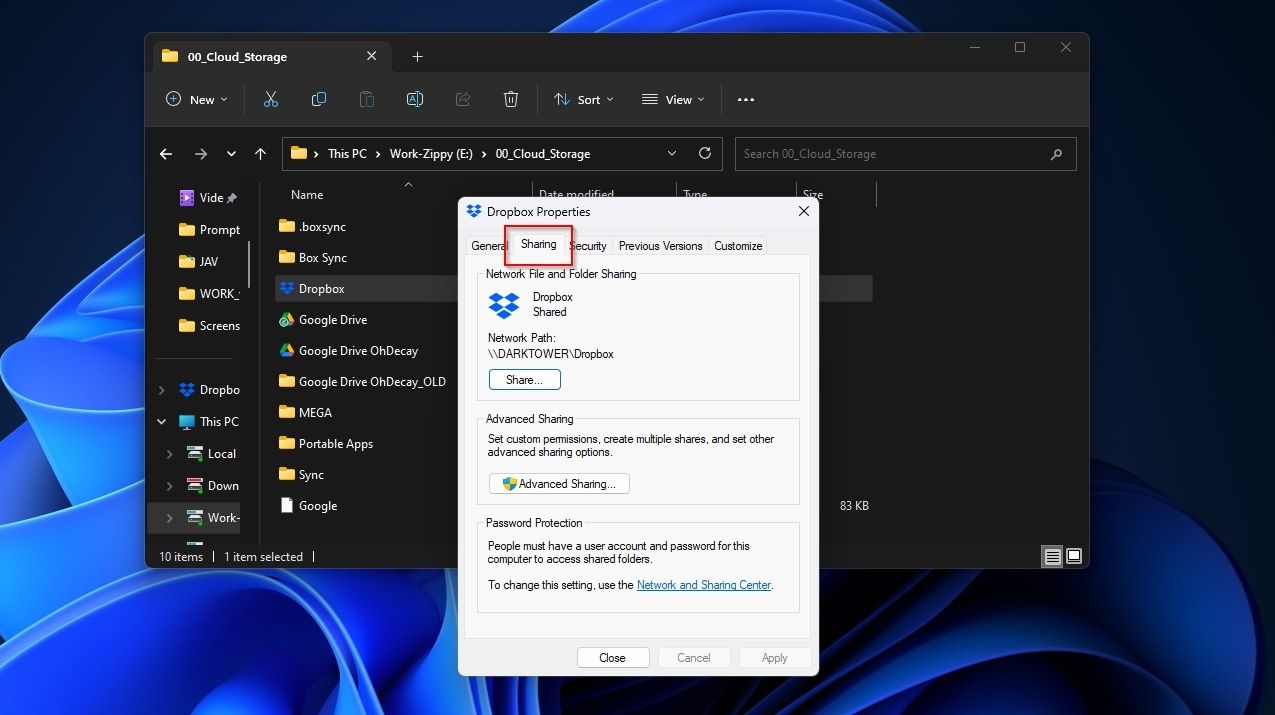

- Mover para o Compartilhamento guia e habilite o compartilhamento para sua pasta. Se precisar de ajuda, consulte nosso guia sobre como acessar pastas compartilhadas no Windows.

Como atribuir letras a pastas de armazenamento em nuvem “em rede”

Sua pasta deve estar acessível “como um compartilhamento” agora, mas ainda não está mapeada para uma letra. Para isso, usaremos a capacidade do Windows de atribuir letras a “unidades de rede” para facilitar o acesso.

Felizmente, o Windows também reconhece a pasta compartilhada como “uma unidade de rede”, mesmo que esteja armazenada localmente.

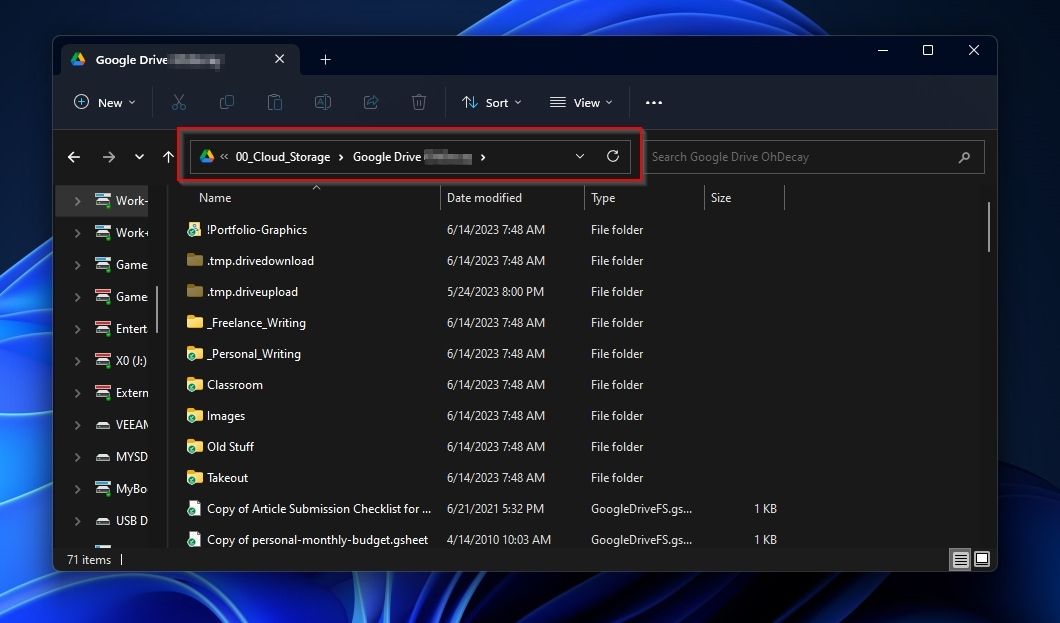

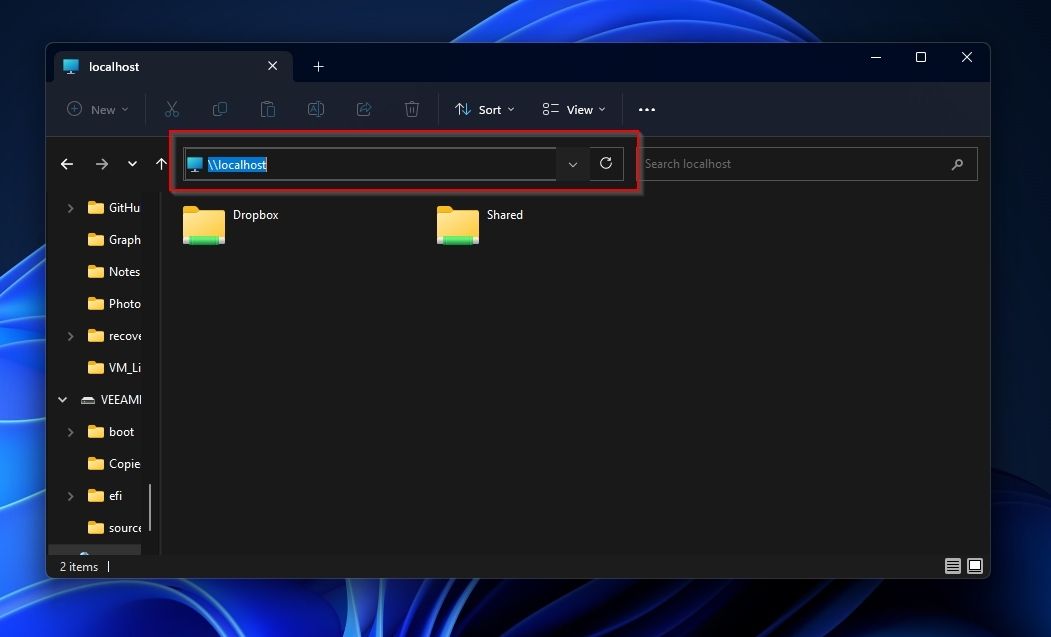

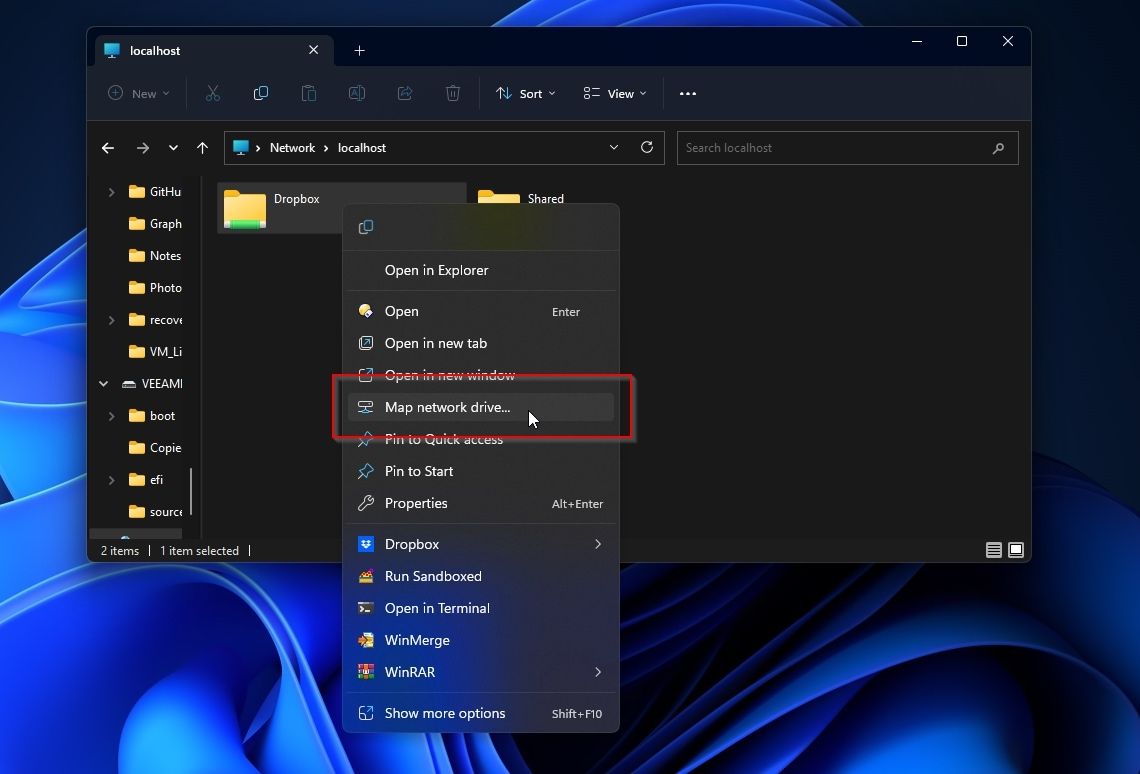

- Tipo “\localhost” na barra de localização do seu gerenciador de arquivos para ver todas as pastas compartilhadas em seu PC local. Entre elas deve estar sua pasta de armazenamento em nuvem recém-compartilhada.

- Clique com o botão direito sobre ele e escolha Mapear unidade de rede.

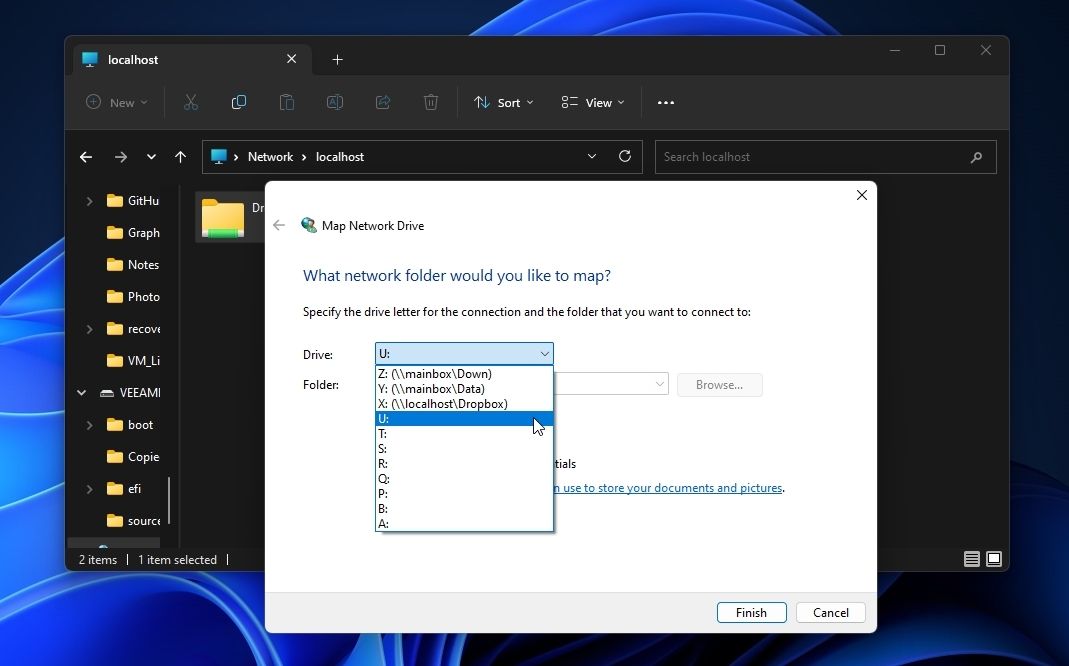

- Escolha o carta você deseja atribuir à sua pasta de armazenamento em nuvem no menu suspenso ao lado de Dirigir. Clique Terminar para aplicar a alteração.

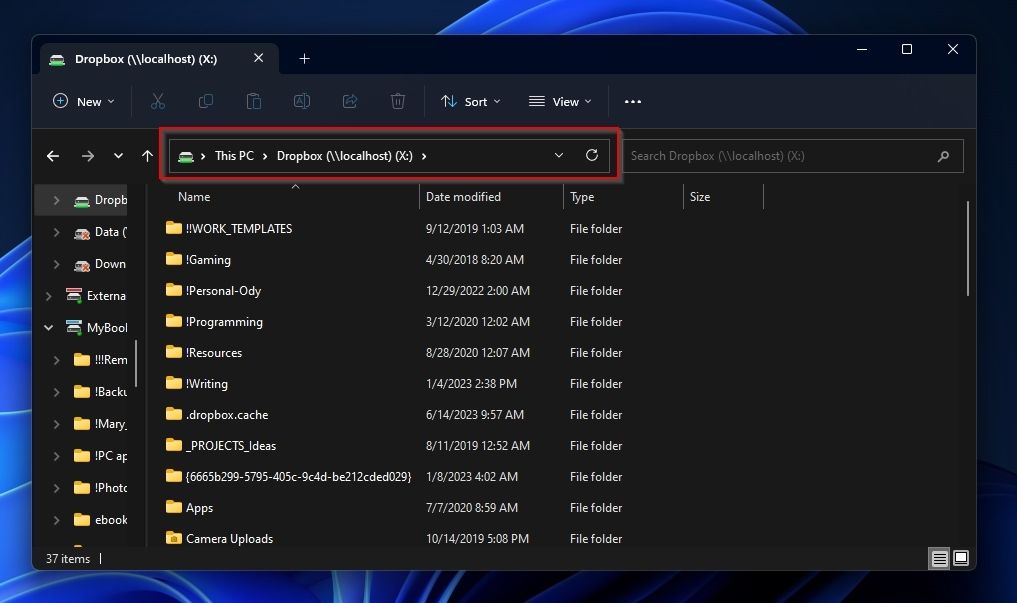

- Visite sua “nova unidade” usando a letra que você atribuiu e deverá ter acesso direto ao conteúdo do seu armazenamento em nuvem.

O acima implica que você configurará seu cliente de armazenamento em nuvem para sincronizar totalmente todos os arquivos e pastas/mantê-los armazenados localmente.

E quanto ao uso do Subst?

Você pode se perguntar por que não usamos subst neste guia. Na verdade, o subst é tão útil que o incluímos em nossa lista de comandos essenciais do Windows CMD que você deve conhecer. Mas o que é, como pode ajudar e como usá-lo?

Abra a Pesquisa do Windows com Vitória + Sprocurar “terminal” ou “PowerShell“, e escolha Executar como administrador. Lá, use subst como:

subst DRIVE_LETTER: FULL:PATHTOFOLDER

Por exemplo, para mapear a pasta “c:Cloud DrivesDropbox” para a letra “Z”, o comando seria:

subst Z: "C:Cloud DrivesDropbox"

Depois disso, sua pasta deve estar acessível a partir da unidade que você atribuiu a ela. Se a alteração não for aparente imediatamente, faça logoff e logon novamente ou reinicie o computador.

Uma pasta local para seu armazenamento em nuvem no Windows

Graças à lógica um tanto quadrada da Microsoft de “se for uma pasta compartilhada, você pode mapeá-la, não importa onde esteja”, é fácil acessar suas pastas de armazenamento em nuvem diretamente de uma letra de unidade. Só é preciso compartilhá-los com você mesmo!

É claro que usuários avançados provavelmente prefeririam “subscrevê-los” à submissão. Estranhamente, muitos esquecem que “subst” também pode ser usado com pastas de armazenamento em nuvem. Apesar do caminho escolhido, provavelmente podemos marcar esse pequeno incômodo ao usar pastas de armazenamento em nuvem com um “problema resolvido”.

.