.

Depois de 17 anos como editor de histórias curtas de ficção científica e fantasia na Clarkesworld, a revista online e impressa que fundou em 2006, Neil Clarke tornou-se adepto de filtrar casos ocasionais de plágio das centenas de envios que recebe todos os meses.

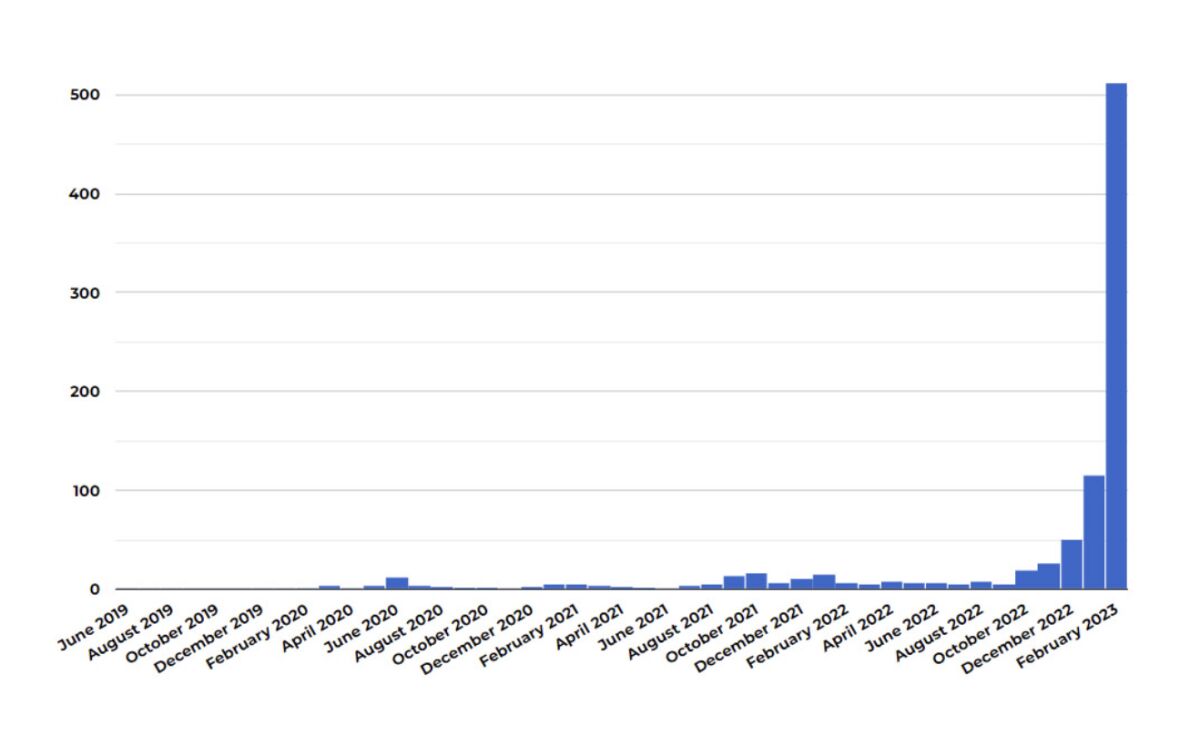

O problema aumentou durante a fase de bloqueio da pandemia, quando os trabalhadores confinados em casa buscavam maneiras de aumentar a renda. Mas explodiu em dezembro, depois que a OpenAI, com sede em São Francisco, lançou publicamente seu programa ChatGPT, uma máquina geradora de prosa especialmente sofisticada.

Clarke calcula que das 1.200 submissões que recebeu este mês, 500 foram escritas à máquina. Ele encerrou as aceitações de envios até pelo menos o final do mês, mas está confiante de que, se não tivesse feito isso, a pilha artificial teria alcançado a paridade com os envios legítimos até então – “e provavelmente passaria”, diz ele .

Toda essa mania tomou conta do mundo e todos estão em frenesi.

— H. Holden Thorp, editor-chefe da Science

“Não vimos nenhuma razão para acreditar que estava diminuindo”, diz Clarke, 56. Como fez com os plagiadores, ele rejeitou o conteúdo gerado por máquina e baniu permanentemente os remetentes.

Um veterano da indústria de software, Clarke desenvolveu regras práticas que lhe permitem identificar a prosa escrita à máquina; ele não os compartilha, preocupado com o fato de que ajustes simples permitiriam que os usuários contornassem seus padrões. “Eles ainda seriam histórias ruins e ainda seriam rejeitados, mas seria 10 vezes mais difícil para nós.”

Boletim de Notícias

Receba as novidades de Michael Hiltzik

Comentários sobre economia e muito mais de um vencedor do Prêmio Pulitzer.

Ocasionalmente, você pode receber conteúdo promocional do Los Angeles Times.

Os sistemas reguladores mal começaram a contemplar as implicações legais de programas que podem vasculhar a web em busca de matéria-prima, incluindo a perspectiva de violação generalizada de direitos autorais e falsificação em prosa e arte.

A aparência de autenticidade “tornará a IA generativa atraente para uso malicioso, onde a verdade é menos importante do que a mensagem que ela transmite, como campanhas de desinformação e assédio online”, escreve Alex Engler, da Brookings Institution.

O ataque de material escrito por máquina tornou-se o tópico A na indústria de periódicos, porque o ChatGPT e programas semelhantes conhecidos como chatbots demonstraram ser capazes de produzir prosa que imita a escrita humana em um grau surpreendente.

“Todo mundo está falando sobre isso, e muitas pessoas estão focadas no que isso significará para a publicação científica”, diz H. Holden Thorp, editor-chefe da família de periódicos Science. “Toda essa mania tomou conta do mundo e todos estão em frenesi.”

A ciência impôs a política mais rígida sobre conteúdo gerado por ferramentas de inteligência artificial, como chatbots, entre editores técnicos: é proibido, ponto final.

A proibição das publicações inclui “texto gerado a partir de IA, aprendizado de máquina ou ferramentas algorítmicas semelhantes”, bem como “figuras, imagens ou gráficos que os acompanham”. Os programas AI não podem ser listados como autores. A Science adverte que tratará uma violação desta política como “má conduta científica”.

Thorp explicou ainda em um editorial que o uso de programas como o ChatGPT violaria o princípio fundamental da Science de que seus autores devem certificar que o trabalho enviado é “original”. Isso é “o suficiente para sinalizar que o texto escrito pelo ChatGPT não é aceitável”, escreveu ele: “Afinal, é plagiado do ChatGPT”.

Isso vai além das regras impostas pela Nature, que está no topo das revistas científicas de prestígio ao lado da Science. Os periódicos da Nature especificam que os programas geradores de linguagem não podem ser creditados como autores em um trabalho de pesquisa, como foi tentado em alguns artigos publicados: “Qualquer atribuição de autoria traz consigo a responsabilidade pelo trabalho”, explica a Nature, “e As ferramentas de IA não podem assumir essa responsabilidade.”

Mas a Nature permite que os pesquisadores usem essas ferramentas na preparação de seus artigos, desde que “documentem esse uso nas seções de métodos ou agradecimentos” ou em outra parte do texto.

Thorp me contou que a Science optou por uma postura mais firme para não repetir as dificuldades surgidas com o advento do Photoshop, que permite a manipulação de imagens, na década de 1990.

Submissões de ficção científica e fantasia plagiadas ou geradas por chatbots recebidas pela revista Clarkesworld de Neil Clarke, por mês. O grande aumento nos últimos meses é em grande parte de envios escritos por chatbots, respondendo por quase 40% do total de envios em fevereiro.

(Neil Clarke)

“No começo, as pessoas faziam muitas coisas com o Photoshop em suas imagens que agora consideramos inaceitáveis”, diz ele. “Quando surgiu, não tínhamos muitas regras sobre isso, mas agora as pessoas gostam de voltar a papéis antigos e dizer: ‘Veja o que eles fizeram com o Photoshop’. Não queremos repetir isso. ”

As revistas Science vão esperar até que a comunidade científica se una em torno de padrões para o uso aceitável de programas de IA antes de reconsiderar suas regras, diz Thorp: “Estamos começando com um conjunto bastante rígido de regras. É muito mais fácil afrouxar suas diretrizes mais tarde do que apertá-las.”

Subjacente às preocupações sobre o ChatGPT e seus primos de IA, no entanto, estão o que podem ser impressões exageradas sobre como eles realmente são bons em replicar o pensamento humano.

O que tem sido consistentemente negligenciado, em parte devido ao poder do hype, é o quão ruins eles são nos processos intelectuais que os humanos executam naturalmente e, geralmente, quase sem falhas.

As narrativas crédulas da mídia sobre o “brilho” do ChatGPT se concentram nesses sucessos “sem um olhar sério sobre o escopo dos erros”, observam os cientistas da computação Gary Marcus e Ernest Davis.

Felizmente, eles compilaram um banco de dados de centenas de flops às vezes risíveis do ChatGPT, Bing da Microsoft e outros programas geradores de linguagem: por exemplo, sua incapacidade de realizar aritmética simples, contar até cinco, entender a ordem dos eventos em uma narrativa ou imaginar que uma pessoa pode ter dois pais – para não mencionar sua tendência de preencher lacunas em seu conhecimento com invenções.

Os arautos da IA afirmam que essas deficiências serão eventualmente resolvidas, mas quando ou mesmo se isso acontecerá é incerto, dado que os próprios processos de raciocínio humano não são bem compreendidos.

A glorificação das supostas habilidades do ChatGPT ignora que o programa e outros chatbots basicamente vasculham a Internet em busca de conteúdo existente – blogs, mídias sociais, livros antigos digitalizados, diatribes pessoais de ignorantes e dissertações eruditas de sábios – e usam algoritmos para reunir o que encontram em uma maneira que imita, mas não é, senciência.

Conteúdo gerado por humanos é sua matéria-prima, designers humanos os “treinam” onde encontrar o conteúdo para responder a uma consulta, algoritmos escritos por humanos são seu conjunto de instruções.

O resultado se assemelha a um truque de ilusionista. Os chatbots parecem ser humanos porque cada linha de saída é um reflexo da entrada humana.

O espanto que os humanos experimentam com a aparente sensibilidade dos chatbots não é um fenômeno novo. Ele evoca o que Joseph Weizenbaum, o inventor do Eliza, um programa de linguagem natural da década de 1960 que poderia replicar as respostas de um psicoterapeuta às queixas de um “paciente”, notado nas reações emocionais dos usuários que interagem com o programa.

“O que eu não havia percebido”, escreveu ele mais tarde, “é que exposições extremamente curtas a um programa de computador relativamente simples podem induzir pensamentos delirantes poderosos em pessoas bastante normais”.

É verdade que o ChatGPT é bom o suficiente em imitação para enganar até mesmo profissionais educados à primeira vista. De acordo com uma equipe de pesquisadores da University of Chicago and Northwestern, quatro revisores médicos profissionais conseguiram selecionar corretamente 68% dos resumos gerados pelo ChatGPT de artigos científicos publicados de uma pilha de 25 resumos genuínos e gerados por chat. (Eles também identificaram incorretamente 14% dos resumos genuínos como escritos à máquina.)

A Nature relata que “o ChatGPT pode escrever redações apresentáveis para estudantes, resumir trabalhos de pesquisa, responder a perguntas bem o suficiente para passar em exames médicos e gerar código de computador útil”.

Mas todas essas são categorias bastante genéricas de escrita, tipicamente infundidas com linguagem mecânica. “IA não é criativa, mas iterativa”, diz John Scalzi, autor de dezenas de livros de ficção científica e contos que se opôs ao uso por sua editora, Tor Books, de arte gerada por máquina para a capa do último livro de um colega autor. romance.

(Tor disse em uma declaração publicada que não sabia que a arte da capa “pode ter sido criada por IA”, mas disse que, devido aos cronogramas de produção, não teve escolha a não ser seguir em frente com a capa assim que soube da fonte. A editora disse que “defendeu criadores no SFF [that is, science fiction and fantasy] comunidade desde a nossa fundação e continuaremos a fazê-lo.”)

Sobre a perspectiva de que o conteúdo gerado por máquina continuará a melhorar, “acho que é inevitável que atinja um nível de ‘bom o suficiente’”, diz Scalzi. “Não acho que a IA criará uma obra de arte duradoura semelhante a um ‘Meridiano de Sangue’ ou ‘Como Stella recuperou seu ritmo’”, disse ele, referindo-se aos romances de Cormac McCarthy e Terry McMillan, respectivamente.

Neste momento, o uso não divulgado ou mal divulgado de chatbots tem sido tratado como uma ofensa profissional quase comparável ao plágio. Dois reitores da Faculdade Peabody de Educação e Desenvolvimento Humano da Universidade de Vanderbilt foram suspensos depois que a escola emitiu um e-mail em resposta ao tiroteio de 13 de fevereiro na Universidade Estadual de Michigan, pedindo à comunidade de Vanderbilt que “se unisse” para “criar um ambiente seguro e inclusivo”. meio ambiente” no campus.

O e-mail continha um aviso em letras pequenas de que era uma “paráfrase” do ChatGPT. O atirador de Michigan matou três estudantes e feriu cinco.

Para ser justo, o e-mail ChatGPT de Vanderbilt não era tão diferente do que os humanos da equipe da universidade poderiam ter produzido, um exemplo de condolências de “pensamentos e orações” após uma tragédia pública, que parecem vazias e robóticas mesmo quando produzidas por criaturas de carne e sangue.

Os produtos Chatbot ainda precisam penetrar nos escalões de elite da escrita criativa ou da arte. Clarke diz que o que está motivando a submissão de histórias escritas por máquina para sua revista não parece ser aspirações de realizações criativas, mas a busca por dinheiro rápido.

“Muitos vêm de sites de ‘agitação’ na internet”, diz ele. “Eles são mal orientados por pessoas que apregoam esses esquemas de ganhar dinheiro.”

Outros temem que a facilidade de gerar prosa e imagens aparentemente autênticas, mas geradas por máquina, torne a tecnologia uma ferramenta para irregularidades, assim como as criptomoedas encontraram seus casos de uso mais confiáveis em fraudes e ataques de ransomware.

Isso porque esses programas não são entidades morais, mas instrumentos que respondem aos impulsos de seus usuários e dependem do material de origem para o qual são direcionados. A Microsoft teve que ajustar seu novo mecanismo de busca Bing, baseado no ChatGPT, por exemplo, quando respondeu de maneira estranha, enervante e até ofensiva às consultas de alguns usuários.

A produção do ChatGPT é teoricamente limitada por “guardas de proteção” éticas criadas por seus desenvolvedores, mas facilmente evitadas – “nada mais do que batom em um porco amoral”, observou Marcus.

“Agora temos o chatbot mais usado do mundo,… glorificado pela mídia e, ainda assim, com proteções éticas que meio que funcionam”, acrescenta. “Há pouca ou nenhuma regulamentação governamental em vigor para fazer muito sobre isso. As possibilidades agora são infinitas para propaganda, fazendas de trolls e redes de sites falsos que degradam a confiança na Internet. É um desastre em formação.”

.