.

“Bodies” é atualmente o segundo programa mais popular da Netflix, de acordo com o sistema de classificação pública do serviço de streaming.

Este thriller policial britânico é baseado em uma série de histórias em quadrinhos de Si Spencer. Assim como seu material original, o show consiste em oito partes, e todas foram lançadas em 19 de outubro.

Shira Haas, famosa por “Não Ortodoxo”, estrela “Bodies” junto com os atores ingleses Stephen Graham, Amaka Okafor e Jacob Fortune-Lloyd. O show gira em torno de detetives de Londres em diferentes períodos enquanto investigam o mesmo assassinato.

Continue lendo para ver mais programas populares do momento em serviços de streaming, incluindo Hulu, Amazon Prime Video, Max e Disney+. E se você quiser se manter informado sobre tudo sobre streaming, assine o boletim informativo Streamline.

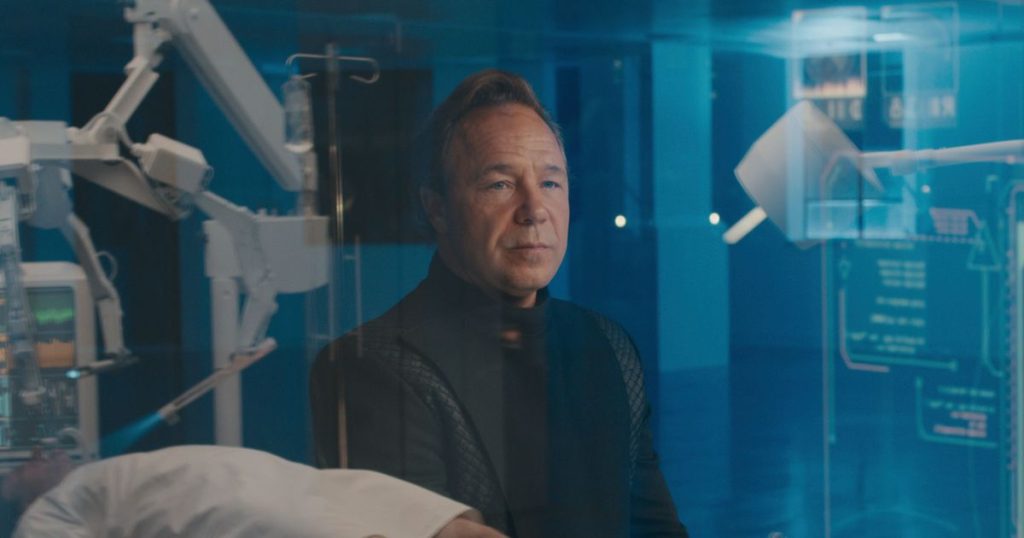

O showrunner de “The Office”, Greg Daniels, é o criador da série de comédia de ficção científica “Upload”, da Amazon, que retornou para sua terceira temporada em 20 de outubro.

Estrelado por Robbie Amell e Andy Allo, o show se passa em um mundo futuro no qual os humanos podem “carregar” sua consciência em uma vida virtual após a morte. A trama gira em torno de um jovem programador de computador que morre prematuramente e cria um vínculo com seu manipulador vivo na vida após a morte.

“Living for the Dead” é um novo reality show paranormal co-criado pela atriz Kristen Stewart. O programa estreou no Hulu em 18 de outubro e segue um grupo de cinco especialistas paranormais queer enquanto viajam para lugares assombrados nos EUA.

Todos os oito episódios foram lançados de uma vez, perfeitamente cronometrados para a “temporada assustadora”.

A série animada de ficção científica “Scavengers Reign” estreou na Max em 19 de outubro com o lançamento dos três primeiros dos 12 episódios.

Apresentando as vozes de Alia Shawkat e Wunmi Mosaku, o show conta a história da tripulação de uma espaçonave que fica presa em um planeta estranho e precisa aprender a sobreviver.

Mosaku também aparece em “Loki”, que retornou para a segunda temporada em 5 de outubro, com novos episódios sendo lançados todas as quintas-feiras.

A série Marvel Cinematic Universe é transmitida pela Disney + e segue o personagem titular dos quadrinhos, o deus da travessura (interpretado por Tom Hiddleston).

O Strong The One pode receber uma comissão por algumas compras feitas por meio de links nesta página. Cada item é selecionado de forma independente pela equipe do Strong The One Shopping. Preços e disponibilidade estão sujeitos a alterações.

.