.

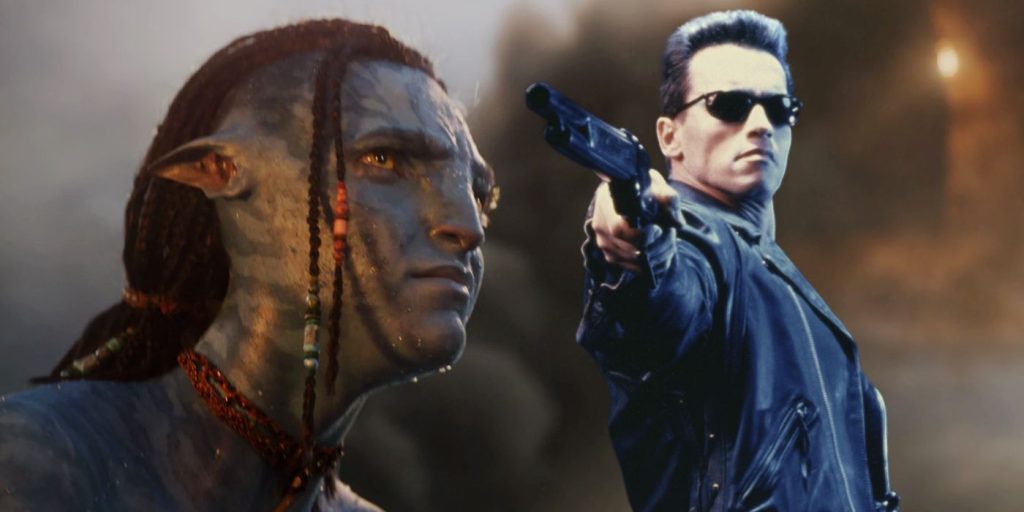

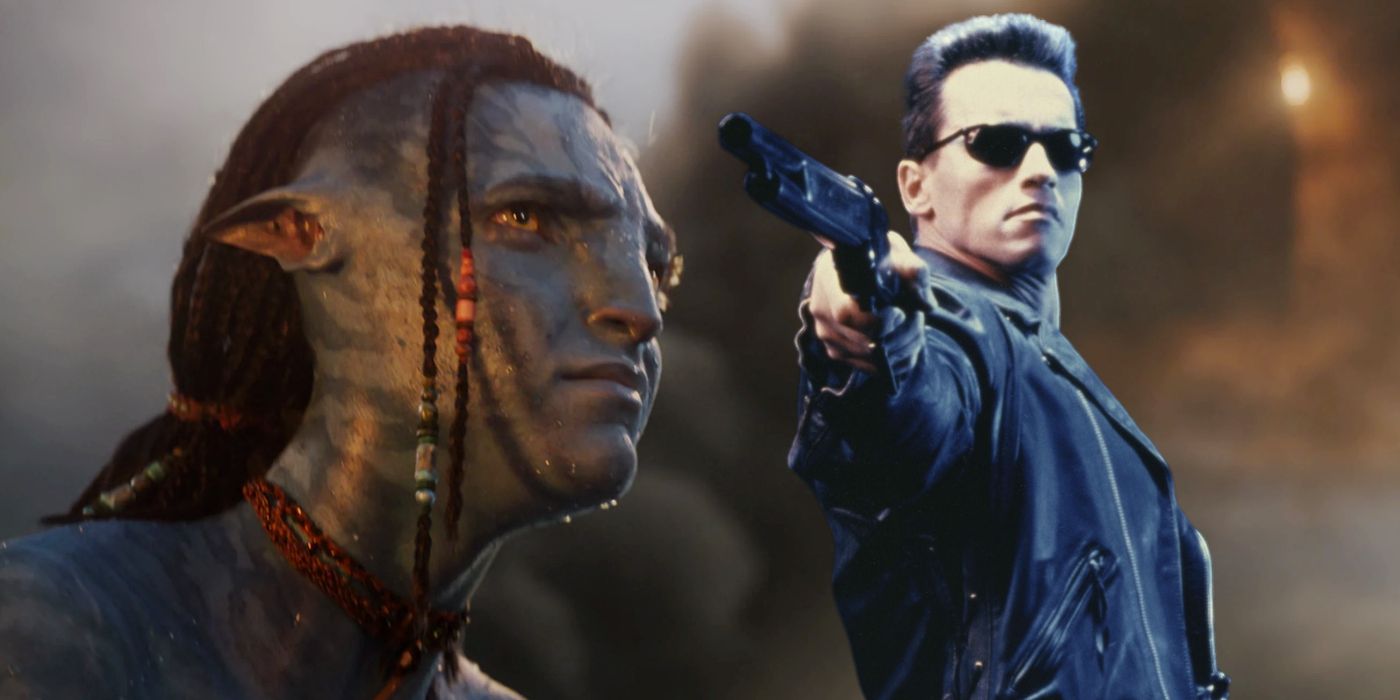

Um artista de efeitos visuais revela o ovo de Páscoa oculto de Avatar: The Way of Water de uma sequência anterior do diretor James Cameron, Terminator 2: Judgment Day.

Avatar: O Caminho da Água contém um sutil Exterminador do Futuro 2: Dia do Julgamento Ovo de Páscoa, revelado por um importante artista de efeitos visuais. O avatar A sequência, que vem mais de uma década após o original de 2009, estreou em 16 de dezembro e ainda está em exibição nos cinemas, tendo se tornado um dos 5 filmes de maior bilheteria de todos os tempos. Segue Jake (Sam Worthington) e Neytiri (Zoe Saldaña) em parceria com a tribo da água de Pandora para ajudar a proteger seus filhos – incluindo o rebelde Lo’ak (Britain Dalton), a sábia Kiri (Sigourney Weaver) e o refugiado humano Spider (Jack Champion). – de invasores terráqueos.

Em um episódio recente de Tripulação do CorredorVFX Artists React, o convidado foi o Supervisor de VFX da Weta FX, Eric Saindon, que trabalhou em Avatar: O Caminho da Água.

Durante a conversa sobre o design dos personagens, Saindon revelou que o cabelo caído no rosto de Lo’ak era para imitar Edward Furlong como o jovem John Connor em Exterminador do Futuro 2: Dia do Julgamentocapturando que “sentimento rebelde para ele.” Leia a citação completa abaixo:

Você consegue coisas que não esperaria, como Lo’ak, ele tem aquela trança que está sempre pendurada [over his right eye]. Jim sempre disse que essa é toda a razão em Exterminador do Futuro 2 que Eddie sempre teve aquele cabelo que caía sobre o rosto, ele queria a mesma sensação, a sensação rebelde para ele.

Sequências são a especialidade de James Cameron

Desde o início de sua carreira, Cameron lançou sequências que superaram os originais, seja em estima dos fãs ou nas bilheterias. Isso não ficou claro no início, no entanto, quando ele foi demitido de seu primeiro projeto de direção. O filme em questão é de 1981 Piranha II: A Desovauma sequência do recurso de criatura de Joe Dante de 1978 Piranhaque Cameron rejeitou de forma memorável nos anos desde seu lançamento.

O diretor cuidou de suas feridas brevemente, lançando o icônico filme de ficção científica O Exterminador do Futuro em 1984, que ele imediatamente seguiu com o filme de 1986 alienígenasacrescentando um toque de suspense de ação ao atmosférico 1979 de Ridley Scott Estrangeiro. Ele combinou o sucesso de sua sequência ao dirigir a sequência de 1991. Exterminador do Futuro 2: Dia do Julgamento, que expandiu o original com ação de alta octanagem e ficção científica ainda mais profunda. Cameron iria relegar seu envolvimento na última franquia para produzir e desenvolver a história para Exterminador do Futuro: Destino Sombrio.

Como Cameron não é um cineasta particularmente prolífico, Avatar: O Caminho da Água é a primeira sequência entre os quatro longas-metragens narrativos que ele criou desde 1991. No entanto, prova seu domínio da forma, trazendo sem esforço o público de volta ao mundo dos Na’vi e gerando enormes dividendos de bilheteria. Na verdade, o avatar sequência está atualmente em competição com o próprio Cameron Titânico para se tornar o terceiro filme de maior bilheteria de todos os tempos.

Fonte: Equipe do Corredor

Principais datas de lançamento

.