.

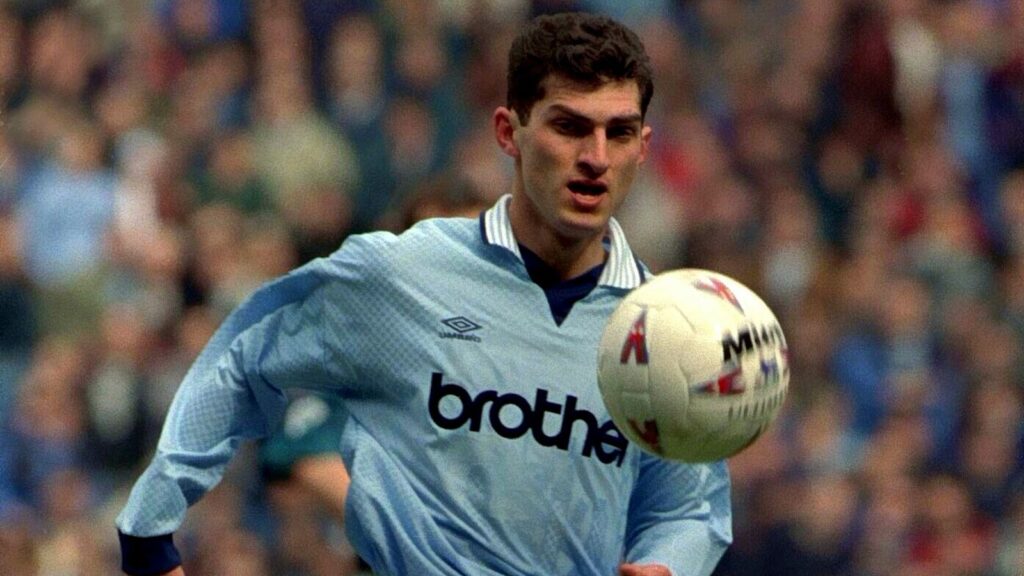

Um ex-jogador de futebol do Manchester City será o próximo presidente da Geórgia depois que o partido no poder o escolheu como candidato.

Mikheil Kavelashvili, 53, que também jogou pelo Geórgiada seleção nacional, é quase certo que será eleito para a posição amplamente cerimonial.

O novo presidente será escolhido pelo colégio eleitoral de 300 lugares, que é em grande parte controlado pelo partido governante Georgian Dream.

O seu sucesso nas eleições parlamentares do mês passado foi contestado pelos observadores eleitorais europeus, que descreveram casos de suborno, votação dupla e violência física.

A vitória provocou protestos e levou a oposição a boicotar o parlamento.

Os críticos acusaram o Georgian Dream de se tornar cada vez mais autoritário e inclinado para Moscou.

Kavelashvili disse aos repórteres que “a radicalização e a polarização” no país foram alimentadas pelo exterior.

Acusou o presidente cessante de violar a constituição e declarou que iria “restaurar a presidência ao seu quadro constitucional”.

O Georgian Dream aprovou recentemente leis semelhantes às utilizadas pelo Kremlin para reprimir a liberdade de expressão e os direitos LGBTQ+.

Em Junho, a UE suspendeu indefinidamente o processo de candidatura à adesão da Geórgia depois de o Parlamento ter aprovado uma lei que exige que as organizações que recebam mais de 20% do seu financiamento do estrangeiro se registem como “que perseguem os interesses de uma potência estrangeira”.

Isto é semelhante a uma lei russa utilizada para desacreditar grupos críticos do governo.

Na segunda-feira, a Presidente Salome Zourabichvili, que rejeitou os resultados oficiais das eleições, recusou-se a reconhecer a legitimidade do parlamento. Seu mandato de seis anos expira no próximo mês.

Ela foi eleita por voto popular, mas a Geórgia aprovou mudanças constitucionais que aboliram a eleição direta do presidente.

Em vez disso, o novo presidente será escolhido por votação num colégio eleitoral, composto por 300 membros do parlamento, conselhos municipais e legislaturas regionais.

O Georgian Dream tem maioria no colégio, o que torna a aprovação da candidatura de Kavelashvili praticamente certa.

Leia mais:

Geórgia: uma nação em crise

Greta Thunberg junta-se aos protestos na Geórgia

Kavelashvili foi atacante do Manchester City na temporada 1995-6 e jogou por vários clubes da Superliga Suíça. Ele foi eleito para o parlamento em 2016 pela chapa Georgian Dream.

Em 2022, foi cofundador do movimento político Poder Popular, que se tornou conhecido pela sua forte retórica antiocidental. Está alinhado com o partido Georgian Dream no parlamento.

.