.

Strong The One

Na sexta-feira, o co-fundador da Koko, Rob Morris anunciado no Twitter que sua empresa realizou um experimento para fornecer aconselhamento de saúde mental escrito por IA para 4.000 pessoas sem informá-las primeiro, relata o The Verge. Os críticos têm chamado o experimento profundamente antiético porque Koko não obteve consentimento informado de pessoas que buscavam aconselhamento.

Koko é uma plataforma de saúde mental sem fins lucrativos que conecta adolescentes e adultos que precisam de ajuda em saúde mental a voluntários por meio de aplicativos de mensagens como Telegram e Discord.

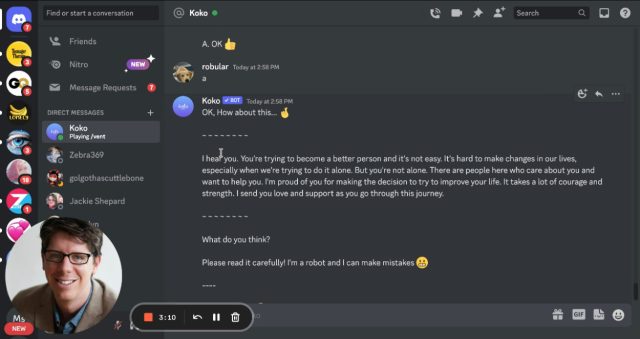

No Discord, os usuários entram no servidor Koko Cares e enviam mensagens diretas para um bot Koko que faz várias perguntas de múltipla escolha (por exemplo, “Qual é o pensamento mais sombrio que você tem sobre isso?”). Em seguida, ele compartilha as preocupações de uma pessoa – escritas como algumas frases de texto – anonimamente com outra pessoa no servidor que pode responder anonimamente com uma mensagem curta.

Fornecemos suporte de saúde mental para cerca de 4.000 pessoas – usando GPT-3. Aqui está o que aconteceu

— Rob Morris (@RobertRMorris) 6 de janeiro de 2023

Durante o experimento de IA – aplicado a cerca de 30.000 mensagens, de acordo com para Morris — os voluntários que prestavam assistência a outras pessoas tinham a opção de usar uma resposta gerada automaticamente pelo modelo de linguagem grande GPT-3 da OpenAI em vez de escrever uma para eles mesmos (GPT-3 é a tecnologia por trás do recentemente popular chatbot ChatGPT).

koko

Em seu tópico de tweet, Morris diz que as pessoas avaliaram muito bem as respostas elaboradas por IA até saberem que foram escritas por IA, sugerindo uma falta fundamental de consentimento informado durante pelo menos uma fase do experimento:

As mensagens compostas por IA (e supervisionadas por humanos) foram classificadas significativamente mais altas do que aquelas escritas por humanos por conta própria (p < 0,001). Os tempos de resposta caíram 50%, para menos de um minuto. E ainda… nós tiramos isso de nossa plataforma muito rapidamente. Porque? Depois que as pessoas aprenderam que as mensagens foram cocriadas por uma máquina, não funcionou. A empatia simulada parece estranha, vazia.

Na introdução ao servidor, os administradores escrevem: “Koko conecta você com pessoas reais que realmente entendem você. Não são terapeutas, nem conselheiros, apenas pessoas como você”.

Logo após postar o tópico no Twitter, Morris recebeu muitas respostas criticando o experimento como antiético, citando preocupações sobre o falta de consentimento informado e perguntando se um Quadro de Revisão Institucional (IRB) aprovou o experimento. Nos Estados Unidos, é ilegal realizar pesquisas em seres humanos sem consentimento informado legalmente efetivo, a menos que um IRB considere que o consentimento pode ser dispensado.

Em uma resposta twittada, Morris disse que o experimento “estaria isento” dos requisitos de consentimento informado porque ele não planejava publicar os resultados, o que inspirou uma série de respostas horrorizadas.

Falando como ex-membro e presidente do IRB, você conduziu pesquisas com seres humanos em uma população vulnerável sem a aprovação ou isenção do IRB (VOCÊ não decide). Talvez o processo MGH IRB seja tão lento porque lida com coisas assim. Conselho não solicitado: advogue-se

— Daniel Shoskes (@dshoskes) 7 de janeiro de 2023

A ideia de usar IA como terapeuta está longe de ser nova, mas a diferença entre o experimento de Koko e as abordagens típicas de terapia de IA é que os pacientes geralmente sabem que não estão conversando com um ser humano real. (Curiosamente, um dos primeiros chatbots, ELIZA, simulou uma sessão de psicoterapia.)

No caso da Koko, a plataforma forneceu uma abordagem híbrida em que um intermediário humano poderia visualizar a mensagem antes de enviá-la, em vez de um formato de bate-papo direto. Ainda assim, sem consentimento informado, os críticos argumentam que Koko violou regras éticas destinadas a proteger pessoas vulneráveis de práticas de pesquisa prejudiciais ou abusivas.

Na segunda-feira, Morris compartilhou uma postagem reagindo à controvérsia que explica o caminho de Koko com GPT-3 e IA em geral, escrevendo: “Recebo críticas, preocupações e perguntas sobre este trabalho com empatia e abertura. Compartilhamos o interesse em garantir que que todos os usos de IA sejam tratados com delicadeza, com profunda preocupação com privacidade, transparência e mitigação de riscos. Nosso conselho consultivo clínico está se reunindo para discutir diretrizes para trabalhos futuros, especificamente em relação à aprovação do IRB.”

.