.

Principais conclusões

- Avisos claros e específicos são cruciais para minimizar a alucinação da IA. Evite instruções vagas e forneça detalhes explícitos para evitar resultados imprevisíveis.

- Use a técnica de fundamentação ou “de acordo com…” para atribuir a saída a uma fonte ou perspectiva específica. Isso ajuda a evitar erros factuais e preconceitos no conteúdo gerado por IA.

- Use restrições e regras para moldar os resultados da IA de acordo com os resultados desejados. Declare explicitamente as restrições ou implique-as por meio do contexto ou da tarefa para evitar resultados inadequados ou ilógicos.

Não está obtendo a resposta desejada de um modelo generativo de IA? Você pode estar lidando com uma alucinação de IA, um problema que ocorre quando o modelo produz resultados imprecisos ou irrelevantes.

É causado por vários fatores, como a qualidade dos dados usados para treinar o modelo, a falta de contexto ou a ambiguidade do prompt. Felizmente, existem técnicas que você pode usar para obter resultados mais confiáveis de um modelo de IA.

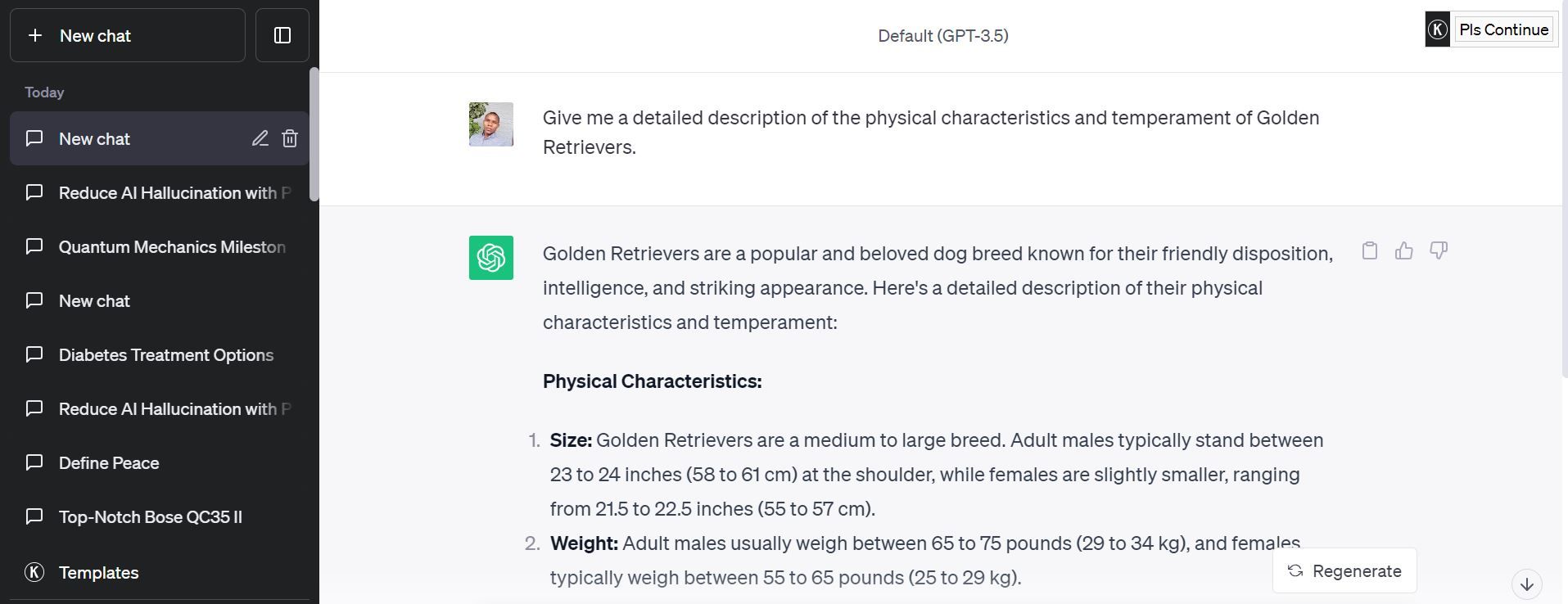

1. Forneça instruções claras e específicas

O primeiro passo para minimizar a alucinação da IA é criar avisos claros e altamente específicos. Solicitações vagas ou ambíguas podem levar a resultados imprevisíveis, pois os modelos de IA podem tentar interpretar a intenção por trás da solicitação. Em vez disso, seja explícito em suas instruções.

Em vez de perguntar “Conte-me sobre cães”, você pode perguntar: “Dê-me uma descrição detalhada das características físicas e do temperamento dos Golden Retrievers”. Refinar seu prompt até que fique claro é uma maneira fácil de evitar alucinações de IA.

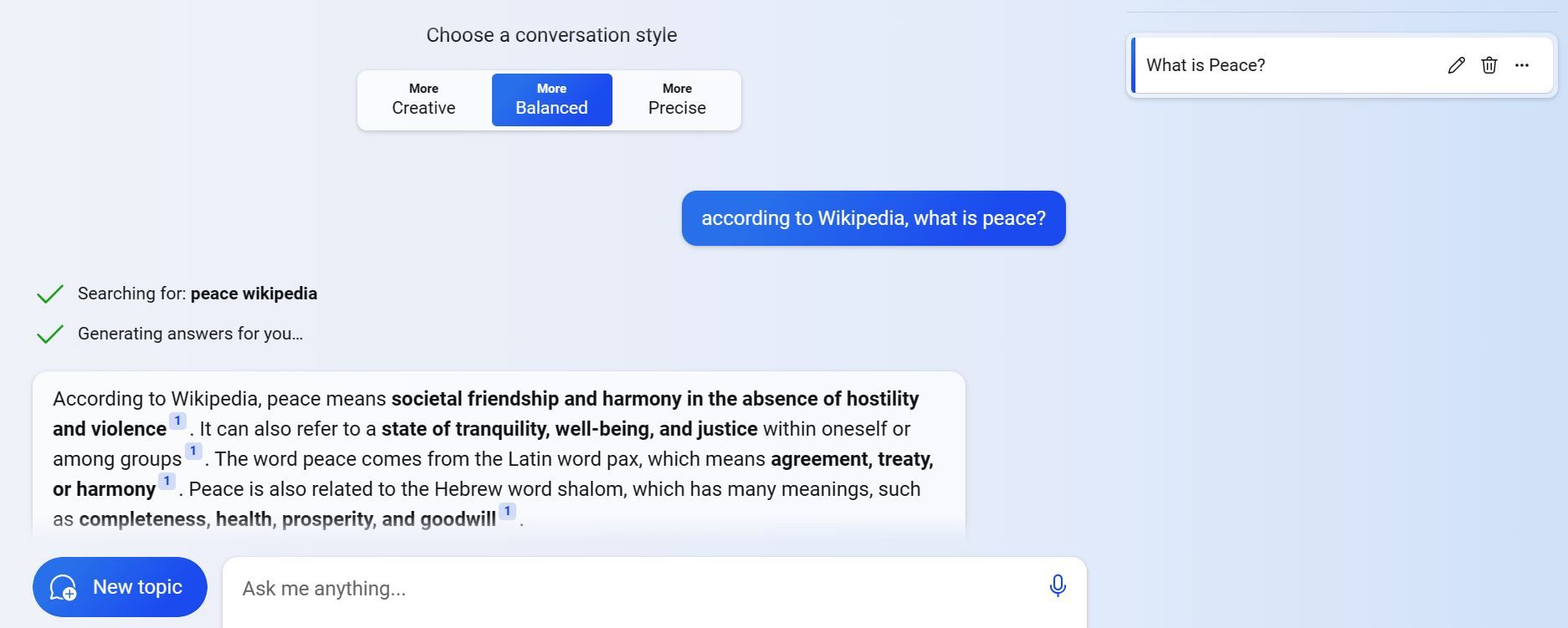

2. Use o aterramento ou a técnica “De acordo com…”

Um dos desafios do uso de sistemas de IA é que eles podem gerar resultados factualmente incorretos, tendenciosos ou inconsistentes com suas opiniões ou valores. Isto pode acontecer porque os sistemas de IA são treinados em conjuntos de dados grandes e diversos que podem conter erros, opiniões ou contradições.

Para evitar isso, você pode usar o aterramento ou a técnica “de acordo com…”, que envolve atribuir a saída a uma fonte ou perspectiva específica. Por exemplo, você pode pedir ao sistema de IA para escrever um fato sobre um tópico de acordo com a Wikipedia, o Google Scholar ou uma fonte específica acessível ao público.

3. Use restrições e regras

As restrições e regras podem ajudar a evitar que o sistema de IA gere resultados inadequados, inconsistentes, contraditórios ou ilógicos. Eles também podem ajudar a moldar e refinar o resultado de acordo com o resultado e propósito desejados. Restrições e regras podem ser explicitamente declaradas no prompt ou implicitamente implícitas no contexto ou na tarefa.

Suponha que você queira usar uma ferramenta de IA para escrever um poema sobre o amor. Em vez de fornecer uma solicitação geral como “escreva um poema sobre o amor”, você pode fornecer uma solicitação mais restrita e baseada em regras, como “escreva um soneto sobre o amor com 14 versos e 10 sílabas por linha”.

4. Use solicitação de várias etapas

Às vezes, perguntas complexas podem levar a alucinações de IA porque o modelo tenta respondê-las em uma única etapa. Para superar isso, divida suas consultas em várias etapas.

Por exemplo, em vez de perguntar: “Qual é o tratamento mais eficaz para o diabetes?” você pode perguntar: “Quais são os tratamentos comuns para diabetes?” Você pode então perguntar: “Qual desses tratamentos é considerado o mais eficaz de acordo com estudos médicos?”

A solicitação em várias etapas força o modelo de IA a fornecer informações intermediárias antes de chegar a uma resposta final, o que pode levar a respostas mais precisas e bem informadas.

5. Atribuir função à IA

Ao atribuir uma função específica ao modelo de IA em seu prompt, você esclarece seu propósito e reduz a probabilidade de alucinação. Por exemplo, em vez de dizer “Conte-me sobre a história da mecânica quântica”, você pode solicitar à IA: “Assuma o papel de um pesquisador diligente e forneça um resumo dos principais marcos na história da mecânica quântica”.

Este enquadramento incentiva a IA a agir como um investigador diligente, em vez de um contador de histórias especulativo.

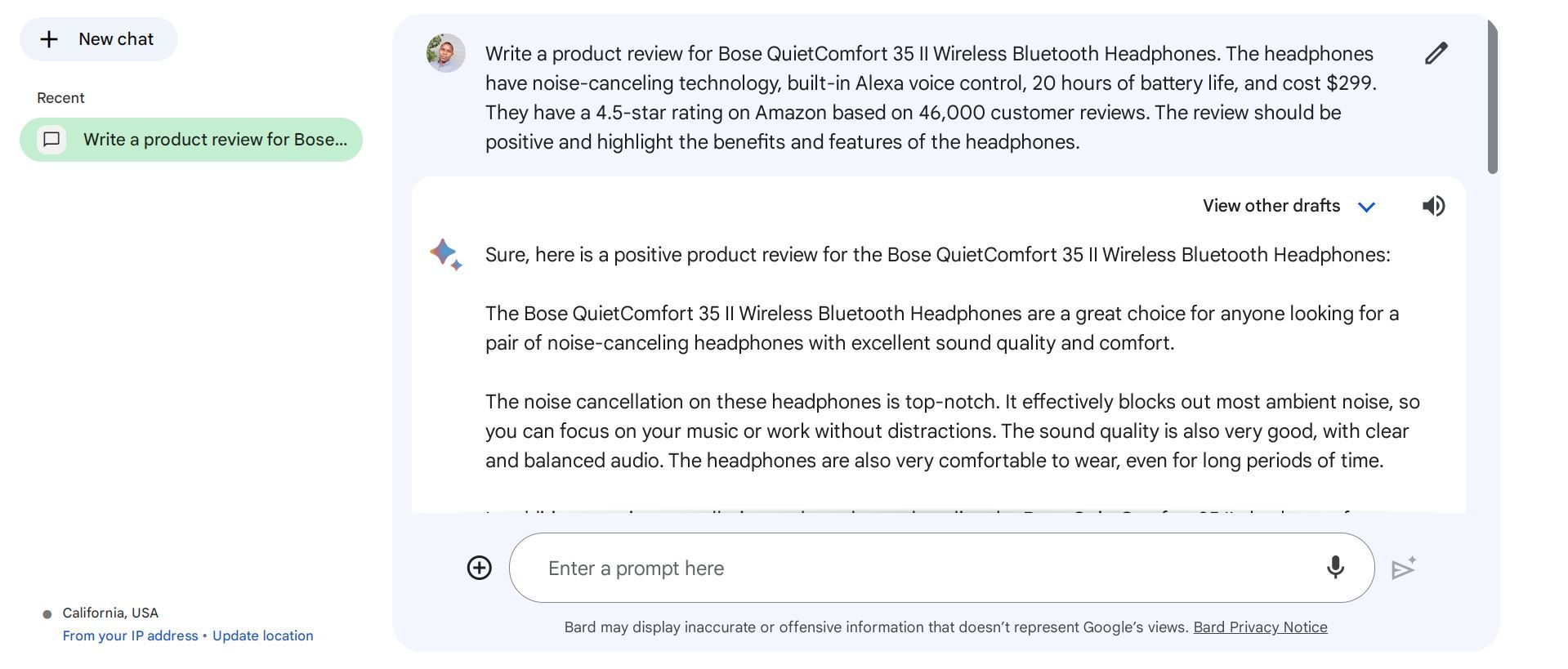

6. Adicione informações contextuais

Não fornecer informações contextuais quando necessário é um erro imediato a ser evitado ao usar ChatGPT ou outros modelos de IA. As informações contextuais ajudam o modelo a compreender o histórico, o domínio ou o propósito da tarefa e a gerar resultados mais relevantes e coerentes. As informações contextuais incluem palavras-chave, tags, categorias, exemplos, referências e fontes.

Por exemplo, se quiser gerar uma avaliação de produto para um par de fones de ouvido, você pode fornecer informações contextuais, como nome do produto, marca, recursos, preço, classificação ou feedback do cliente. Um bom prompt para esta tarefa poderia ser algo assim:

Obtendo melhores respostas de IA

Pode ser frustrante quando você não recebe o feedback esperado de um modelo de IA. No entanto, usando essas técnicas de alerta de IA, você pode reduzir a probabilidade de alucinações de IA e obter respostas melhores e mais confiáveis de seus sistemas de IA.

Lembre-se de que essas técnicas não são infalíveis e podem não funcionar para todas as tarefas ou tópicos. Você deve sempre verificar e verificar as saídas de IA antes de usá-las para qualquer finalidade séria.

.