.

Com o burburinho atual em torno da inteligência artificial (IA), seria fácil presumir que ela é uma inovação recente. Na verdade, a IA existe de uma forma ou de outra há mais de 70 anos. Para entender a geração atual de ferramentas de IA e aonde elas podem levar, é útil entender como chegamos aqui.

Cada geração de ferramentas de IA pode ser vista como uma melhoria em relação às anteriores, mas nenhuma delas está caminhando em direção à consciência.

O matemático e pioneiro da computação Alan Turing publicou um artigo em 1950 com a frase inicial: “Proponho considerar a questão: ‘As máquinas podem pensar?’”. Ele prossegue propondo algo chamado jogo de imitação, agora comumente chamado de teste de Turing, no qual uma máquina é considerada inteligente se não puder ser distinguida de um ser humano numa conversa cega.

Cinco anos depois, veio o primeiro uso publicado da frase “inteligência artificial” em uma proposta para o Projeto de Pesquisa de Verão de Dartmouth sobre Inteligência Artificial.

A partir desses primórdios, um ramo da IA que se tornou conhecido como sistemas especialistas foi desenvolvido a partir da década de 1960. Esses sistemas foram projetados para capturar a expertise humana em domínios especializados. Eles usavam representações explícitas de conhecimento e são, portanto, um exemplo do que é chamado de IA simbólica.

Houve muitos sucessos iniciais bem divulgados, incluindo sistemas para identificação de moléculas orgânicas, diagnóstico de infecções sanguíneas e prospecção de minerais. Um dos exemplos mais atraentes foi um sistema chamado R1 que, em 1982, supostamente economizava à Digital Equipment Corporation US$ 25 milhões por ano ao projetar configurações eficientes de seus sistemas de minicomputadores.

O principal benefício dos sistemas especialistas era que um especialista no assunto sem nenhuma experiência em codificação poderia, em princípio, construir e manter a base de conhecimento do computador. Um componente de software conhecido como mecanismo de inferência então aplicava esse conhecimento para resolver novos problemas dentro do domínio do assunto, com uma trilha de evidências fornecendo uma forma de explicação.

Eles estavam na moda na década de 1980, com organizações clamando para construir seus próprios sistemas especialistas, e continuam sendo uma parte útil da IA hoje.

Entre no aprendizado de máquina

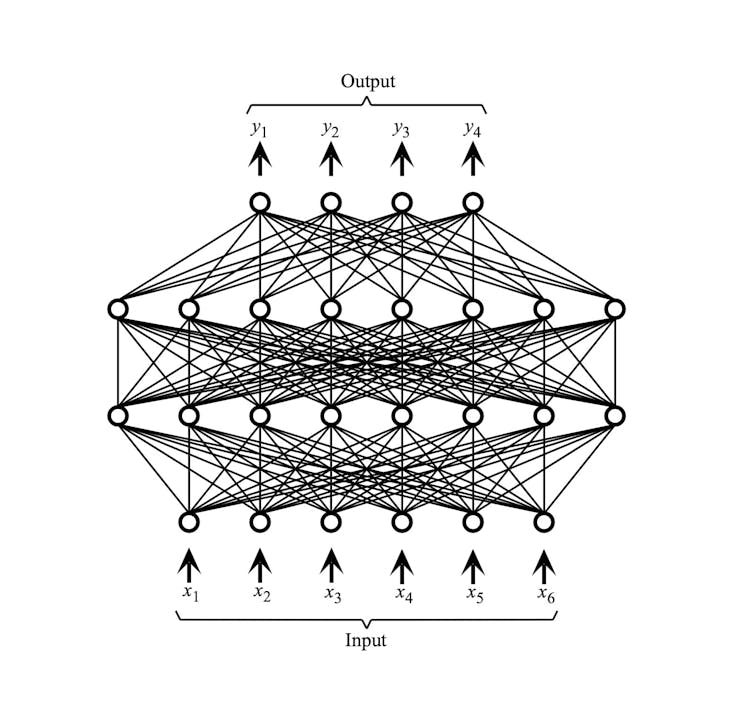

O cérebro humano contém cerca de 100 mil milhões de células nervosas, ou neurónios, interligadas por uma estrutura dendrítica (ramificada). Assim, embora os sistemas especialistas visassem modelar o conhecimento humano, também estava a surgir um campo separado conhecido como conexionismo, que visava modelar o cérebro humano de uma forma mais literal. Em 1943, dois pesquisadores chamados Warren McCulloch e Walter Pitts produziram um modelo matemático para neurônios, segundo o qual cada um produziria uma saída binária dependendo de suas entradas.

Leia mais: A IA em breve se tornará impossível de ser compreendida pelos humanos – a história das redes neurais nos conta o porquê

Uma das primeiras implementações computacionais de neurônios conectados foi desenvolvida por Bernard Widrow e Ted Hoff em 1960. Esses desenvolvimentos eram interessantes, mas tinham uso prático limitado até o desenvolvimento de um algoritmo de aprendizado para um modelo de software chamado perceptron multicamadas (MLP) em 1986.

Adrian Hopgood, Autor fornecido (sem reutilização)

O MLP é um arranjo de tipicamente três ou quatro camadas de neurônios simulados simples, onde cada camada é totalmente interconectada com a próxima. O algoritmo de aprendizado para o MLP foi um avanço. Ele habilitou a primeira ferramenta prática que poderia aprender com um conjunto de exemplos (os dados de treinamento) e então generalizar para que pudesse classificar dados de entrada não vistos anteriormente (os dados de teste).

Ele conseguiu esse feito anexando pesos numéricos às conexões entre os neurônios e ajustando-os para obter a melhor classificação com os dados de treinamento, antes de ser implantado para classificar exemplos inéditos.

O MLP poderia lidar com uma ampla gama de aplicações práticas, desde que os dados fossem apresentados em um formato que pudesse ser utilizado. Um exemplo clássico foi o reconhecimento de caracteres manuscritos, mas apenas se as imagens fossem pré-processadas para identificar as principais características.

Modelos de IA mais recentes

Após o sucesso do MLP, inúmeras formas alternativas de redes neurais começaram a surgir. Uma importante foi a rede neural convolucional (CNN) em 1998, que era semelhante a um MLP, exceto por suas camadas adicionais de neurônios para identificar as principais características de uma imagem, eliminando assim a necessidade de pré-processamento.

Tanto o MLP como a CNN eram modelos discriminativos, o que significa que podiam tomar uma decisão, normalmente classificando os seus inputs para produzir uma interpretação, diagnóstico, previsão ou recomendação. Enquanto isso, outros modelos de redes neurais que eram generativos estavam sendo desenvolvidos, o que significa que eles poderiam criar algo novo, depois de serem treinados em um grande número de exemplos anteriores.

Redes neurais generativas podem produzir texto, imagens ou música, bem como gerar novas sequências para auxiliar em descobertas científicas.

Dois modelos de rede neural generativa se destacaram: redes generativas-adversariais (GANs) e redes transformadoras. As GANs alcançam bons resultados porque são parcialmente “adversariais”, o que pode ser pensado como um crítico embutido que exige qualidade melhorada do componente “generativo”.

Redes de transformadores ganharam destaque por meio de modelos como GPT4 (Generative Pre-trained Transformer 4) e sua versão baseada em texto, ChatGPT. Esses modelos de linguagem grande (LLMs) foram treinados em enormes conjuntos de dados, extraídos da Internet. O feedback humano melhora ainda mais seu desempenho por meio do chamado aprendizado por reforço.

Além de produzir uma capacidade generativa impressionante, o vasto conjunto de treinamento fez com que essas redes não estivessem mais limitadas a domínios estreitos e especializados como suas predecessoras, mas agora fossem generalizadas para cobrir qualquer tópico.

Para onde a IA está indo?

As capacidades dos LLMs levaram a previsões terríveis de que a IA dominaria o mundo. Tal alarmismo é injustificado, na minha opinião. Embora os modelos atuais sejam evidentemente mais poderosos do que seus predecessores, a trajetória permanece firmemente em direção a maior capacidade, confiabilidade e precisão, em vez de em direção a qualquer forma de consciência.

Como observou o professor Michael Wooldridge no seu depoimento perante a Câmara dos Lordes do Parlamento do Reino Unido em 2017, “o sonho de Hollywood de máquinas conscientes não é iminente e, na verdade, não vejo nenhum caminho que nos leve até lá”. Sete anos depois, a sua avaliação ainda é verdadeira.

Há muitas aplicações potenciais positivas e empolgantes para a IA, mas uma olhada na história mostra que o aprendizado de máquina não é a única ferramenta. A IA simbólica ainda tem um papel, pois permite que fatos conhecidos, entendimento e perspectivas humanas sejam incorporados.

Um carro sem motorista, por exemplo, pode ser provido com as regras da estrada em vez de aprendê-las por meio de exemplos. Um sistema de diagnóstico médico pode ser verificado em relação ao conhecimento médico para fornecer verificação e explicação das saídas de um sistema de aprendizado de máquina.

O conhecimento social pode ser aplicado para filtrar resultados ofensivos ou tendenciosos. O futuro é brilhante e envolverá o uso de uma gama de técnicas de IA, incluindo algumas que já existem há muitos anos.

.