.

Resumo

- A morte de Crimson Countess no programa de TV The Boys é brutal, mas a versão original em quadrinhos é ainda mais horrível e cheia de ódio.

- No programa de TV, Soldier Boy mata Crimson Countess com uma descarga destrutiva de energia, deixando apenas um esqueleto carbonizado para trás.

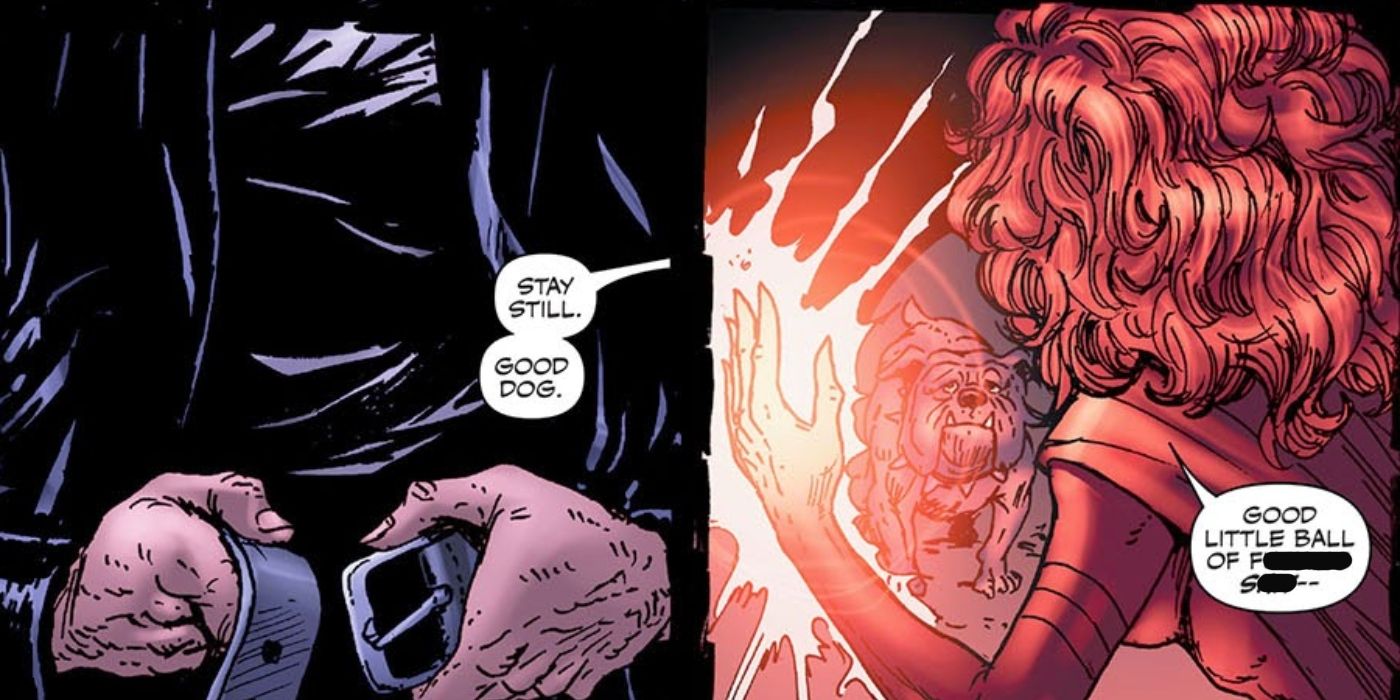

- A versão em quadrinhos mostra Butcher estrangulando Crimson Countess com seu cinto e deixando seu corpo mutilado como uma mensagem para os outros super-heróis. Ele mostra o tom mesquinho e anti-herói de toda a série.

A morte da Condessa Carmesim em os meninos O programa de TV de ação ao vivo é terrível, com certeza, mas não é nada comparado à brutalidade e ódio não adulterados que envolveram seu assassinato nos quadrinhos, já que a versão original da morte deste super é decididamente mais classificada como R.

Em os meninos temporada 3, episódio 5, Soldier Boy está em uma missão para rastrear os outros membros de sua tripulação original, já que foram eles que o ajudaram a ser capturado e posteriormente experimentado muitos anos antes. Neste episódio, Soldier Boy está de olho em Crimson Countess. Quando ele a encontra, Soldier Boy libera uma poderosa descarga de energia destrutiva, matando Crimson Countess quase instantaneamente, deixando nada para trás dela, exceto um esqueleto carbonizado.

O assassinato dos meninos da condessa carmesim é muito mais brutal nos quadrinhos

Em os meninos # 32 de Garth Ennis, Darick Robertson e Carols Ezquerra, os meninos estão no hospital com a fêmea depois que ela sofreu ferimentos graves de membros da equipe de super-heróis, Payback. Então, de repente, uma das paredes do hospital explode, apenas para revelar Payback com força total vindo pela abertura. Vingança significava acabar com os meninos ali mesmo, embora eles subestimassem enormemente a força e a desenvoltura dos meninos. Enquanto cada membro dos meninos tinha seu respectivo super-desafiador para lidar, o cachorro de Butcher e outro membro dos meninos, Terror, agarra o braço da Condessa Carmesim, rasgando e rasgando sua carne. Ela consegue jogar o cachorro de cima dela, apenas para perseguir Terror até o porão do hospital, separado do resto do Payback. É nesse momento que Butcher decide atacar, enquanto a segue até o porão e lança um ataque surpresa contra ela. Butcher estrangulou Crimson Countess com seu cinto e deixou seu corpo mutilado no chão para os outros membros sobreviventes de Payback encontrarem.

Embora a morte da Crimson Countess no show tenha sido mais explosiva, a representação em quadrinhos é sombria de uma forma com a qual o show não pode competir. A série de televisão mostrou Crimson Countess morrendo de uma forma que lembra outras mortes épicas na mídia de super-heróis. A razão disso é que os meninos O programa de TV zomba dos super-heróis em uma cultura onde eles são amados, então o espetáculo da morte da Condessa Carmesim foi apropriado para permanecer fiel à paródia mais ampla de toda a série. os meninos a série de quadrinhos, no entanto, na verdade odeia super-heróis e zomba deles de uma maneira que sugere que a cultura de super-heróis nunca existiu em primeiro lugar e que merece um final corajoso e nada espetacular – assim como a Condessa Carmesim.

Por causa da mesquinhez e do ódio por trás desse terrível assassinato (que combina com o tom em relação aos super-heróis exibido por toda a série de quadrinhos), é justo dizer que os meninos‘ A morte da Condessa Carmesim é ainda mais classificada como R nos quadrinhos originais do que no programa de TV.

.