.

GTC Superficialmente, a Conferência de Tecnologia de GPU da primavera da Nvidia foi mais uma vez aberta com uma palestra dominada por tecnologias generativas de IA.

Isso não deveria ser uma surpresa. Apesar do progresso feito por empresas como AMD, Intel e outras, a Nvidia continua sendo a maior fornecedora de GPUs e aceleradores usados para cargas de trabalho de aprendizado de máquina.

Mas por trás de toda a pompa concedida aos mais recentes modelos de IA da Nvidia, estruturas de aceleração e hardware – dos quais há muito o que falar – espreitava a questão da sustentabilidade. Esse é o pequeno problema de como exatamente alimentamos e resfriamos todas essas máquinas que conduzem o treinamento e a inferência de aprendizado de máquina de hoje.

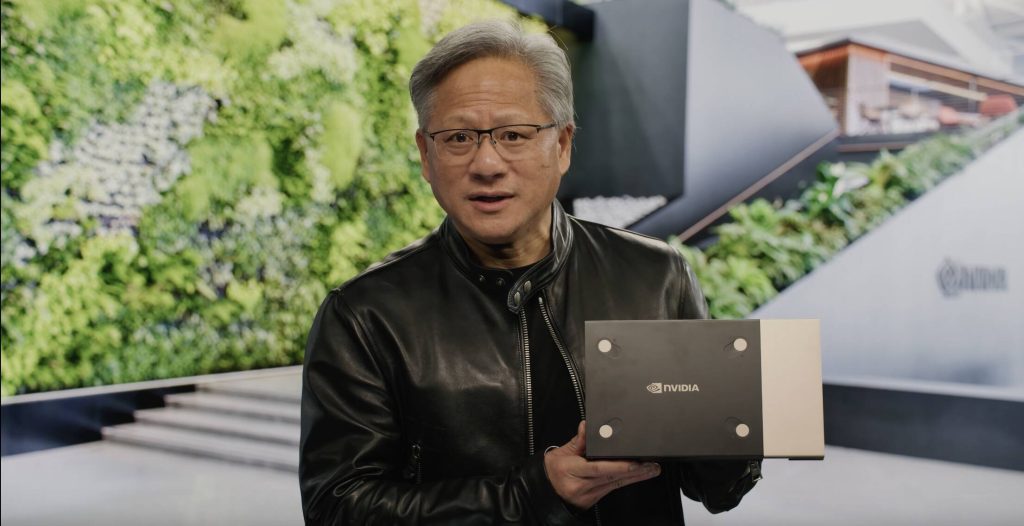

É um ponto que surgiu repetidamente durante a palestra do CEO Jensen Huang no GTC – veja abaixo – em que ele insistiu em como é ineficiente e caro executar essas cargas de trabalho em servidores de uso geral.

Há mérito em seu argumento. Embora nem todas as cargas de trabalho sejam facilmente paralelizadas, elas tendem a ser consideravelmente mais eficientes. Há uma razão pela qual os supercomputadores acelerados por GPU dominam o Verde500.

“A computação em nuvem cresceu 20 por cento anualmente em uma enorme indústria de US$ 1 trilhão. Cerca de 30 milhões de servidores de CPU fazem a maior parte do processamento”, disse Huang. “Com o fim da ‘Lei de Moore’, o aumento do desempenho da CPU vem com maior potência, e o mandato para diminuir as emissões de carbono está fundamentalmente em desacordo com a necessidade de aumentar os datacenters.”

A aceleração, ele argumenta, é a única maneira de reduzir o consumo de energia. Mas não é que a Nvidia queira apenas vender mais GPUs para você em um momento em que a demanda está baixa em vários segmentos, a empresa tem todo um portfólio de aceleradores e software para usar com eles que também deseja vender para você. A Nvidia tem GPUs dedicadas ao treinamento de IA, outras projetadas para inferência, visualização e processamento de vídeo, além de rede e kit de processamento de dados para uni-los.

“Os datacenters devem acelerar cada carga de trabalho para recuperar energia e liberar GPUs para cargas de trabalho geradoras de receita e o Bluefield da Nvidia descarrega e acelera o sistema operacional do datacenter e o software de infraestrutura”, disse Huang em uma apresentação para os DPUs Bluefield-3 da empresa.

E para cargas de trabalho que não podem ser aceleradas usando GPUs ou DPUs, a Nvidia tem sua CPU Grace baseada em Arm. “Todo o Grace Superchip de 144 núcleos tem tão baixo consumo de energia que pode ser resfriado a ar”, disse Huang, segurando o dissipador de calor de 1U de 5×8 polegadas do chip.

Só para constar, o Grace Superchip, que inclui 1 TB de memória LPDDR, ainda tem uma potência nominal de design térmico (TDP) de 500 W, portanto não é exatamente a parte de menor potência disponível. Para comparação, o Epyc 4 de 96 núcleos/192 threads da AMD tem um TDP configurável de 360W-400W. O desempenho em cargas de trabalho diferentes, não TDP, determinará, portanto, uma disputa de eficiência entre os dois em maior medida do que o TDP sozinho.

Depois de construir o hardware, fica claro que o próximo passo da Nvidia é ir atrás e construir bibliotecas de software para acelerar as cargas de trabalho em todos os setores que dependem de CPUs hoje – na verdade, criando novos mercados para seu hardware. As novas bibliotecas de litografia computacional da empresa são evidência disso, com Huang afirmando que a TSMC poderia substituir seus 40.000 nós de CPU por apenas 500 servidores DGX H100, reduzindo o consumo de energia de 35 MW para 5 MW no processo.

O campo está mais lotado do que nunca

Se tudo isso soa familiar, é porque a CEO da AMD, Lisa SU, acertou em muitos dos mesmos pontos enquanto falava na Conferência Internacional de Circuitos de Estado Sólido no final de fevereiro.

Durante sua palestra, Su alertou que, a menos que medidas drásticas sejam tomadas na década para melhorar a eficiência das arquiteturas de computação, os supercomputadores mais poderosos do mundo não apenas simulariam reações nucleares, mas também teriam que executá-las.

A resposta da AMD a isso envolve uma variedade de arquiteturas de computação e princípios de design, incluindo vários, como chiplets, dos quais foi pioneira. Usando essas tecnologias, a AMD está trabalhando para incorporar aceleradores de todos os tipos em suas plataformas. Por exemplo, a próxima APU MI300 da empresa combina núcleos de CPU Zen 4 com suas GPUs CDNA3 e uma carga de memória de alta largura de banda.

O contendor x86 também está trabalhando para construir FPGAs, aceleradores de IA e DPUs, adquiridos da Xilinx e da Pensando, em seus chips para acelerar mais cargas de trabalho e melhorar a eficiência da computação.

E para não ficar de fora, uma parcela crescente da Intel Xeon de 4ª Geração matrizes já são consumidas por aceleradores dedicados para aprendizado de máquina, criptografia, compactação, streaming de dados, análise e segurança.

A Intel também está trabalhando em uma APU própria – embora prefira o termo XPU – chamada Falcon Shores, embora essa plataforma tenha sido atrasado até pelo menos 2025, no que se tornou uma tendência para o fabricante de chips em dificuldades.

A Nvidia está, portanto, longe de ser a única fabricante de chips que defende o uso de aceleradores. ®

.