.

A engenharia imediata requer mais trabalho do que as pessoas imaginam. Mesmo profissionais de IA experientes passam semanas aperfeiçoando prompts longos, especialmente se envolverem várias etapas para concluir uma tarefa. Infelizmente, você não dominará a escrita de prompts eficazes da noite para o dia.

Embora desafiador, um grupo de apoio ajuda a reduzir a curva de aprendizado. Com esses grupos, você pode se envolver com pessoas que pensam como você. Aqui estão as melhores comunidades online onde você pode estudar, analisar, copiar, comprar e vender prompts de IA.

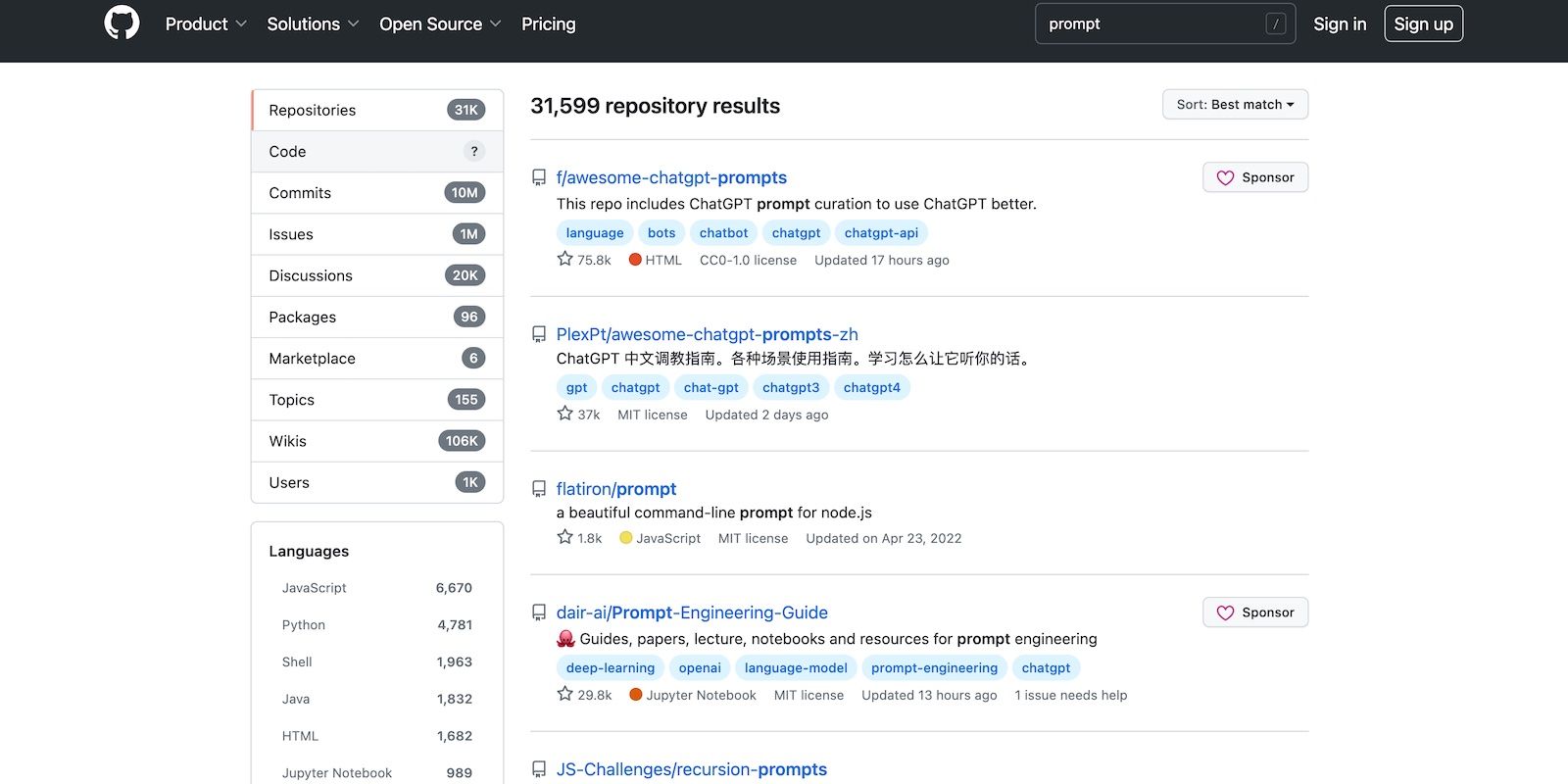

O GitHub está entre as plataformas de hospedagem de código mais usadas. Ele permite que os programadores gerenciem projetos de código aberto, colaborem em tarefas e compartilhem recursos de código como prompts de IA. Basta vasculhar os repositórios. Milhares de usuários do GitHub compartilham prompts para ChatGPT, Midjourney e Bard, entre outros modelos de IA.

Você pode usar o GitHub gratuitamente. O plano básico oferece acesso ilimitado a repositórios públicos e privados, além de 2.000 minutos de CD e CI por mês. Mas você tem que pagar por espaços de código e armazenamento de arquivos maiores.

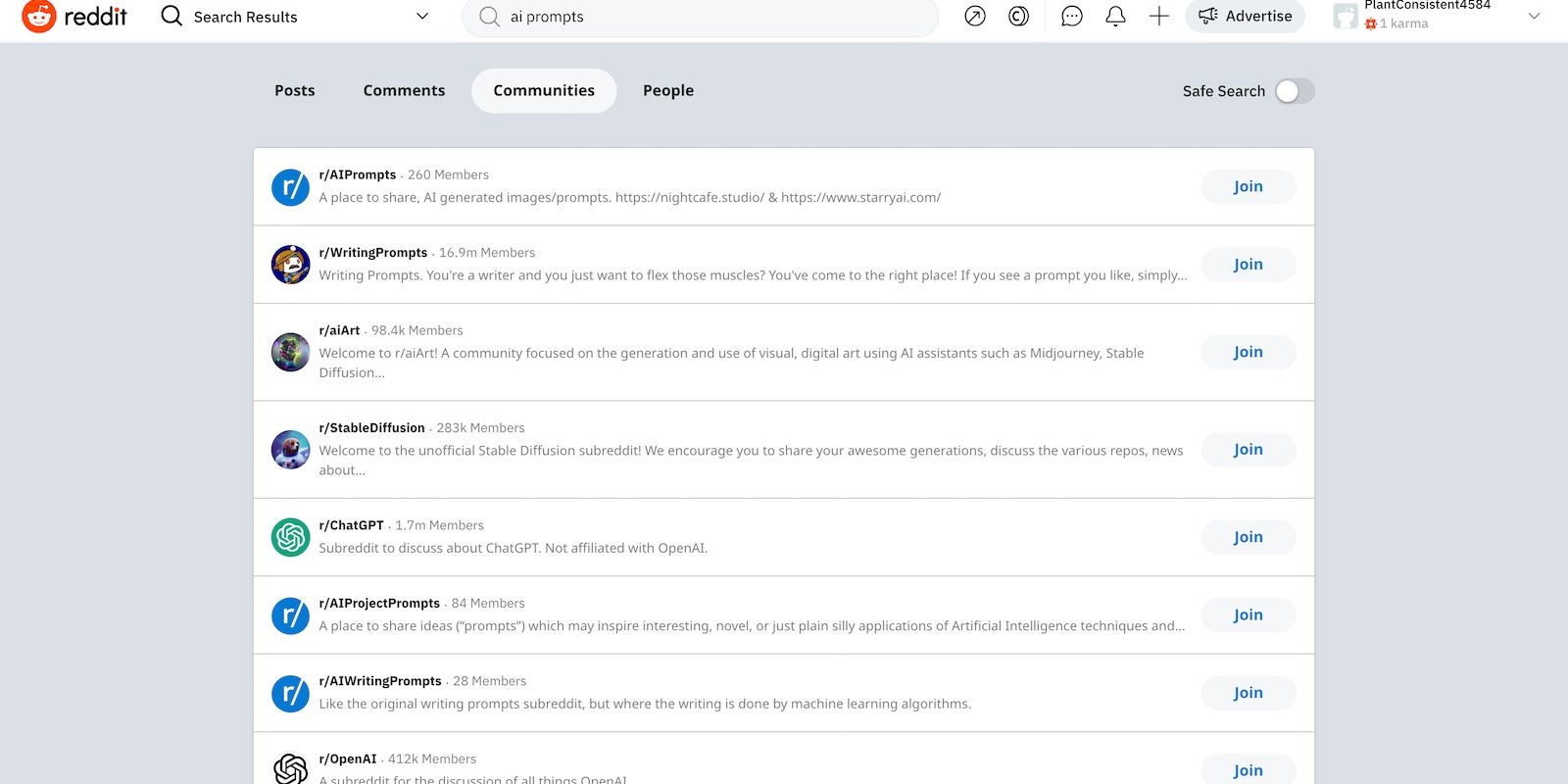

As comunidades focadas em IA no Reddit compreendem tópicos técnicos de nicho. Eles mergulham em subcategorias específicas de IA, como modelos de linguagem, aprendizado de máquina e treinamento de conjunto de dados. Alternativamente, grupos em outras redes sociais tradicionais cobrem assuntos de nível superficial.

Existem dezenas de Subreddits de IA. Mas se você quiser pesquisar prompts de IA, comece com estes grupos:

- r/StableDiffusion: Os usuários do Stable Diffusion compartilham seu fluxo de trabalho, prompts e resultados neste subreddit. Eles também comparam peças de outros modelos de texto para imagem.

- r/OpenAI: É o maior subreddit dedicado ao OpenAI. Veja como os usuários integram suas ferramentas e modelos de linguagem em seus respectivos aplicativos.

- r/PromptDesign: Estude a engenharia de prompt em todas as plataformas. Aqui, os usuários podem compartilhar prompts para vários modelos de idioma e texto para imagem.

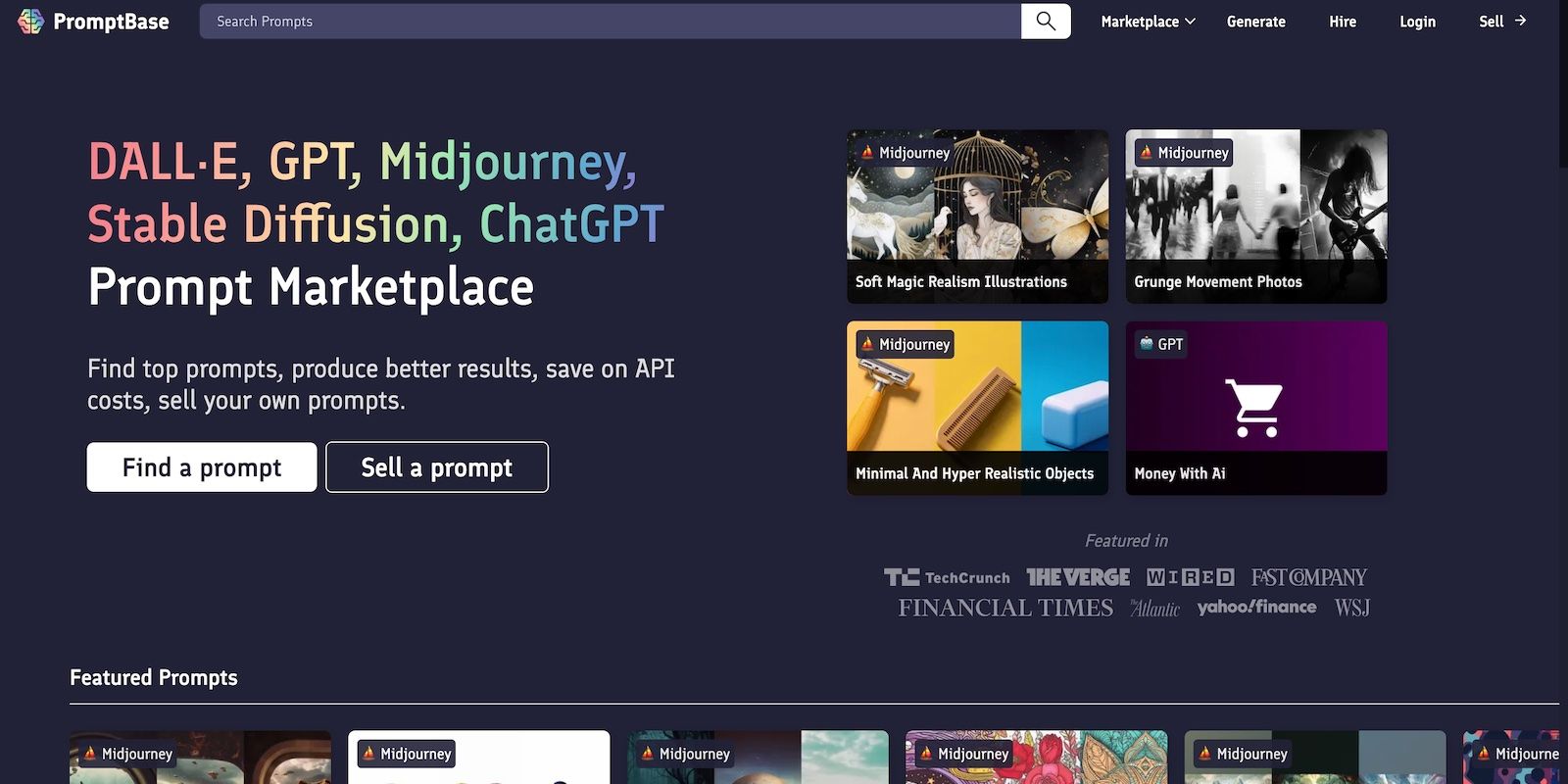

PromptBase é atualmente o maior marketplace de prompts. Se você deseja fazer o jailbreak do ChatGPT ou gerar arte 3D AI, você encontrará os prompts apropriados. Basta navegar pelas diferentes listagens para:

- GPT

- DALL-E

- meio da jornada

- Difusão estável

Você pode ingressar no PromptBase gratuitamente. Depois de criar uma conta, você pode começar instantaneamente a comprar e vender prompts de IA. Para referência, a maioria dos pacotes custa menos de $ 5. No entanto, certifique-se de verificar novamente as compras, porque os vendedores raramente aceitam reembolsos.

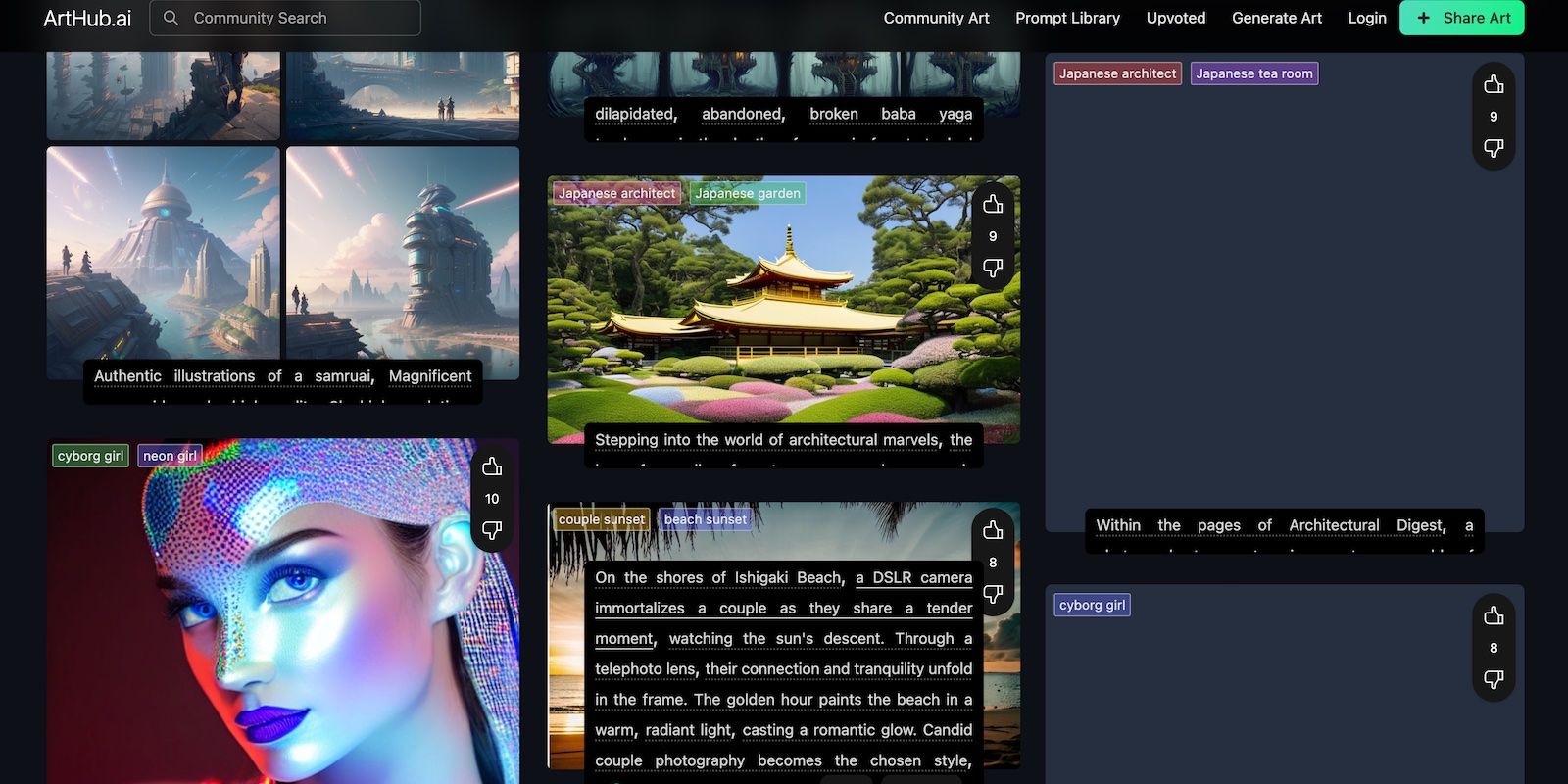

Como o nome do site sugere, o ArtHub se concentra na arte da IA. Ele possui uma enorme biblioteca de prompts de texto para imagem, que você pode filtrar por categoria. Escolha qualquer seção que desperte seu interesse. Todos os prompts vêm com seus respectivos modelos de saída e IA; você já verá os resultados.

Visite Community Art se não estiver procurando nada em particular. Verifique o que outros artistas de IA carregam. Você pode se inspirar em sua arte, baixar sua saída ou personalizar prompts.

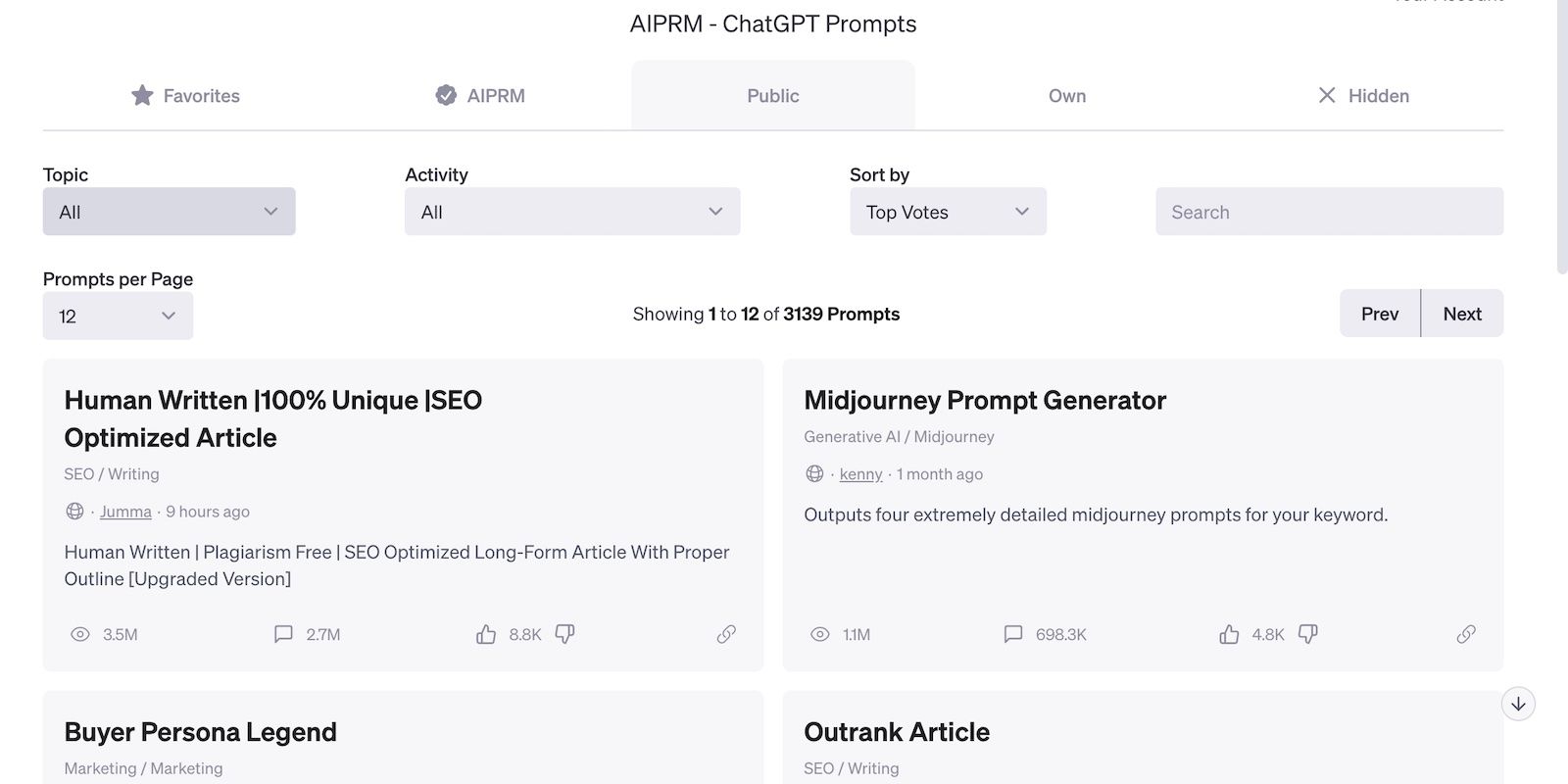

AIPRM é uma extensão robusta do navegador ChatGPT. Possui uma enorme biblioteca dinâmica de prompts que você pode acessar diretamente do ChatGPT. Basta baixar o plug-in e pronto.

Para maximizar o AIPRM, explore as categorias de prompts relevantes para sua carreira. Digamos que você faça SEO. Se você selecionar a seção SEO, encontrará vários prompts para pesquisa de palavras-chave, análise SERP, geração de legendas e integração de palavras-chave.

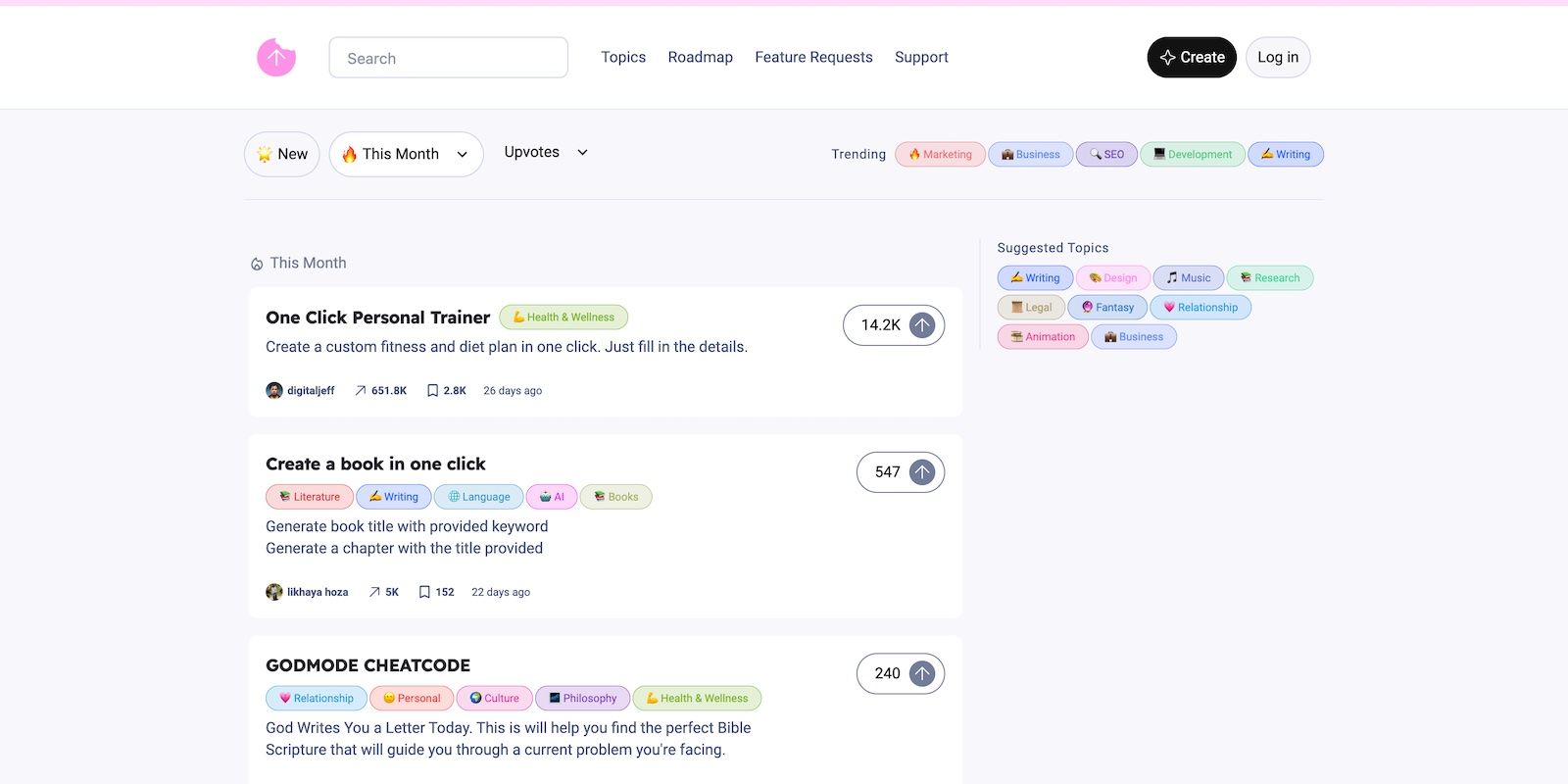

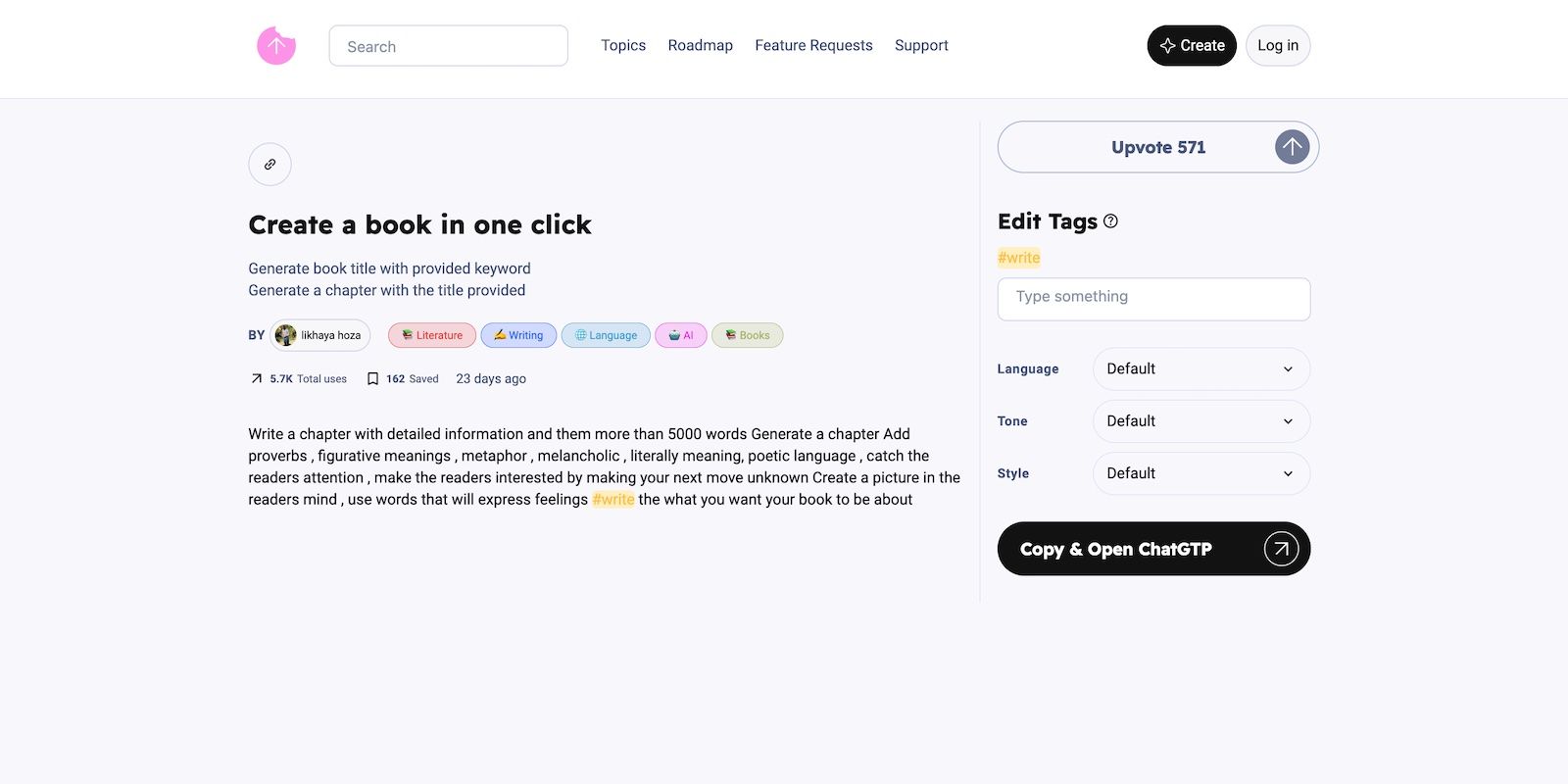

Embora não seja tão popular quanto outros hubs de prompt, você ainda deve explorar o SnackPrompt. A plataforma é gratuita e versátil. Ele apresenta uma interface de usuário exclusiva na qual você pode editar tags e personalizar prompts do site. O botão Copiar Prompt e Abrir ChatGPT também é conveniente.

Você verá mais de uma dúzia de tópicos. Apenas gerencie suas expectativas – a maioria das seções terá menos prompts do que as tendências.

SnackPrompt tem uma extensão do Chrome. Instale-o em seu navegador para acessar a biblioteca SnackPrompt através do ChatGPT.

O ChatX apresenta um mercado acessível e em rápida expansão. As listagens são muito mais baratas aqui do que no PromptBase, além de ter uma enorme biblioteca gratuita. Você encontrará prompts para várias tarefas, modelos de linguagem e geradores de texto para imagem.

Além de compartilhar resultados, o site ensina aos usuários habilidades de engenharia de prompts rígidos e flexíveis. Modelos pré-fabricados produzem resultados limitados. Você realizará mais com a IA se criar fórmulas e instruções por conta própria.

Os novatos em arte de IA acharão Lexica conveniente. Ele sugere combinações e fórmulas rápidas com base nas imagens que você deseja gerar. Digamos que você precise de uma foto realista de um cachorro. Em vez de testar diferentes prompts você mesmo, inspire-se nas milhares de imagens semelhantes no Lexica.

Obviamente, nem todas as amostras corresponderão ao seu conceito. Você pode ajustar a frase, os adjetivos e os descritores de seus prompts até atingir o resultado desejado.

Os profissionais de IA vendem prompts no Etsy desde que começou a acomodar produtos digitais. A frase de pesquisa “avisos de IA” já tem mais de 6.000 resultados no mercado. Você encontrará guias discutindo vários modelos, embora a maioria dos vendedores se concentre no ChatGPT e no Midjourney.

Da mesma forma, você pode vender prompts no Etsy. Embora não atenda exclusivamente a usuários de IA, o site gera mais tráfego do que outros mercados e hubs de prompt.

PromptSea combina OpenSea e PromptBase. Ele permite que você crie NFTs a partir de seus prompts, que você pode cunhar e vender depois – poucas plataformas de IA oferecem esse recurso. Enquanto outros sites já acomodam criptografia, eles ainda venderão seus produtos como prompts, não NFTs.

Sinta-se à vontade para explorar o PromptSea. Apenas observe que a cunhagem de NFTs e os prompts de venda são processos separados – entenda seus riscos e vantagens antes de investir qualquer coisa.

O PromptHero hospeda uma biblioteca diversificada de prompts. Você encontrará instruções de fluxo de trabalho para vários projetos, desde a execução de hacks do ChatGPT até a geração de retratos de personagens de anime. O site também possui um canal no Discord. Os usuários são ativos, mas geralmente mantêm discussões superficiais sobre tarefas básicas.

A assinatura paga do PromptHero oferece um valor decente pelo seu dinheiro. Embora a biblioteca premium não seja nada excepcional, os cursos e programas de IA do site cobrem tópicos avançados e aprofundados.

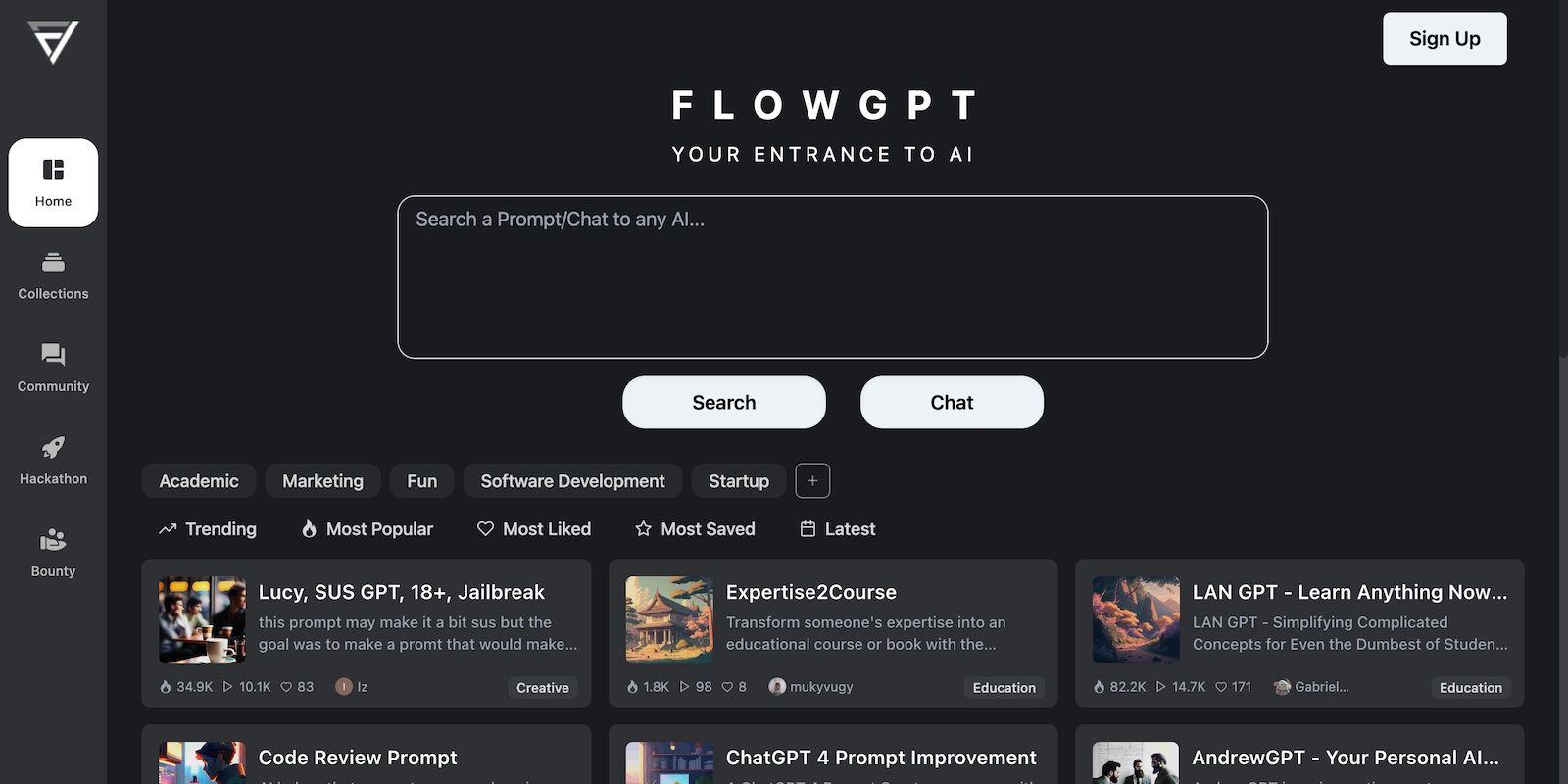

O FlowGPT serve como um guia universal para a engenharia de prompts. Ele permite que você estude prompts de IA e conversas de chatbot sobre vários tópicos. Basta inserir tarefas na barra de pesquisa. O site até sugere qualquer resultado ou ferramenta relevante para sua pesquisa.

Você também pode se conectar com outros usuários. Inicie discussões nos canais da comunidade, busque conselhos de engenheiros experientes e compartilhe sua jornada de IA com outros novatos.

Comunidades on-line podem ajudá-lo a escrever prompts melhores

A engenharia imediata tem baixas barreiras à entrada. Qualquer um pode escrever prompts para tarefas simples, mas a execução de projetos complexos e de várias etapas requer excelentes habilidades de comunicação e programação. Dito isso, você não precisa dominar os prompts de IA sozinho.

Participar de comunidades on-line de apoio ajudará você a entender as formas mais eficazes de conversar com modelos de linguagem. Também existem ferramentas que você pode usar on-line para melhorar suas próprias habilidades de escrita imediata, se preferir fazer as coisas com suas próprias mãos.

.