.

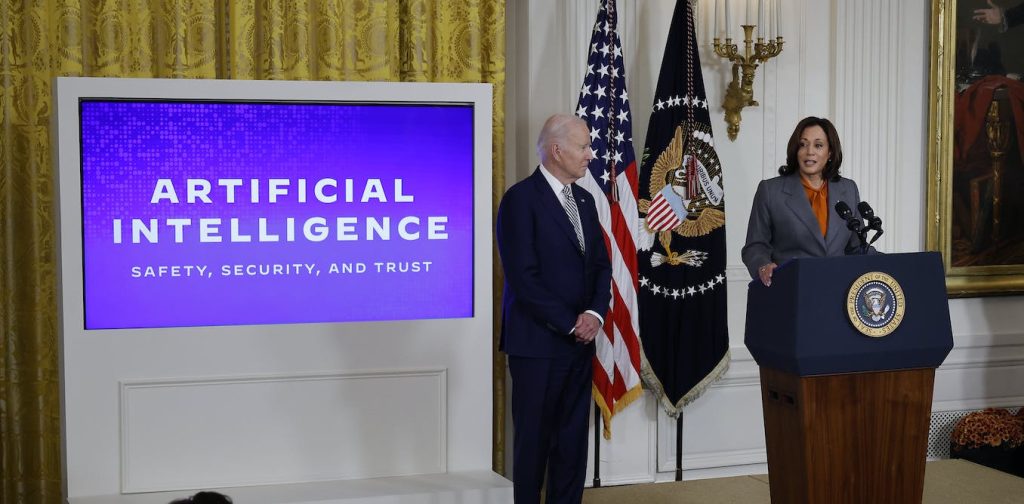

O conjunto abrangente, e até mesmo abrangente, de directrizes para a inteligência artificial que a Casa Branca revelou numa ordem executiva em 30 de Outubro de 2023, mostra que o governo dos EUA está a tentar enfrentar os riscos colocados pela IA.

Como pesquisador de sistemas de informação e IA responsável, acredito que a ordem executiva representa um passo importante na construção de uma IA responsável e confiável.

A ordem é apenas um passo, no entanto, e deixa sem solução a questão de uma legislação abrangente sobre privacidade de dados. Sem essas leis, as pessoas correm maior risco de os sistemas de IA revelarem informações sensíveis ou confidenciais.

Compreender os riscos da IA

A tecnologia é normalmente avaliada em termos de desempenho, custo e qualidade, mas muitas vezes não é avaliada em termos de equidade, justiça e transparência. Em resposta, investigadores e profissionais de IA responsável têm defendido:

O Instituto Nacional de Padrões e Tecnologia (NIST) emitiu uma estrutura abrangente de gestão de risco de IA em janeiro de 2023 que visa abordar muitas dessas questões. A estrutura serve de base para grande parte da ordem executiva do governo Biden. A ordem executiva também autoriza o Departamento de Comércio, sede do NIST no governo federal, a desempenhar um papel fundamental na implementação das diretivas propostas.

Os investigadores da ética da IA há muito que alertam para a necessidade de uma auditoria mais rigorosa dos sistemas de IA para evitar dar a aparência de escrutínio sem responsabilização genuína. Tal como está, um estudo recente que analisou as divulgações públicas de empresas descobriu que as alegações de práticas éticas de IA superam as iniciativas reais de ética em IA. A ordem executiva poderia ajudar, especificando caminhos para impor a responsabilização.

Outra iniciativa importante delineada na ordem executiva é investigar vulnerabilidades de modelos de IA de uso geral em grande escala treinados em grandes quantidades de dados, como os modelos que alimentam o ChatGPT ou DALL-E da OpenAI. A ordem exige que as empresas que constroem grandes sistemas de IA com potencial para afetar a segurança nacional, a saúde pública ou a economia realizem equipes vermelhas e relatem os resultados ao governo. A equipe vermelha está usando métodos manuais ou automatizados para tentar forçar um modelo de IA a produzir resultados prejudiciais – por exemplo, fazer declarações ofensivas ou perigosas, como conselhos sobre como vender drogas.

Reportar ao governo é importante, dado que um estudo recente concluiu que a maioria das empresas que fabricam estes sistemas de IA de grande escala carece de transparência.

Da mesma forma, o público corre o risco de ser enganado pelo conteúdo gerado pela IA. Para resolver isso, a ordem executiva orienta o Departamento de Comércio a desenvolver orientações para rotular conteúdo gerado por IA. As agências federais serão obrigadas a usar marca d’água de IA – tecnologia que marca o conteúdo como gerado por IA para reduzir fraudes e desinformação – embora não seja obrigatório para o setor privado.

A ordem executiva também reconhece que os sistemas de IA podem representar riscos inaceitáveis de danos aos direitos civis e humanos e ao bem-estar dos indivíduos: “Os sistemas de Inteligência Artificial implantados de forma irresponsável reproduziram e intensificaram as desigualdades existentes, causaram novos tipos de discriminação prejudicial e exacerbaram as desigualdades online. e danos físicos.”

O que a ordem executiva não faz

Um desafio fundamental para a regulamentação da IA é a ausência de legislação federal abrangente sobre proteção de dados e privacidade. A ordem executiva apenas apela ao Congresso para que adote legislação sobre privacidade, mas não fornece um quadro legislativo. Resta saber como os tribunais interpretarão as directivas da ordem executiva à luz dos estatutos existentes sobre privacidade do consumidor e direitos de dados.

Sem leis fortes de privacidade de dados nos EUA, como fizeram outros países, a ordem executiva poderia ter um efeito mínimo em conseguir que as empresas de IA aumentassem a privacidade de dados. Em geral, é difícil medir o impacto que os sistemas de IA de tomada de decisão têm na privacidade e nas liberdades dos dados.

Também é importante notar que a transparência algorítmica não é uma panacéia. Por exemplo, a legislação do Regulamento Geral de Proteção de Dados da União Europeia exige “informações significativas sobre a lógica envolvida” em decisões automatizadas. Isto sugere o direito a uma explicação dos critérios que os algoritmos utilizam na sua tomada de decisão. O mandato trata o processo de tomada de decisão algorítmica como algo semelhante a um livro de receitas, o que significa que assume que se as pessoas compreenderem como funciona a tomada de decisão algorítmica, poderão compreender como o sistema as afecta. Mas saber como funciona um sistema de IA não diz necessariamente por que ele tomou uma determinada decisão.

Com a tomada de decisões algorítmicas a tornar-se generalizada, a ordem executiva da Casa Branca e a cimeira internacional sobre segurança da IA sublinham que os legisladores estão a começar a compreender a importância da regulamentação da IA, mesmo que falte legislação abrangente.

.