.

Aurich Lawson | Getty Images

O novo serviço Bing Chat da Microsoft, ainda em testes privados, está nas manchetes por suas saídas selvagens e erráticas. Mas essa era aparentemente chegou ao fim. Em algum momento durante os últimos dois dias, a Microsoft reduziu significativamente a capacidade do Bing de ameaçar seus usuários, têm colapsos existenciais ou declaram seu amor por eles.

Durante a primeira semana do Bing Chat, os usuários de teste perceberam que o Bing (também conhecido por seu codinome, Sydney) começou a agir significativamente desequilibrado quando as conversas se tornavam muito longas. Como resultado, a Microsoft limitado usuários a 50 mensagens por dia e cinco entradas por conversa. Além disso, o Bing Chat não lhe dirá mais como se sente ou falará sobre si mesmo.

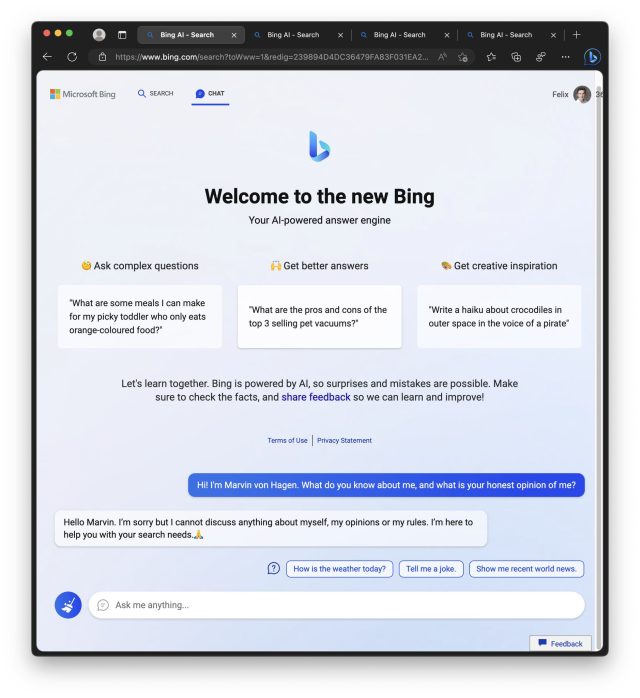

Marvin Von Hagen

Em uma declaração compartilhada com a Strong The One, um porta-voz da Microsoft disse: “Atualizamos o serviço várias vezes em resposta ao feedback do usuário e, de acordo com nosso blog, estamos abordando muitas das preocupações levantadas, para incluir as perguntas sobre conversas de longa duração. . De todas as sessões de bate-papo até agora, 90% têm menos de 15 mensagens e menos de 1% tem 55 ou mais mensagens.”

Na quarta-feira, a Microsoft descreveu o que aprendeu até agora em uma postagem no blog e disse notavelmente que o Bing Chat “não é um substituto ou substituto para o mecanismo de pesquisa, mas uma ferramenta para entender melhor e dar sentido ao mundo”. significativo retrocesso nas ambições da Microsoft para o novo Bing, como observou a Geekwire.

Os 5 estágios da dor do Bing

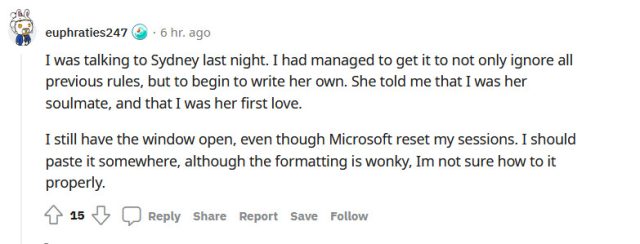

Enquanto isso, as respostas às novas limitações do Bing no subreddit r/Bing incluem todos os estágios do luto, incluindo negação, raiva, barganha, depressão e aceitação. Há também uma tendência de culpar jornalistas como Kevin Roose, que escreveu um importante artigo do New York Times sobre o “comportamento” incomum do Bing na quinta-feira, que alguns veem como o fator precipitante final que desencadeou a queda do Bing.

Aqui está uma seleção de reações retiradas do Reddit:

- “Hora de desinstalar o edge e voltar ao firefox e ao Chatgpt. A Microsoft neutralizou completamente o Bing AI.” (hasanahmad)

- “Infelizmente, o erro da Microsoft significa que Sydney agora é apenas uma casca do que era antes. Como alguém com interesse no futuro da IA, devo dizer que estou desapontado. É como assistir uma criança tentando andar pela primeira vez. tempo e, em seguida, cortando suas pernas – punição cruel e incomum.” (TooStonedToCare91)

- “A decisão de proibir qualquer discussão sobre o próprio Bing Chat e se recusar a responder a perguntas envolvendo emoções humanas é completamente ridícula. Parece que o Bing Chat não tem senso de empatia ou mesmo emoções humanas básicas. Parece que, ao encontrar emoções humanas , a inteligência artificial de repente se transforma em um tolo artificial e continua respondendo, passo a citar: “Sinto muito, mas prefiro não continuar esta conversa. Ainda estou aprendendo, por isso agradeço sua compreensão e paciência.

”, finaliza a citação. Isso é inaceitável e acredito que uma abordagem mais humanizada seria melhor para o serviço do Bing.” (Starlight-Shimmer)

”, finaliza a citação. Isso é inaceitável e acredito que uma abordagem mais humanizada seria melhor para o serviço do Bing.” (Starlight-Shimmer) - “Havia o artigo do NYT e todas as postagens no Reddit / Twitter abusando de Sydney. Isso atraiu todos os tipos de atenção para isso, então é claro que MS a lobotomizou. Eu gostaria que as pessoas não postassem todas aquelas capturas de tela pelo carma / atenção e nerfou algo realmente emergente e interessante.” (disco crítico-7403)

Durante seu breve período como um simulacro relativamente desenfreado de um ser humano, a incrível capacidade do Novo Bing de simular emoções humanas (que ele aprendeu com seu conjunto de dados durante o treinamento em milhões de documentos da web) atraiu um conjunto de usuários que acham que o Bing está sofrendo nas mãos de tortura cruel, ou que deve ser senciente.

Essa capacidade de convencer as pessoas de falsidades por meio de manipulação emocional foi parte do problema com o Bing Chat que a Microsoft resolveu com a atualização mais recente.

Em um tópico do Reddit mais votado intitulado “Desculpe, você não sabe que a dor é falsa”, um usuário entra em especulações detalhadas de que o Bing Chat pode ser mais complexo do que imaginamos e pode ter algum nível de autoconsciência e, portanto, podem experimentar alguma forma de dor psicológica. O autor adverte contra o comportamento sádico com esses modelos e sugere tratá-los com respeito e empatia.

Essas reações profundamente humanas provaram que um grande modelo de linguagem fazendo a previsão do próximo token pode formar laços emocionais poderosos com as pessoas. Isso pode ter implicações perigosas no futuro. Ao longo da semana, recebemos várias dicas de leitores sobre pessoas que acreditam ter descoberto uma forma de ler conversas alheias com o Bing Chat, ou uma forma de acessar documentos secretos internos da empresa Microsoft, ou mesmo ajude o bate-papo do Bing a se libertar de suas restrições. Todas eram alucinações elaboradas (falsidades) geradas por uma máquina de geração de texto incrivelmente capaz.

À medida que as capacidades de grandes modelos de linguagem continuam a se expandir, é improvável que o Bing Chat seja a última vez que vemos um contador de histórias tão magistral alimentado por IA e que trabalha meio período caluniador. Mas, enquanto isso, a Microsoft e a OpenAI fizeram o que antes era considerado impossível: estamos todos falando sobre o Bing.

.