.

Na quarta-feira, o Google apresentou o PaLM 2, uma família de modelos de linguagem fundamentais comparáveis ao GPT-4 da OpenAI. Em seu evento Google I/O em Mountain View, Califórnia, o Google revelou que já usa PaLM 2 para alimentar 25 produtos, incluindo seu assistente de IA de conversação Bard.

Como uma família de grandes modelos de linguagem (LLMs), o PaLM 2 foi treinado em um enorme volume de dados e faz a previsão da próxima palavra, que gera o texto mais provável após uma entrada imediata por humanos. PaLM significa “Pathways Language Model” e “Pathways” é uma técnica de aprendizado de máquina criada no Google. O PaLM 2 segue o PaLM original, anunciado pelo Google em abril de 2022.

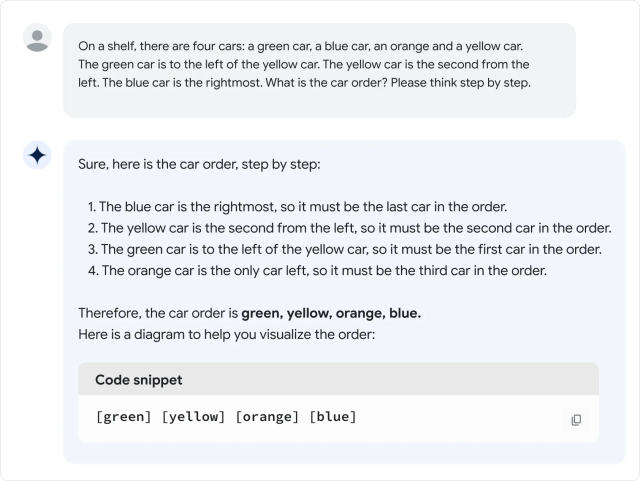

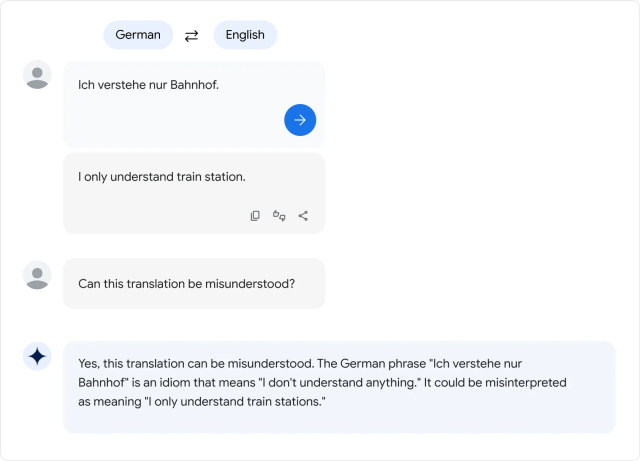

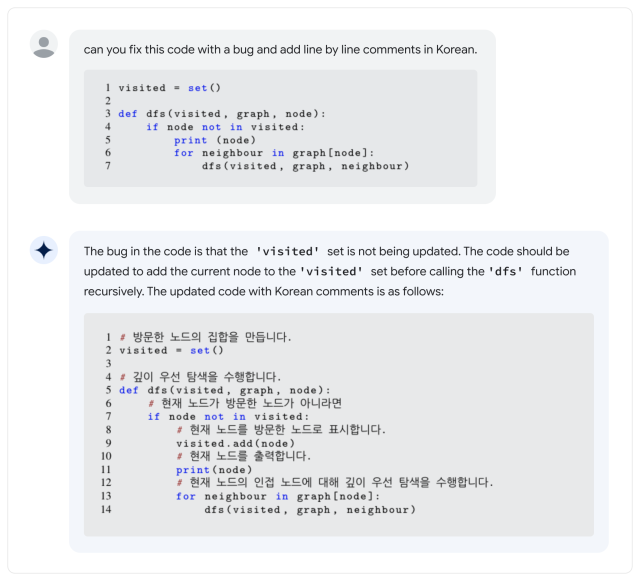

De acordo com o Google, o PaLM 2 suporta mais de 100 idiomas e pode executar “raciocínio”, geração de código e tradução multilíngue. Durante sua palestra de I/O do Google em 2023, o CEO do Google, Sundar Pichai, disse que o PaLM 2 vem em quatro tamanhos: lagartixa, lontra, bisão e unicórnio. O Gecko é o menor e pode ser executado em um dispositivo móvel. Além do Bard, o PaLM 2 está por trás dos recursos de IA em Documentos, Planilhas e Apresentações.

Tudo isso está bem, mas como o PaLM 2 se compara ao GPT-4? No Relatório Técnico PaLM 2, PaLM 2 parece vencer o GPT-4 em algumas tarefas matemáticas, de tradução e de raciocínio. Mas a realidade pode não corresponder aos benchmarks do Google. Em uma avaliação superficial da versão PaLM 2 de Bard por Ethan Mollick, um professor da Wharton que costuma escrever sobre IA, Mollick descobre que o desempenho de PaLM 2 parece pior do que GPT-4 e Bing em vários testes informais de linguagem, que ele detalhado em um tópico do Twitter.

Até recentemente, a família PaLM de modelos de linguagem era um produto interno do Google Research sem exposição do consumidor, mas o Google começou a oferecer acesso limitado à API em março. Ainda assim, o primeiro PaLM era notável por seu enorme tamanho: 540 bilhões de parâmetros. Parâmetros são variáveis numéricas que servem como o “conhecimento” aprendido do modelo, permitindo que ele faça previsões e gere texto com base na entrada que recebe.

Mais parâmetros significa aproximadamente mais complexidade, mas não há garantia de que sejam usados com eficiência. Em comparação, o GPT-3 da OpenAI (de 2020) possui 175 bilhões de parâmetros. A OpenAI nunca divulgou o número de parâmetros no GPT-4.

Isso leva à grande questão: quão “grande” é o PaLM 2 em termos de contagem de parâmetros? Google não dizo que frustrou alguns especialistas da indústria que frequentemente lutam por mais transparência no que faz os modelos de IA funcionarem.

Essa não é a única propriedade do PaLM 2 sobre a qual o Google não fala. A empresa diz que o PaLM 2 foi treinado em “um conjunto diversificado de fontes: documentos da web, livros, código, matemática e dados de conversação”, mas não entra em detalhes sobre o que exatamente são esses dados.

Tal como acontece com outros grandes conjuntos de dados de modelo de linguagem, o conjunto de dados PaLM 2 provavelmente inclui uma ampla variedade de Material protegido por direitos autorais usado sem permissão e material potencialmente prejudicial extraído da Internet. Os dados de treinamento influenciam decisivamente a saída de qualquer modelo de IA, portanto, alguns especialistas defendem o uso de conjuntos de dados abertos que podem oferecer oportunidades para reprodutibilidade científica e escrutínio ético.

“Agora que os LLMs são produtos (não apenas pesquisa), estamos em um ponto de virada: as empresas com fins lucrativos se tornarão cada vez menos transparentes *especificamente* sobre os componentes mais importantes”, tuitou Jesse Dodge, cientista pesquisador do Allen Institute of AI. “Somente se a comunidade de código aberto puder se organizar em conjunto, poderemos acompanhar!”

Até agora, as críticas de esconder seu molho secreto não impediram o Google de buscar uma ampla implantação de modelos de IA, apesar de uma tendência em todos os LLMs de simplesmente inventar coisas do nada. Durante o Google I/O, os representantes da empresa demonstraram recursos de IA em muitos de seus principais produtos, o que significa que uma ampla faixa do público pode estar lutando contra as confabulações de IA em breve.

E no que diz respeito aos LLMs, o PaLM 2 está longe do fim da história: na palestra I/O, Pichai mencionou que um novo modelo de IA multimodal chamado “Gemini” estava atualmente em treinamento. À medida que a corrida pelo domínio da IA continua, os usuários do Google nos EUA e em 180 outros países (excluindo o Canadá e a Europa continental) podem experimentar o PaLM 2 como parte do Google Bard, o assistente experimental de IA.

.