.

Análise Na corrida louca para capitalizar o potencial da IA generativa, a Nvidia continuou a ser a vencedora, mais do que duplicando as suas receitas anuais apenas no segundo trimestre. Para garantir essa liderança, a gigante da GPU aparentemente pretende acelerar o desenvolvimento de novos aceleradores.

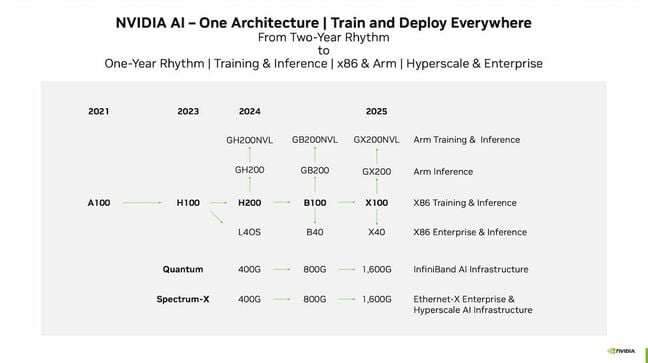

Nas últimas gerações, uma cadência de dois anos foi suficiente para manter uma vantagem competitiva. Mas de acordo com os slides [PDF] em uma apresentação para investidores no início deste mês, não veremos apenas o B100, mas um novo “Super Chip” emparelhando núcleos Arm com a arquitetura Blackwell, bem como um substituto para o L40 e L40S.

Sem surpresas reais, todos esperávamos ouvir sobre a arquitetura de próxima geração da Nvidia e o B100 em suas várias formas em algum momento de 2024.

É o que vem a seguir que é surpreendente.

De acordo com uma apresentação para investidores divulgada este mês, a Nvidia planeja mudar de uma cadência de lançamento de dois anos para um ano (clique para ampliar)

Os slides sugerem que a Nvidia mudará para uma cadência de lançamento de um ano. No slide, vemos que o B100 baseado em Blackwell e seus contemporâneos serão substituídos em 2025 por uma classe de peças “X100”. Assumimos que “X” aqui é um espaço reservado enquanto Huang pondera a qual matemático, cientista da computação ou engenheiro dedicar a arquitetura. Mas a questão permanece: a Nvidia pretende lançar novas GPUs mais rápido do que nunca.

O que isso significa para Intel e AMD?

A mudança representa um problema potencial para fornecedores como AMD e Intel, que ainda estão em uma cadência de lançamento de GPUs e aceleradores de IA de dois anos.

A AMD, por exemplo, lançou seus aceleradores da série Instinct MI200 cerca de um ano depois do A100 da Nvidia, reivindicando desempenho de precisão dupla substancialmente melhor e FLOPS FP16 comparáveis, desde que você ignore o suporte da Nvidia para dispersão.

O primeiro deu à empresa uma clara vantagem em aplicações de computação de alto desempenho em comparação com o A100, por isso não é surpresa que tenha se tornado uma peça tão popular em supercomputadores como o Lumi da Europa ou os Supercomputadores Frontier do Departamento de Energia.

Agora, com a IA generativa acompanhando o ritmo da demanda, a AMD espera desafio O domínio da Nvidia na área de IA com GPUs e APUs melhor ajustadas para cargas de trabalho de menor precisão. Mas, se o desempenho estimativas para o MI300A/X que nosso site irmão A próxima plataforma que reunimos, os chips mais recentes da AMD podem não ser competitivos com o H100 em FLOPS, mas podem ter uma vantagem em termos de memória. Os chips estão programados para oferecer 128 GB-192 GB de memória HBM3, o que poderia dar aos chips uma vantagem estreita sobre o H100.

A Intel, que deu grande importância à IA na sua conferência de inovação em setembro, está num barco semelhante. A empresa já havia adotado uma cadência de lançamento acelerada para CPUs e GPUs, mas desistiu deste último em meio a uma reestruturação da divisão e medidas de redução de custos.

Esta decisão resultou no cancelamento de sua arquitetura XPU CPU-GPU e da Ponte Rialto, o sucessor dos aceleradores Ponte Vecchio que alimentam o supercomputador Aurora do Argonne National Lab. A empresa então adiou seu design redefinido do Falcon Shores de 2024 para 2025, argumentando que a mudança “corresponde às expectativas dos clientes no lançamento de novos produtos e dá tempo para desenvolver seus ecossistemas”.

Este último é interessante, pois verá a Intel trazer suas arquiteturas GPU Max e Habana Labs sob um plataforma única. Até então, ficaremos presos às famílias Gaudi2 e GPU Max da Intel até o lançamento do Gaudi3.

Gaudi2 demonstrou desempenho respeitável comparado ao A100, mas, quando foi lançado no ano passado, o H100 mais capaz da Nvidia já havia sido lançado. anunciado e estava a meses de ser enviado.

O acelerador de próxima geração da Habana, Gaudi3, parece promissor, mas não terá apenas que superar o H100 e as peças da série MI300 da AMD, mas também enfrentar o lançamento iminente dos aceleradores B100 da Nvidia.

Isso não significa que MI300 ou Gaudi3 estarão necessariamente mortos na chegada, mas sim que sua janela de relevância pode acabar sendo muito mais curta do que no passado, disse o fundador da SemiAnalysis, Dylan Patel, que foi um dos primeiros a pegar em o roteiro acelerado, disse Strong The One.

“Há uma janela em que o MI300 é o melhor chip do mercado”, disse ele, acrescentando que, embora não saibamos tanto sobre o Gaudi3 da Intel, se ele for dimensionado da maneira que ele espera, será melhor que o H100 da Nvidia. .

No longo prazo, ele espera que a Intel e a AMD tenham que seguir o exemplo e acelerar seus próprios roteiros de desenvolvimento de GPU e aceleradores.

E como nós apontou no passado, mesmo que os aceleradores de próxima geração da Intel e da AMD não conseguissem vencer a Nvidia, eles poderiam acabar obtendo vitórias com base apenas na disponibilidade. Os H100 da Nvidia são supostamente sendo limitado pela disponibilidade de tecnologia de embalagem avançada fornecida pela TSMC. Não se espera que essa escassez seja resolvida até 2024. E embora a AMD provavelmente enfrente desafios semelhantes com suas peças da série MI300, que também utilizam essas técnicas avançadas de embalagem, a Intel tem a capacidade de fazer sua própria embalagem, embora não seja claro se Gaudi3 realmente o usa ou se eles estão no mesmo barco que Nvidia e AMD.

Não apenas sobre os aceleradores

Mas é importante notar que a Nvidia não está apenas acelerando a cadência de lançamento de seus aceleradores. Também está acelerando o desenvolvimento de seus portfólios de comutação Quantum Infiniband e Spectrum Ethernet.

Embora uma única GPU seja capaz, o treinamento de IA e os aplicativos de HPC geralmente exigem grandes clusters de aceleradores para operar com eficiência e isso significa ter uma rede capaz de acompanhá-los.

Com o aquisição do parceiro de longa data Mellanox em 2020, a Nvidia assumiu o controle de sua pilha de rede, que inclui os portfólios de switching e NIC da empresa.

No momento, os switches mais rápidos da Nvidia atingem 25,6 Tbps para Infiniband e 51,2 Tbps para Ethernet. Essa largura de banda é dividida entre várias portas de 200-400 Gbps. No entanto, sob esta nova cadência de lançamento, a Nvidia pretende aumentar as velocidades das portas para 800 Gbps em 2024 e 1.600 Gbps em 2025.

Isso não apenas exigirá silício de switch mais capaz na faixa de 51,2-102,4 Tbps de capacidade, mas também serializadores/desserializadores (SerDes) de 200 Gbps mais rápidos para suportar módulos QSFP-DD de 1.600 Gbps.

A tecnologia necessária para atingir este nível de desempenho de rede já existe. SerDes de 200 Gbps já foram demonstrados pela Broadcom. No entanto, ainda não vimos isso da Nvidia. E, idealmente, observa Patel, a Nvidia vai querer chegar a 102,4 Tbps em Infiniband e Ethernet para realmente capitalizar em NICs com capacidade de 800 Gbps.

Um problema PCIe

É aqui que as falhas no plano diretor da Nvidia podem começar a aparecer. Essas velocidades mais altas podem não ser sustentáveis nesse cronograma usando NICs existentes devido às limitações do PCIe. Hoje, o limite prático para uma NIC é uma única porta de 400 Gbps. O PCIe 6.0 deve nos levar a 800 Gbps, mas precisaremos do PCIe 7.0 antes de podermos falar seriamente sobre 1.600 Gbps.

Já sabemos que os Xeons de próxima geração da Intel não suportarão PCIe 6.0 quando forem lançados em 2024, e simplesmente não sabemos o suficiente sobre os próximos Turin Epycs da AMD para dizer se o farão ou não. Embora a AMD tenha, nas últimas gerações, liderado a Intel na implementação de novos padrões PCIe.

No entanto, o x86 não é a única escolha da Nvidia. A empresa agora tem suas próprias CPUs baseadas em Arm. Então, talvez a Nvidia planeje oferecer suporte a PCIe 6.0 no sucessor do Grace. Os processadores Arm foram um dos primeiros a adicionar suporte para PCIe 5.0 no início de 2022, então há motivos para acreditar que isso pode acontecer novamente.

Devido a esse problema, Patel espera que existam duas versões do B100. Uma que usa PCIe 5.0 e tem a mesma potência de design térmico (TDP) de 700 watts que o H100, para que os clientes possam inserir uma nova placa-mãe HGX em seus designs de chassi existentes. O segundo, ele avalia, terá potência muito maior, exigirá refrigeração líquida e mudará para PCIe 6.0.

No entanto, quando você começar a falar sobre portas de 1.600 Gbps como a Nvidia deseja saltar em 2025, você precisará do PCIe 7.0, que ainda não foi finalizado. “Você fala com o órgão de padronização, ninguém espera nada do PCIe 7.0 até 2026, no mínimo, para os produtos”, disse ele. “É simplesmente impossível fazer isso nesse cronograma.”

A outra opção é ignorar o barramento PCIe. Como Patel aponta, a Nvidia na verdade não precisa dos níveis de largura de banda PCIe 6.0 ou PCIe 7.0 entre a GPU e a CPU, apenas entre a NIC e a GPU. Então, em vez disso, ele espera que a Nvidia ignore em grande parte a CPU como um gargalo.

Na verdade, a Nvidia já está fazendo isso até certo ponto. Nas gerações mais recentes, a Nvidia encadeou efetivamente as GPUs de suas NICs ConnectX usando um switch PCIe. Patel diz que a Nvidia provavelmente expandirá essa abordagem para atingir velocidades de porta superiores às que um único slot PCIe 5.0 ou PCIe 6.0 x16 seria capaz de acomodar.

E com a geração X100, ele diz que há rumores de que a Nvidia pode abandonar o PCIe para comunicações entre a NIC e a GPU para o X100 em 2025 em favor de sua interconexão proprietária.

Falando nisso, aqueles que têm prestado atenção aos desenvolvimentos de IA da Nvidia podem estar se perguntando onde se encaixa a estrutura NVLinks de largura de banda superalta do fabricante de chips. A tecnologia é usada para mesclar várias GPUs para que elas efetivamente se comportem como uma grande. Adicione um switch NVLink e você poderá estender para vários nós.

No entanto, existem algumas limitações significativas no NVLink, especialmente quando se trata de alcance e escalabilidade. Embora o NVLink seja muito mais rápido que ambos, também está limitado a 256 dispositivos. Para escalar além disso, você precisará empregar Infiniband ou Ethernet para unir clusters adicionais.

A malha NVLink também é boa apenas para comunicações de GPU para GPU. Isso não ajudará na entrada e saída de dados do sistema ou na coordenação de cargas de trabalho.

Como resultado, o sucesso ou não da Nvidia em acelerar seu cronograma de lançamento dependerá muito de fazer com que a rede cresça rápido o suficiente para evitar o sufocamento de seus chips. ®

Preciso de mais? Confira a próxima plataforma assuma o plano da Nvidia.

.