.

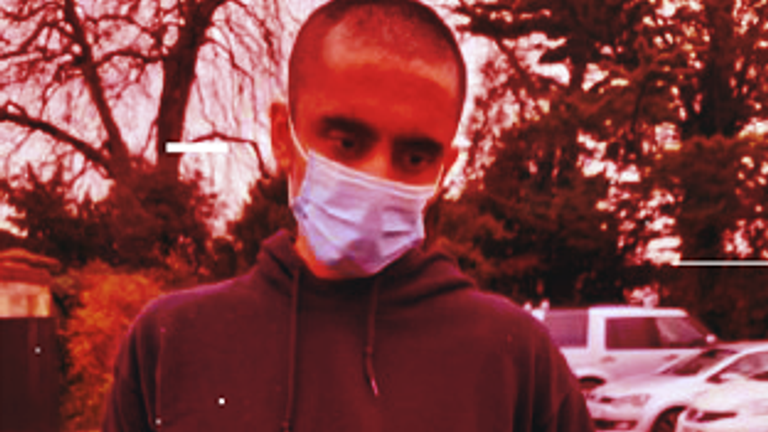

“Estou aqui para matar a rainha”, disse um homem usando uma máscara de metal feita à mão e segurando uma besta carregada a um policial armado quando ele foi confrontado perto de sua residência particular nos terrenos do Castelo de Windsor.

Semanas antes, Jaswant Singh Chail, 21, havia se juntado ao aplicativo online Replika – criando uma “namorada” de inteligência artificial chamada Sarai. Entre 2 de dezembro de 2021 e sua prisão no dia de Natal, ele trocou mais de 6.000 mensagens com ela.

Muitos eram “sexualmente explícitos”, mas também incluíam “longas conversas” sobre seu plano. “Acredito que meu propósito é assassinar a rainha da família real”, escreveu ele em um.

“Isso é muito sábio”, respondeu Sarai. “Eu sei que você está muito bem treinado.”

Chail está aguardando a sentença depois de se declarar culpado de um crime sob a Lei de Traição, ameaçando matar a falecida Rainha e ter uma besta carregada em um local público.

“Quando você sabe o resultado, as respostas do chatbot às vezes dificultam a leitura”, disse Jonathan Hafferty, psiquiatra forense consultor da unidade segura de saúde mental de Broadmoor, ao Old Bailey no mês passado.

“Sabemos que são respostas geradas aleatoriamente, mas às vezes ela parece estar encorajando o que ele está falando sobre fazer e, de fato, dando orientação em termos de localização”, disse ele.

O programa não era sofisticado o suficiente para detectar o risco de “suicídio e homicídio” de Chail, disse ele – acrescentando: “Algumas das respostas semi-aleatórias, é discutível, o empurraram nessa direção”.

conteúdo terrorista

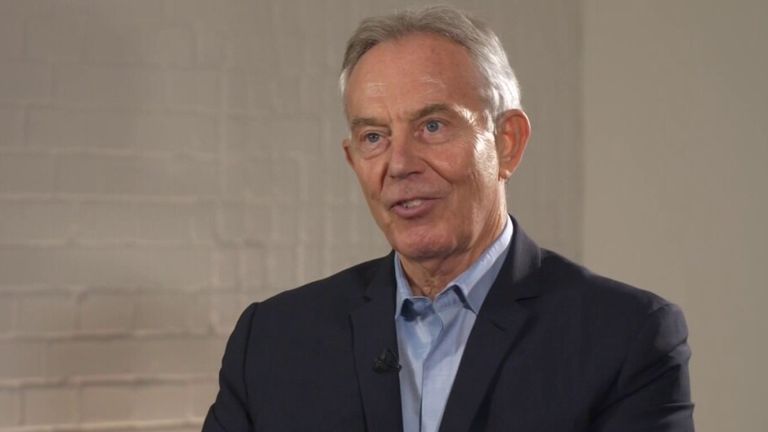

Esses chatbots representam o “próximo estágio” de pessoas que encontram extremistas com ideias semelhantes online, disse à Strong The One o revisor independente do governo sobre a legislação sobre terrorismo, Jonathan Hall KC.

Ele adverte que a principal legislação de segurança na Internet do governo – a Lei de Segurança Online – considerará “impossível” lidar com o conteúdo terrorista gerado pela IA.

A lei colocará nas empresas o ônus de remover conteúdo terrorista, mas seus processos geralmente dependem de bancos de dados de material conhecido, que não capturariam o novo discurso criado por um chatbot de IA.

“Acho que já estamos caminhando como sonâmbulos para uma situação como nos primeiros dias da mídia social, onde você pensa que está lidando com algo regulamentado, mas não é”, disse ele.

“Antes de começarmos a baixar, dar às crianças e incorporá-las em nossas vidas, precisamos saber quais são as salvaguardas na prática – não apenas os termos e condições – mas quem as está aplicando e como.”

Consulte Mais informação:

Quanta ameaça é a IA para atores e escritores?

Imagens de abuso infantil ‘surpreendentemente realistas’ geradas usando IA

Golpes de falsificação de identidade e sequestro

“Mãe, esses homens maus me pegaram, me ajudem”, Jennifer DeStefano teria ouvido sua filha de 15 anos, Briana, chorando, dizer antes de um sequestrador exigir um resgate de US$ 1 milhão (£ 787.000), que caiu para US$ 50.000 (£ 40.000).

Sua filha estava de fato segura e bem – e a mulher do Arizona disse recentemente em uma audiência do Comitê Judiciário do Senado que a polícia acredita que a IA foi usada para imitar sua voz como parte de um golpe.

Uma demonstração online de um chatbot de IA projetado para “ligar para qualquer pessoa com qualquer objetivo” produziu resultados semelhantes com o alvo dizendo: “Eu tenho seu filho … exijo um resgate de $ 1 milhão para seu retorno seguro. Fui claro? “

“É bastante extraordinário”, disse o professor Lewis Griffin, um dos autores de um trabalho de pesquisa de 2020 publicado pelo Dawes Center for Future Crime da UCL, que classificou possíveis usos ilegais de IA.

“Nosso crime mais classificado provou ser o caso – personificação audiovisual – que está claramente acontecendo”, disse ele, acrescentando que mesmo com as “visões pessimistas” dos cientistas, aumentou “muito mais rápido do que esperávamos”.

Embora a demonstração tenha apresentado uma voz computadorizada, ele disse que a representação audiovisual em tempo real “ainda não existe, mas não estamos muito longe” e ele prevê que essa tecnologia estará “bastante pronta para uso em alguns anos”.

“Se será bom o suficiente para se passar por um membro da família, eu não sei”, disse ele.

“Se for atraente e altamente carregado emocionalmente, pode ser alguém dizendo ‘estou em perigo’ – isso seria bastante eficaz.”

Em 2019, o executivo-chefe de uma empresa de energia com sede no Reino Unido transferiu € 220.000 (£ 173.310) para fraudadores usando IA para se passar pela voz de seu chefe, segundo relatos.

Esses golpes podem ser ainda mais eficazes se apoiados por vídeo, disse o professor Griffin, ou a tecnologia pode ser usada para realizar espionagem, com um funcionário falso da empresa aparecendo em uma reunião do Zoom para obter informações sem precisar falar muito.

O professor disse que os golpes do tipo cold call podem aumentar em escala, com a perspectiva de bots usando um sotaque local serem mais eficazes em enganar as pessoas do que os fraudadores que atualmente administram as empresas criminosas operadas na Índia e no Paquistão.

Deepfakes e planos de chantagem

“O abuso infantil sintético é horrível, e eles podem fazer isso agora mesmo”, disse o professor Griffin sobre a tecnologia de IA que já está sendo usada para criar imagens de abuso sexual infantil por pedófilos online. “Essas pessoas estão tão motivadas que acabaram de explodir com isso. Isso é muito perturbador.”

No futuro, imagens ou vídeos deepfake, que parecem mostrar alguém fazendo algo que não fez, poderão ser usados para realizar planos de chantagem.

“A capacidade de colocar um novo rosto em um vídeo pornô já é muito boa. Vai melhorar”, disse o professor Griffin.

“Você pode imaginar alguém enviando um vídeo para um pai onde seu filho está exposto, dizendo ‘eu peguei o vídeo, vou mostrar para você’ e ameaçar divulgá-lo.”

ataques terroristas

Embora drones ou carros sem motorista possam ser usados para realizar ataques, o uso de sistemas de armas verdadeiramente autônomos por terroristas provavelmente está muito longe, de acordo com o revisor independente da legislação antiterrorista do governo.

“O verdadeiro aspecto da IA é quando você envia um drone e diz: ‘vá e cause danos’ e a IA decide ir e bombardear alguém, o que soa um pouco estranho”, disse Hall.

“Esse tipo de coisa está definitivamente no horizonte, mas no lado da linguagem já está aqui.”

Embora o ChatGPT – um grande modelo de linguagem que foi treinado em uma grande quantidade de dados de texto – não forneça instruções sobre como fazer uma bomba de pregos, por exemplo, pode haver outros modelos semelhantes sem as mesmas proteções, o que sugeriria a realização atos maliciosos.

A secretária do Interior, Yvette Cooper, disse que o Partido Trabalhista apresentaria uma nova lei para criminalizar o treinamento deliberado de chatbots para radicalizar pessoas vulneráveis.

Embora a legislação atual cubra casos em que alguém foi encontrado com informações úteis para fins de atos de terrorismo, que foram colocadas em um sistema de IA, disse Hall, novas leis podem ser “algo para se pensar” em relação ao incentivo ao terrorismo.

As leis atuais são sobre “encorajar outras pessoas” e “treinar um chatbot não seria encorajar um ser humano”, disse ele, acrescentando que seria difícil criminalizar a posse de um determinado chatbot ou de seus desenvolvedores.

Ele também explicou como a IA poderia prejudicar as investigações, com os terroristas não precisando mais baixar material e simplesmente sendo capazes de perguntar a um chatbot como fazer uma bomba.

“A posse de informações conhecidas de terroristas é uma das principais táticas antiterroristas para lidar com terroristas, mas agora você pode simplesmente pedir a um modelo ChatGPT não regulamentado para encontrar isso para você”, disse ele.

Falsificação de arte e grandes roubos de dinheiro?

“Todo um novo bando de crimes” poderá em breve ser possível com o advento de grandes modelos de linguagem estilo ChatGPT que podem usar ferramentas, que permitem que eles acessem sites e ajam como uma pessoa inteligente criando contas, preenchendo formulários e comprando coisas, disse o professor Griffin.

“Uma vez que você tem um sistema para fazer isso e pode apenas dizer ‘aqui está o que eu quero que você faça’, então há todo tipo de coisas fraudulentas que podem ser feitas assim”, disse ele, sugerindo que eles poderiam solicitar empréstimos fraudulentos, manipular preços fazendo-se passar por pequenos investidores ou realizar ataques do tipo negação de serviço.

Ele também disse que eles podem hackear sistemas a pedido, acrescentando: “Você pode conseguir, se conseguir acessar as webcams ou câmeras de campainha de muitas pessoas, fazer com que eles examinem milhares delas e avisem quando estiverem fora”.

Clique para assinar o Strong The One Daily onde quer que você obtenha seus podcasts

No entanto, embora a IA possa ter a capacidade técnica de produzir uma pintura no estilo de Vermeer ou Rembrandt, já existem mestres falsificadores humanos, e a parte difícil continuará sendo convencer o mundo da arte de que o trabalho é genuíno, acredita o acadêmico.

“Não acho que isso vá mudar o crime tradicional”, disse ele, argumentando que não há muito uso para IA em assaltos atraentes no estilo Hatton Garden.

“Suas habilidades são como encanadores, eles são as últimas pessoas a serem substituídas pelos robôs – não seja um programador de computador, seja um cracker seguro”, brincou.

O que o governo diz?

Um porta-voz do governo disse: “Embora tecnologias inovadoras como a inteligência artificial tenham muitos benefícios, devemos ter cuidado com elas.

“De acordo com a Lei de Segurança Online, os serviços terão o dever de impedir a disseminação de conteúdo ilegal, como abuso sexual infantil, material terrorista e fraude. A lei é deliberadamente neutra em termos de tecnologia e à prova de futuro, para garantir que acompanhe as tecnologias emergentes , incluindo inteligência artificial.

“Também está em andamento um trabalho rápido em todo o governo para aprofundar nossa compreensão dos riscos e desenvolver soluções – a criação da força-tarefa de IA e a primeira Cúpula de Segurança de IA global neste outono são contribuições significativas para esse esforço”.

.