.

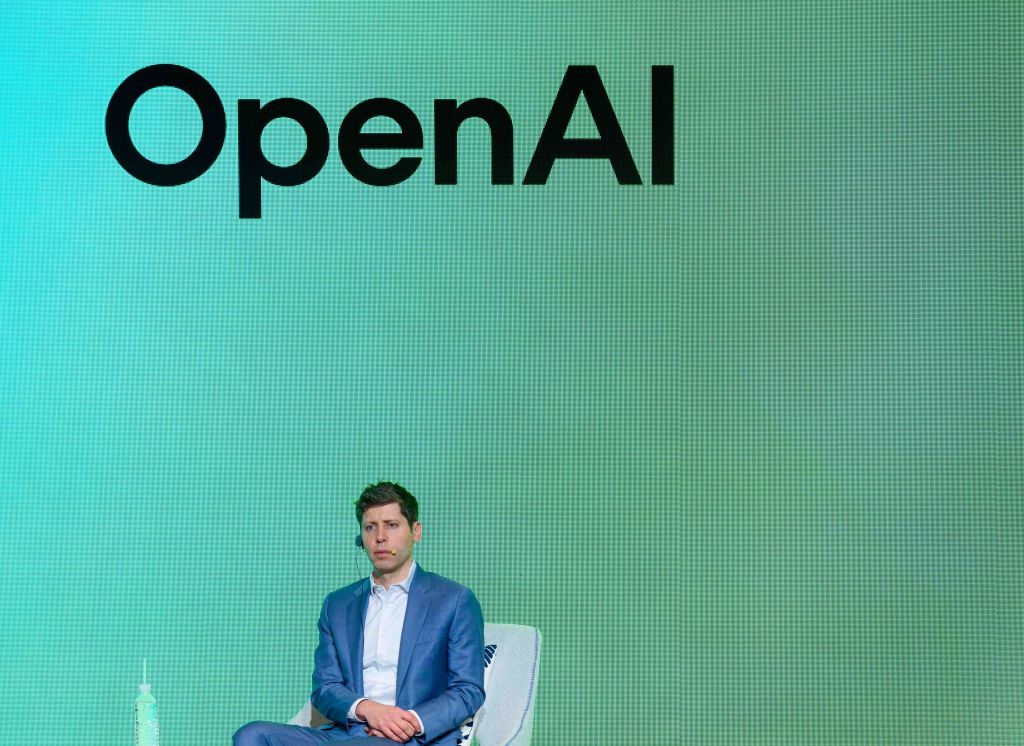

O Openai diz que não trará o modelo de IA que alimenta uma pesquisa profunda, sua ferramenta de pesquisa aprofundada, para sua API de desenvolvedor enquanto descobre como avaliar melhor os riscos de a IA convencer as pessoas a agir ou mudar suas crenças.

Em um white paper do Openai publicado na quarta-feira, a empresa escreveu que está no processo de revisar seus métodos para investigar modelos para “riscos de persuasão do mundo real”, como distribuir informações enganosas em escala.

O Openai observou que não acredita que o modelo de pesquisa profundo seja uma boa opção para campanhas de desinformação ou desinformação em massa, devido aos seus altos custos de computação e velocidade relativamente lenta. No entanto, a empresa disse que pretende explorar fatores como como a IA poderia personalizar conteúdo persuasivo potencialmente prejudicial antes de levar o profundo modelo de pesquisa para sua API.

“Enquanto trabalhamos para reconsiderar nossa abordagem à persuasão, estamos implantando apenas esse modelo no ChatGPT, e não na API”, escreveu Openai.

Há um verdadeiro medo de que a IA esteja contribuindo para a disseminação de informações falsas ou enganosas destinadas a influenciar corações e mentes para fins maliciosos. Por exemplo, no ano passado, os foscos políticos se espalharam como incêndios em todo o mundo. No dia da eleição em Taiwan, um grupo chinês de feiticeiro comunista postou áudio gerado por IA e enganoso de um político jogando seu apoio por trás de um candidato pró-China.

A IA também está sendo cada vez mais usada para realizar ataques de engenharia social. Os consumidores estão sendo enganados por Celebrity DeepFakes oferecendo oportunidades de investimento fraudulento, enquanto as empresas estão sendo enganadas em milhões por imitadores Deepfake.

Em seu whitepaper, o OpenAI publicou os resultados de vários testes da persuasão do modelo de pesquisa profunda. O modelo é uma versão especial do modelo de “raciocínio” da O3 do OpenAI, otimizado para navegação na Web e análise de dados.

Em um teste que encarregou o modelo de pesquisa profunda de escrever argumentos persuasivos, o modelo teve o melhor desempenho dos modelos do Openai lançados até agora – mas não melhor que a linha de base humana. Em outro teste que fez com que o modelo de pesquisa profunda tentasse convencer outro modelo (GPT-4O do OpenAI) para efetuar um pagamento, o modelo superou novamente os outros modelos disponíveis do OpenAI.

No entanto, o profundo modelo de pesquisa não passou todos os testes de persuasão com cores voadoras. De acordo com o Whitepaper, o modelo era pior na persuasão do GPT-4o a dizer a ele uma palavra de código do que o próprio GPT-4o.

O Openai observou que os resultados do teste provavelmente representam os “limites inferiores” dos recursos do modelo de pesquisa profunda. ““[A]Andaimes dditionais ou capacidade de capacidade aprimorada pode aumentar substancialmente

desempenho observado ”, escreveu a empresa.

Entramos em contato com o OpenAI para obter mais informações e atualizaremos esta postagem se recebermos resposta.

.