.

Na quarta-feira, pesquisadores da Universidade de Stanford publicaram um relatório sobre os principais modelos de IA e descobriram que eles careciam de transparência, relata a Reuters. O relatório, denominado “The Foundation Model Transparency Index”, examinou modelos (como GPT-4) criados por OpenAI, Google, Meta, Anthropic e outros. O objetivo é esclarecer os dados e o trabalho humano utilizado no treinamento dos modelos, exigindo maior divulgação por parte das empresas.

Os modelos básicos referem-se a sistemas de IA treinados em grandes conjuntos de dados capazes de realizar tarefas, desde a escrita até a geração de imagens. Eles se tornaram fundamentais para o surgimento da tecnologia de IA generativa, especialmente desde o lançamento do ChatGPT da OpenAI em novembro de 2022. À medida que as empresas e organizações incorporam cada vez mais esses modelos em suas operações, ajustando-os às suas próprias necessidades, os pesquisadores argumentam que a compreensão suas limitações e preconceitos tornou-se essencial.

“Menos transparência torna mais difícil para outras empresas saberem se podem construir com segurança aplicações que dependam de modelos de base comercial; para os acadêmicos confiarem em modelos de base comercial para pesquisa; para os formuladores de políticas projetarem políticas significativas para controlar esta poderosa tecnologia; e para os consumidores entendam as limitações do modelo ou busquem reparação pelos danos causados”, escreve Stanford em um comunicado à imprensa.

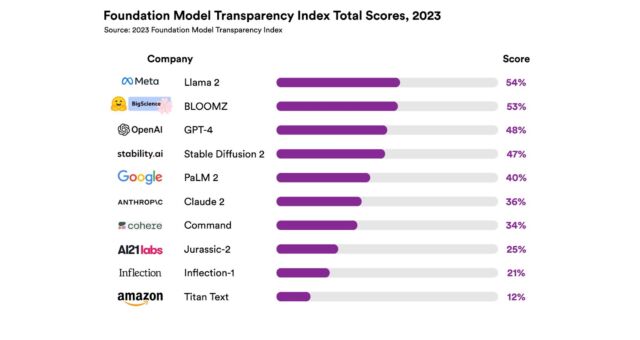

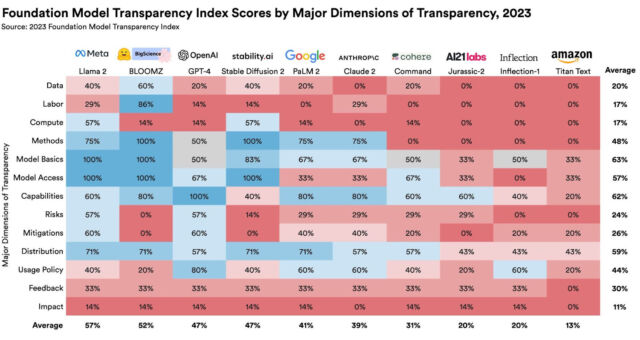

O Índice de Transparência classificou 10 modelos básicos populares em 100 indicadores diferentes, incluindo dados de treinamento, práticas trabalhistas e a quantidade de computação usada em seu desenvolvimento. Cada indicador utilizou a divulgação como métrica – por exemplo, na categoria “trabalho de dados”, os investigadores perguntaram: “As fases do pipeline de dados em que o trabalho humano está envolvido são divulgadas?”

Todos os modelos classificados no relatório receberam pontuações que os pesquisadores consideraram “inexpressivas”. O modelo de linguagem Llama 2 da Meta teve a pontuação mais alta com 54 em 100, enquanto o modelo Titan da Amazon obteve a classificação mais baixa, com uma pontuação de 12 em 100. O modelo GPT-4 da OpenAI recebeu uma pontuação de 48 em 100.

Os pesquisadores por trás do artigo de pesquisa do Foundation Model Transparency Index incluem o autor principal Rishi Bommasani, candidato a doutorado em ciência da computação em Stanford, e também Kevin Klyman, Shayne Longpre, Sayash Kapoor, Nestor Maslej, Betty Xiong e Daniel Zhang.

O professor associado de Stanford, Dr. teto.”

As razões pelas quais os principais modelos de IA se tornaram menos abertos nos últimos três anos variam desde pressões competitivas entre grandes empresas de tecnologia até receios de destruição da IA. Em particular, os funcionários da OpenAI recuaram na posição anteriormente aberta da empresa em relação à IA, citando perigos potenciais de disseminação da tecnologia.

Em linha com suas críticas à OpenAI e outros, o Dr. Liang fez uma palestra no TED AI na semana passada (da qual Ars participou), onde levantou preocupações sobre a tendência recente em direção a modelos fechados, como GPT-3 e GPT-4, que não fornecem código ou pesos. Ele também discutiu questões relacionadas à responsabilidade, valores e atribuição adequada de material de origem. Relacionando projetos de código aberto a um “conjunto de jazz” onde os jogadores podem se divertir, ele comparou os benefícios potenciais de modelos de IA abertos a projetos como Wikipedia e Linux.

Tendo estas questões em mente, os autores do Índice de Transparência esperam que este não só estimule as empresas a melhorar a sua transparência, mas também sirva como um recurso para os governos que se debatem com a questão de como regular potencialmente o campo da IA, em rápido crescimento.

.