.

O iPhone 15 Pro e o iPhone 15 Pro Max serão os únicos telefones disponíveis este ano alimentados por um chipset feito com o nó de processo de 3 nm. E isso deve ser importante porque quanto menor o número do nó do processo, menor o conjunto de recursos do chip. Um conjunto de recursos menor significa que um chip pode ter mais transistores e mais transistores tornam um chip mais poderoso e eficiente em termos de energia.

Normalmente, o risco na produção de chips é colocado no projetista do chip, que, no caso dos SoCs da série A, é a Apple. Se um dado estiver com defeito, o projetista do chip ainda terá que pagar por isso. É por isso que as fundições com baixos rendimentos geralmente não mantêm sua lista de clientes atual por muito tempo. A produção inicial de 3 nm da TSMC teve uma taxa de rendimento de 70%, de acordo com A informaçãoo que não é ruim, especialmente para o primeiro ano de grande produção de um novo nó de processo.

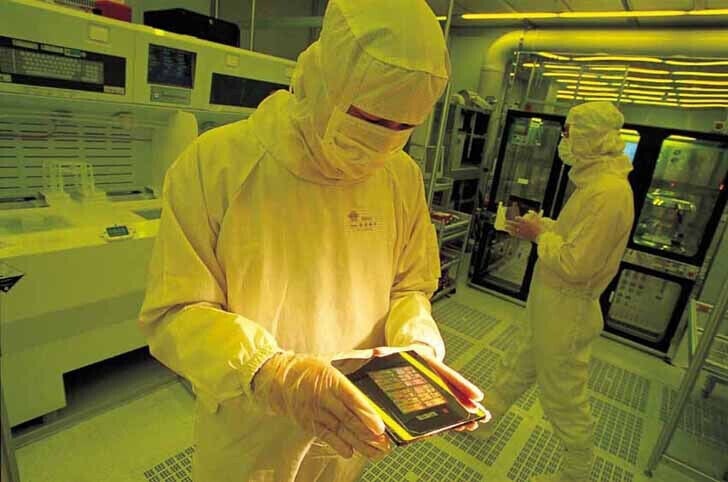

A TSMC deu à Apple um acordo amoroso sobre a produção do chipset A17 Bionic deste último

Não que a Apple tenha que se preocupar em pagar a TSMC por matrizes ruins. Os pedidos da Apple com a TSMC são tão grandes que a fundição pode se dar ao luxo de assumir o risco de baixos rendimentos. É isso mesmo, a Apple não é financeiramente responsável por chips que não passam pelo controle de qualidade, pois a TSMC vai consumir o custo de matrizes ruins. Este acordo amoroso pode economizar uma quantia decente de dinheiro para a Apple, possivelmente uma quantia na casa dos bilhões.

A Apple reservou toda a produção de 3 nm da TSMC este ano, o primeiro ano em que esteve disponível. Essa exclusividade durará cerca de um ano antes que a capacidade suficiente seja liberada para permitir que outros clientes da TSMC obtenham seus designs de chip de 3 nm fabricados. Acredita-se que a Apple tenha sido responsável por 23% dos lucros da TSMC no ano passado, de US$ 72 bilhões, de modo que a Apple geralmente obtém a primeira chance em um novo nó de processo antes que outras empresas o façam.

.