.

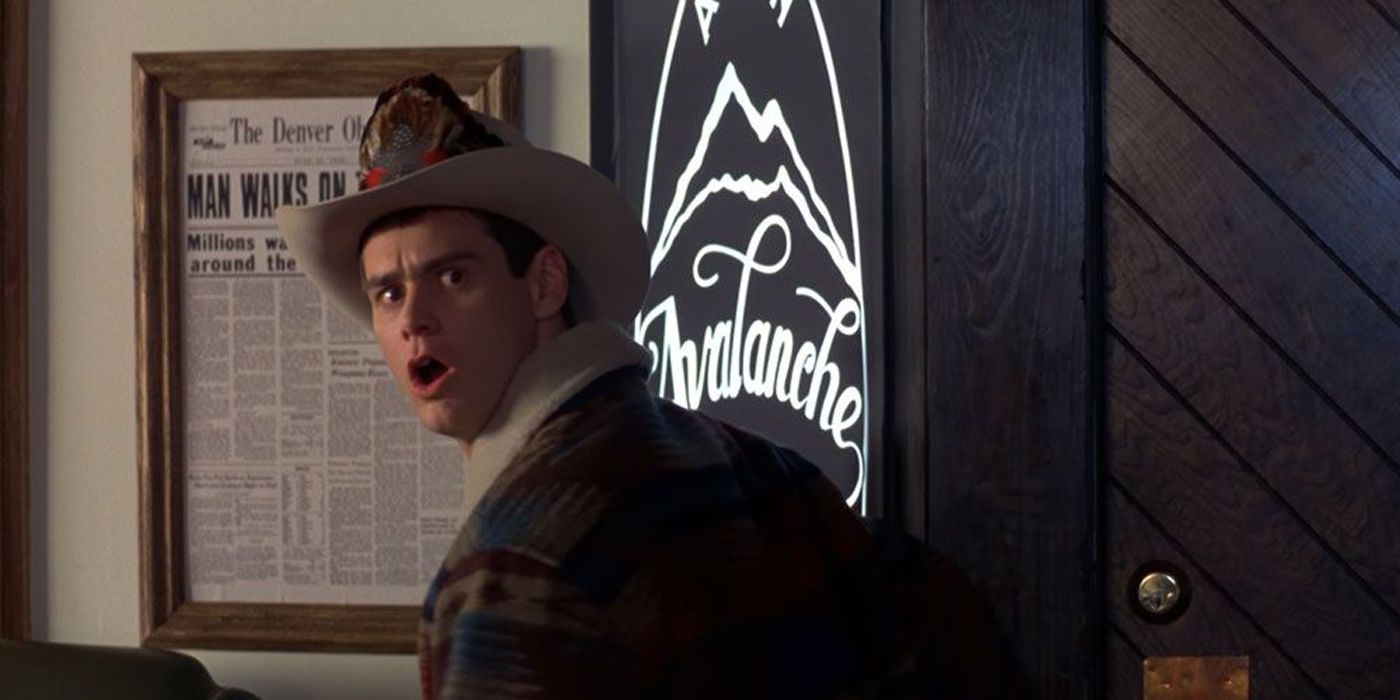

Em 1994, Idiota e mais idiota chegou às telonas e mudou o mundo da comédia para sempre, com os melhores Idiota e mais idiota citações ainda memoráveis até hoje. Lloyd Christmas (Jim Carrey) embarcou em uma jornada com seu melhor amigo Harry Dunne (Jeff Daniels) em busca do amor verdadeiro. O público adorou a celebração do diretor Peter Farrelly de dois caras sem cérebro enquanto abraçavam o espírito de aventura. Também deu origem a uma tonelada de citações atemporais que inspiraram uma eternidade sem fim de memes.

O filme viu Jim Carrey no auge de sua popularidade na década de 1990 e acrescentou um ator normalmente heterossexual em Jeff Daniels para prejudicá-lo durante todo o tempo de execução. Embora o filme tenha uma prequela e uma sequência, nenhum deles chegou perto do brilho do original, que lançou os irmãos Farrelly em superestrelas de filmes de comédia. Até os irmãos, que passaram a fazer filmes como Existe algo sobre a Mary e Eu, Eu Mesmo & Irenenão conseguiu atingir o nível de citações hilárias que este filme de estreia apresentou em seus 106 minutos de duração.

“Ei, você quer ouvir o som mais irritante do mundo?”

Lloyd faz uma pergunta honesta a Joe

Enquanto Joe Mentalino (Mike Starr) pega carona com Harry e Lloyd, ele sabe que vai dar uma volta com dois indivíduos idiotas. No entanto, ele pode ter subestimado o quão burros esses dois são. Por exemplo, em um ponto, em um dos melhores Idiota e mais idiota citações de todos eles, Lloyd pergunta a Joe: “Ei, você quer ouvir o som mais irritante do mundo?” Agora, graças a Lloyd, você ainda pode ouvir até hoje o ocasional “EEEEEEEEEEEE!” guincho. Foi um dos momentos mais irritantes de Jim Carrey no cinema.

“De acordo com o mapa, avançamos apenas 4 polegadas!”

Harry tenta ler um mapa

Harry faz esse comentário maluco sobre um mapa físico enquanto a dupla dirige. O que é surpreendente sobre o comentário ridículo de Harry não é o fato de que ele não tem idéia de que as medidas do mapa são reduzidas, é mais que ele tem alguma ideia sobre como usar um mapa. Embora as pessoas nascidas depois de 2000 provavelmente nunca tenham usado um mapa real, este continua sendo um dos melhores Idiota e mais idiota citações porque Harry leva isso um passo adiante em sua ignorância. Mesmo as pessoas que usam GPS sabem que a distância mostrada não é real.

“Eu vou pendurar no bar. Coloque para fora o Vibe!”

Lloyd Christmas pronto para impressionar

Ao pensar em galãs dos anos 90, as pessoas pensam em Brad Pitt, John Stamos ou George Clooney. No entanto, há alguém que pensa que está acima do resto – Lloyd Christmas. O homem acreditava saber como deixar as mulheres saberem que ele era solteiro e pronto para se misturar. Ele também sabia que não poderia parecer tão desesperado quando queria pegar uma mulher. Isso o levou a contar a seu amigo Harry uma das melhores Idiota e mais idiota citações, dizendo: “Vou ficar no bar. Coloque a vibe.” A fala engraçada fica ainda melhor com a atuação de Jim Carrey.

“Por que você está indo para o aeroporto? Voando para algum lugar?”

Lloyd faz conversa fiada

Quando Lloyd trabalhava como motorista, ele decidiu lançar seu próprio quebra-gelo para um cliente. No entanto, nem mesmo Lloyd percebe o quão idiota ele soou entregando um dos melhores Idiota e mais idiota citações no filme. No próprio filme, a cena fica cada vez mais idiota quando Mary Swanson (NCIS’s Lauren Holly) perguntou a Lloyd como ele descobriu. Foi quando Lloyd mostrou que não era tão burro quanto a maioria das pessoas pode acreditar. “Bem, eu vi sua bagagem. Então, quando vi a passagem aérea, somei dois mais dois.”

“Áustria! Bem, então… ‘Bom dia, companheiro! Vamos colocar outro camarão na Barbie!’”

Lloyd deixa a Áustria e a Austrália confusas

Lloyd claramente não é o mais brilhante, evidenciado por essa mistura de países com sons semelhantes. Quando se trata de Lloyd e seu melhor Idiota e mais idiota citações, ele não apenas os confundiu, mas pareceu um completo idiota para todos quando o fez. Quando Lloyd encontrou alguém que era da Áustria, ele decidiu tentar imitar seu dialeto. No entanto, ele gritou “bom dia, cara. Vamos colocar outro camarão na barbie”, que é uma forma de zombar do dialeto australiano. A única pessoa ridicularizada aqui foi Lloyd.

“Belo conjunto de Hooters que você tem aí.”

Harry está impressionado com Hooters

Enquanto Lloyd é o tipo de pessoa que pensa que pode “vibrar” no bar e as mulheres virão até ele (elas não vêm), Harry é muito menos seguro em sua disposição de abordar mulheres. Quando o faz nessa mesma festa, entrega um dos melhores Idiota e mais idiota linhas, mas o faz de uma maneira completamente inocente. Quando Mary (Lauren Holly) está sozinha, Harry se aproxima e diz “belo conjunto de vaias que você tem aí”. Enquanto ela estava surpresa, ele estava falando sobre um par de corujas que ela estava olhando em uma gaiola.

“Chute a bunda dele, robalo!”

Camafeu do Robalo

Para o povo de Boston, Cam Neely sempre será uma lenda do hóquei, terminando com uma carreira histórica no hóquei. Para todos fora de Massachusetts e do mundo do hóquei, ele é simplesmente conhecido como Sea Bass. É uma participação especial que um grupo seleto pode apreciar plenamente, mas qualquer um que tenha visto Idiota e mais idiota conhece Sea Bass por cuspir no hambúrguer de Harry depois de ser atingido na cabeça por um saleiro. Quando Sea Bass se aproxima da mesa de Harry e Lloyd, um de seus amigos gritou um dos melhores Idiota e mais idiota citações. E ainda se mantém hoje em praticamente qualquer ambiente.

“Só quando eu penso que você não poderia ser mais burro…”

Harry parece pronto para atacar Lloyd

O melhor Idiota e mais idiota citações são rápidas. Alguns segundos no máximo. Este dura cerca de 12 segundos, mas ainda continua sendo um dos grandes nomes da Idiota e mais idiota. Jeff Daniels teve alguns papéis impressionantes ao longo dos anos, ramificando-se bem fora da comédia. No entanto, este pode ser seu maior momento como ator de todos os tempos. Pela primeira vez, parece que Harry está prestes a perdê-lo para Lloyd. Nove segundos depois do que parece um pai repreendendo seu filho, o público foi lembrado exatamente como Harry é burro. “Logo quando eu penso que você não poderia ser mais burro, você vai e faz algo assim… e se redime totalmente!”

“Então você está me dizendo que há uma chance!”

Lloyd permanece sempre otimista

Lloyd começou com uma pergunta para Mary. Ele perguntou: “Quais são as chances de um cara como você e uma garota como eu … terminarem juntos?” Harry e Lloyd percorreram um longo caminho para encontrar Mary e deixá-la saber como ele se sente. Quando ela disse que as chances “não são boas”, ele pergunta se isso significa uma chance em cem. Ela disse que era mais como uma em um milhão, e isso deixou Lloyd feliz. Ele sorriu e disse: “então você está me dizendo que há uma chance” antes de gritar. A linha é tão engraçada que se tornou um meme popular.

“Se eu a conheço tão bem quanto penso, ela vai nos convidar para um chá e prostitutas!”

Harry errou em outra referência cultural

Harry e Lloyd rotineiramente erraram, especialmente quando se tratava de referências culturais. Ao decidir sobre um plano para conhecer Mary Swanson, Lloyd confia em uma superabundância de confiança, mesmo que isso o deixe parecendo mais burro do que nunca. Uma prostituta é uma prostituta, o que está muito longe de sua referência cultural pretendida em relação ao convite de convidados para um chá e bolinhos, de onde veio o ditado original. Muito parecido com a confusão austríaca, isso prova que Lloyd sempre tem certeza de que tem uma ótima fala, mesmo quando não tem ideia do que está falando.

“Não temos comida! Não temos empregos! As cabeças de nossos animais de estimação estão caindo!!”

Lloyd sobre como sua sorte piorou

Já sem sorte e sem trabalho, Harry e Lloyd chegaram ao limite quando dois bandidos os espionaram em um caso de identidade trocada. Antes de sair de casa, os bandidos deixaram um pequeno presente de despedida em favor de um pássaro morto cuja cabeça eles torceram. Os dois amigos infelizes voltaram para casa para encontrar o pássaro morto na gaiola, e foi a gota que quebrou as costas do camelo. Depois que Lloyd, de Jim Carrey, entregou um dos melhores Idiota e mais idiota citações, foi a desculpa final que eles precisavam para fazer uma viagem cross-country para Aspen em busca de pastos mais verdes e em busca do amor de sua vida de Lloyd.

“Com licença, Flo?”

Muitos espectadores mais jovens podem não entender o significado dessa piada, e esse foi o caso em 1994. Lloyd trolls a garçonete da lanchonete com essa pergunta, chamando-a de Flo, fazendo Harry ter um ataque de riso histérico. A citação faz referência à sitcom Alice de 1976, estrelada por Linda Lavin como uma garçonete chamada Alice Hyatt. Ela tinha uma colega de trabalho ruiva mal-humorada no restaurante interpretada por Polly Holliday chamada Florence Jean “Flo” Castleberry. Com eles constantemente chamando-a de “Flo”, era uma piada que quase ninguém entendia fora do par.

“Eu apenas pensei que ela era uma alcoólatra furiosa!”

Lloyd aborda Harry sobre ele se encontrar com Mary

Quando Lloyd pega Harry saindo com Mary Swanson depois de prometer marcar um encontro para os dois, seu mundo se despedaça. Em vez de confrontar Harry sobre sua traição, Lloyd decide esperar e ver como seu ex-melhor amigo reagirá. Depois de perguntar a Lloyd por que Mary iria querer encontrá-lo em um bar às 9h em vez de 21h, Lloyd oferece uma resposta perfeita que trai sua própria superficialidade e visões de cabeça vazia sobre a vida. Em um dos melhores Idiota e mais idiota citações, ele apenas assumiu algo incorreto sobre ela.

“De jeito nenhum! Nós pousamos na lua!”

Lloyd aprende a história americana

Afogando suas mágoas no bar depois de pensar que Mary Swanson o deu um bolo, Lloyd espera sem sucesso. Por fim, o barman dá a ele o endereço de onde Mary está hospedada para que ele possa ir encontrá-la lá. Animado além da crença, Lloyd se prepara para sair correndo do bar antes de ver uma foto emoldurada do pouso lunar da Apollo. Evidentemente, incapaz de acompanhar os eventos atuais, Lloyd grita o maior triunfo da América para uma multidão confusa. Em um dos melhores Idiota e mais idiota citações, Lloyd provou que não sabe quase nada fora de sua própria bolha pessoal.

“Você vendeu meu pássaro morto para um garoto cego?”

Lloyd fará qualquer coisa por dinheiro

Fazendo um orçamento cuidadoso para sua aventura cross-country em Aspen, Harry e Lloyd param para pegar alguns itens para a viagem. Harry percebe Lloyd comendo alguns lanches que ele acredita não fazer parte do orçamento. Quando Lloyd menciona que levantou $ 25 dólares vendendo algumas coisas para um garoto cego chamado Billy, Harry fica desconfiado. Eventualmente, Lloyd derrama o feijão, admitindo que vendeu o pássaro morto de Harry, Petey, para Billy antes de fugir da cidade. Quando Harry lembra a Lloyd que Petey não tem mais cabeça, o primeiro garante que ele cuidou dela de uma maneira horrível. Idiota e mais idiota momento.

.