.

Aviso! Este artigo contém spoilers de Star Wars #35 Tanto os Jedi quanto os Fallanassi são grupos antigos sensitivos à Força que ocasionalmente influenciaram as habilidades de uso da Força uns dos outros durante todo o processo. Guerra das Estrelas cânone. Agora, uma nova faceta de seu relacionamento que remonta aos dias da Velha República foi revelada, confirmando um propósito secreto com esta antiga aliança.

Os Fallanassi eram uma ordem religiosa que adorava a Força, embora ‘a Força’ não fosse como eles a chamavam. Eles viam a Força mais como um mar cósmico através do qual todas as coisas fluem e refluem. Os Fallanassi chamavam o lado claro da Força de ‘Corrente Branca’, e o lado escuro de ‘Maré Negra’. Este ponto de vista levou os Fallanassi a manter uma consideração muito menos focada na batalha pela Força, algo que é claramente demonstrado por sua recusa em empunhar sabres de luz. No entanto, isso não significa que os Fallanassi desaprovam totalmente os sabres de luz. Na verdade, Guerra das Estrelas‘ A última aventura confirma que os Fallanassi realmente desempenharam um papel importante na readquirição dos preciosos cristais kyber que foram sangrados pelos Sith, e eles fizeram isso purificando esses cristais para os Jedi.

Cristais Kyber vermelhos purificados Fallanassi de Star Wars para os Jedi

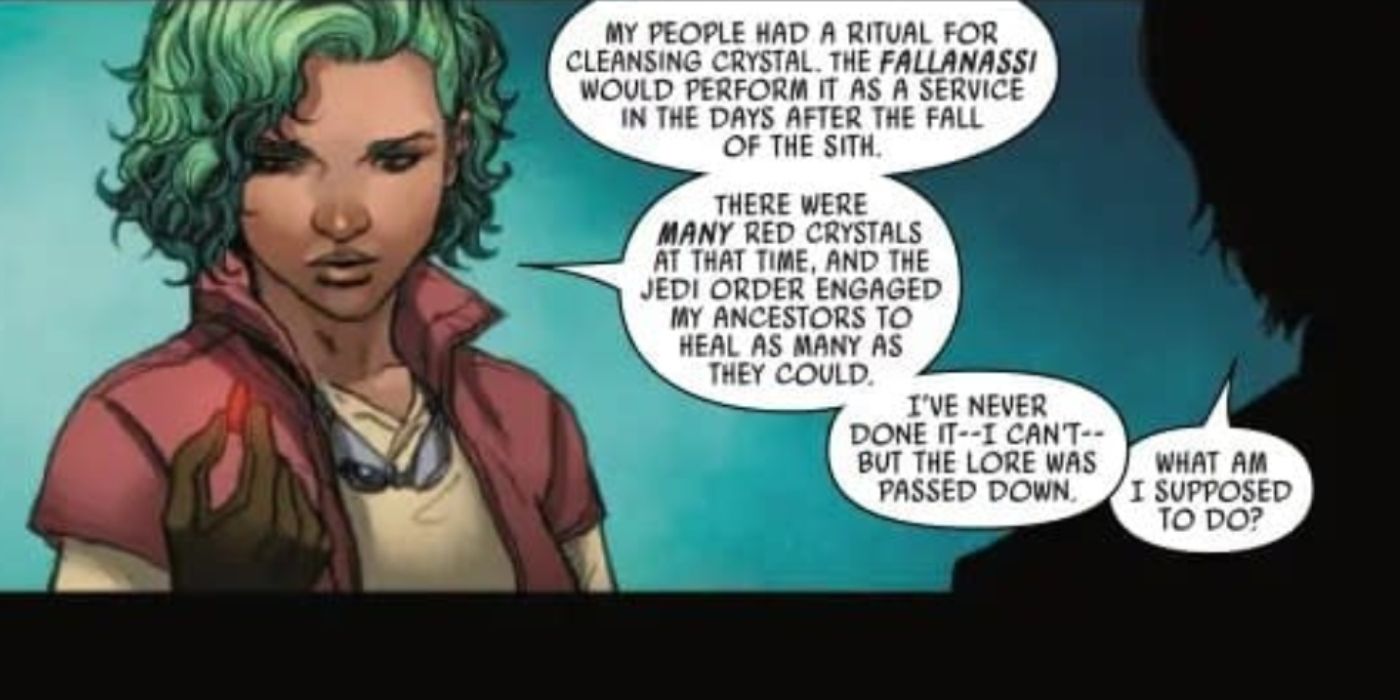

Conforme mostrado em uma prévia exclusiva de multiversitycomics.com de Guerra das Estrelas # 35 de Charles Soule e Madibek Musabekov, Luke Skywalker se aliou a uma mulher Fallanassi chamada Gretta, bem como ao especialista em kyber, Dr. Cuata. Algumas edições antes, o sabre de luz amarelo de Luke Skywalker foi esmagado na mão de um Killdroid, quebrando o cristal kyber dentro e tornando o sabre de luz quase inutilizável. Então, como teste, o Dr. Cuata deu a Luke um cristal kyber vermelho que ele tinha em sua coleção, e ele o fez para ver se Luke poderia usar o lado luminoso da Força para purificá-lo – certamente para usá-lo em um novo sabre de luz. Luke nunca tinha ouvido falar de algo assim antes, mas Gretta sim. Gretta explica que seu povo, os Fallanassi, purificariam cristais kyber sangrados após a queda dos Sith, permitindo que os cristais recém-limpos fossem usados mais uma vez pelos Jedi.

Nos dias da Velha República, havia milhares de Sith para rivalizar com uma próspera Ordem Jedi. O conflito entre as duas entidades devastou a galáxia, mas não mais do que nas fileiras dos Sith especificamente. Enquanto lutavam contra os Jedi, os Sith lutavam constantemente entre si, pois cada um deles procurava elevar sua própria posição na conquista sem fim por mais poder. Por causa disso, Darth Bane promulgou a Regra de Dois Sith e, com o estabelecimento dessa regra, os Sith foram quase extintos. Isso deixou um grande número de sabres de luz vermelhos sem manejadores, todos contendo cristais kyber que foram sangrados com o lado negro. Em vez de simplesmente destruir milhares de cristais kyber, os fãs de Star Wars agora sabem que os Jedi tiveram a ajuda dos Fallanassi para recuperar esses cristais sangrados.

Este ato de serviço significou muito para os Jedi devido ao fato de que agora eles poderiam usar os cristais em seus sabres de luz mais uma vez, mas também foi um serviço para a própria Força. Os Fallanassi são servos da Força e seguem seu fluxo cósmico. Eles buscam apenas honrar sua glória com quase nenhum desejo de canalizar os poderes que a Força oferece (como os Jedi ou os Sith). Os cristais Kyber são condutos da Força e, sempre que são sangrados, são mantidos em um estado de agonia perpétua muito real. Ao purificá-los, os Fallanassi estão curando os cristais e, por extensão, a Força dentro deles. Coincidentemente, esse ato de bondade em homenagem à Força foi algo benéfico para os Jedi também, então os Fallanassi ficaram felizes em contribuir. Assim, a antiga aliança entre Guerra das Estrelas‘ Jedi e Fallanassi com o propósito de purificar cristais kyber vermelhos nasceram.

Guerra das Estrelas #35 da Marvel Comics estará disponível em 7 de junho.

Fonte: multiversitycomics.com

.